Quelle est la différence entre RTX 4090 et DGX Spark – Analyse comparative pour les entreprises réfléchissant à une infrastructure AI sur site

Si vous êtes une entreprise ou un développeur envisageant de construire une infrastructure AI, vous vous êtes sûrement déjà posé cette question : « Est-ce que le RTX 4090 est suffisant, ou ai-je vraiment besoin du DGX Spark ? »

Ce texte est une exploration prudente de cette question. En tant que personne qui attend la livraison de ma commande de DGX Spark, j'ai rassemblé mes réflexions basées sur les limites et les attentes que j'ai ressenties en utilisant un environnement basé sur RTX 4090.

Serveur GPU vs Station de travail hautes performances – Quelle infrastructure est la mieux adaptée à l'optimisation AI ?

| Catégorie | Station de travail RTX 4090 | DGX Spark |

|---|---|---|

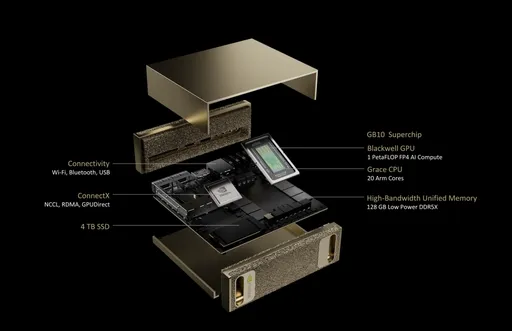

| Architecture GPU | Ada Lovelace | NVIDIA Blackwell |

| CPU | Utilise un CPU externe | 20 cœurs Arm (10×Cortex-X925 + 10×Cortex-A725) |

| Mémoire | 24 Go GDDR6X | 128 Go LPDDR5x (mémoire unifiée) |

| Largeur de bande mémoire | 1 008 Go/s | 273 Go/s |

| Stockage | SSD configuré par l'utilisateur | 1 To ou 4 To NVMe M.2 (avec support de cryptage) |

| Réseau | Optionnel | 10GbE + ConnectX-7 Smart NIC |

| Consommation d'énergie | Environ 450W~600W | 170W |

| Taille du système | ATX ou tour | 150 x 150 x 50,5 mm (1,2 kg) |

| Système d'exploitation | Installation par l'utilisateur de Windows ou Linux | NVIDIA DGX Base OS (basé sur Ubuntu) |

▶ Principale différence : au-delà de la simple performance, « est-il conçu pour l'AI ? » est la question clé.

Différence importante dans l'industrie : optimisation des infrastructures AI sur site

Pour une entreprise envisaging d'adopter une infrastructure AI, ce qui importe n'est pas seulement la vitesse de traitement. Ce sont les différences adaptées à l'industrie qui déterminent réellement le choix :

- Sécurité des données AI et souveraineté des données : essentiel pour le traitement des données qui ne peuvent pas être envoyées vers le cloud

- Déploiement AI en périphérie : forte demande de serveurs GPU privés dans les secteurs de la fabrication, de la finance et de la santé

- Stabilité des inférences AI : conception d'alimentation de niveau serveur permettant un fonctionnement d'inférence 24/7

- Intégration en cluster : la structure Grace CPU + Blackwell GPU permet des calculs à haute densité sur une seule machine

Dans cette perspective, le DGX Spark n'est pas simplement un équipement GPU, mais une solution AI privée sur site.

Coût total de possession (TCO) et efficacité d'investissement – Quel est le ROI de l'infrastructure AI sur site ?

| Critère de comparaison | Système unique RTX 4090 | DGX Spark |

|---|---|---|

| Prix du matériel initial | Environ 3 500 $ à 5 000 $ | 4 000 $ (selon les annonces officielles de NVIDIA) |

| Coûts opérationnels | Gestion interne en prenant en compte l'énergie et la chaleur | Conception à faible consommation d'énergie basée sur ARM pour l'efficacité énergétique et la réduction des coûts de maintenance |

| Objet d'investissement | Projets individuels ou expérimentations à petite échelle | Plateforme d'apprentissage/inférence pour entreprises |

▶ Les prix sont similaires ou le DGX Spark est même moins cher, mais si l'on tient compte de l'efficacité opérationnelle et de la valeur d'intégration du système, le coût total de possession (TCO) est compétitif sur le long terme.

Développeur individuel ? Startup ? Qui est le plus adapté ?

- Cas où le RTX 4090 est plus adapté :

- Taille des modèles petite, principalement pour l'apprentissage et l'expérimentation individuels

- Développeurs utilisant une approche hybride avec le cloud

-

Freelances/recherche sensibles aux coûts

-

Cas où le DGX Spark est approprié :

- Déploiement/interpolation LLM sur site, entreprises nécessitant la protection de la souveraineté des données

- Utilisateurs industriels souhaitant maximiser le ROI par rapport au cloud

- Équipes souhaitant gérer un service d'inférence 24 heures sur 24

Conclusion : Actuellement "en attente", mais les critères de choix sont clairs

Le RTX 4090 reste un GPU formidable à ce jour. Cependant, j'attends avec impatience la "normalisation des serveurs AI" que le DGX Spark promet.

Ce qui est plus important qu'une simple vitesse accrue est : - Sur quelle architecture l'AI sera-t-elle basée ? - Comment construire une infrastructure AI de manière sûre, durable et rentable ?

En attendant le jour où je pourrai partager mon expérience directe, j'espère que cette comparaison servira de critère pour un choix éclairé.

Aucun commentaire.