Dans nos deux précédents articles, nous avons exploré en profondeur l'histoire de l'architecture des CPU (x86, x64) et l'émergence de l'ARM. Aujourd'hui, nous allons parler d'une entreprise qui se tient au sommet de toutes ces discussions sur les CPU, une entreprise qui est récemment devenue un sujet brûlant : NVIDIA.

NVIDIA a régné sans partage sur le marché des GPU (unités de traitement graphique) pendant longtemps. Cependant, récemment, ces derniers ont élargi leur influence au-delà des GPU jusqu'au marché des CPU, redéfinissant ainsi l'avenir de l'informatique. Pourquoi NVIDIA fabrique-t-elle des CPU et quelle importance cela a-t-il à l'ère de l'IA ? Découvrons-le ensemble.

1. NVIDIA n'était-elle pas à l'origine une entreprise de GPU ? Quel rapport avec le CPU ?

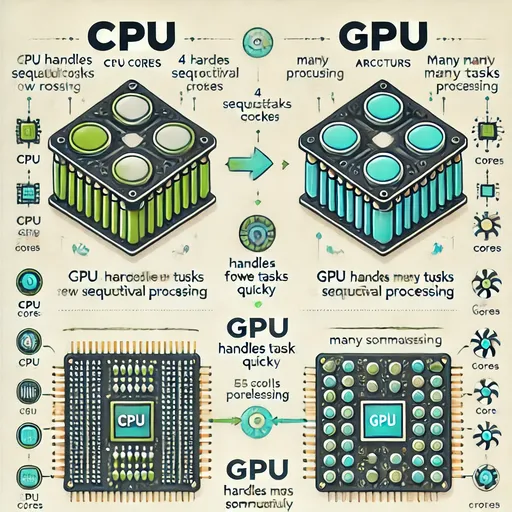

Oui, c'est exact. NVIDIA est principalement connue pour ses GPU GeForce (jeux) et Quadro/RTX (professionnels), ainsi que plus récemment pour sa série de GPU A/H pour data center. Les GPU traitent les calculs différemment des CPU.

-

CPU : Spécialisé dans le traitement rapide et efficace de tâches uniques, séquentielles et complexes. (Ex : exécution du système d'exploitation, traitement de documents, navigation web)

-

GPU : Très puissant pour traiter des calculs massifs, simples mais répétitifs, en faisant fonctionner des milliers de petits cœurs en parallèle. (Ex : rendu graphique, simulation physique, et apprentissage/inférence en intelligence artificielle)

Pendant longtemps, les CPU et les GPU ont complété les rôles de l'autre pour constituer des systèmes informatiques. Le CPU était le 'cerveau' dirigeant du système, tandis que le GPU traitait les tâches nécessitant des graphismes ou des calculs parallèles comme un 'expert'.

Cependant, avec l'avènement de l'ère de l'intelligence artificielle (IA), leur relation a commencé à changer. Les travaux en IA nécessitant d'apprendre d'énormes quantités de données et de calculer des réseaux neuronaux complexes seraient presque impossibles sans la capacité de traitement parallèle des GPU. NVIDIA a rapidement compris ce potentiel et a développé une plateforme de calcul parallèle appelée CUDA, ouvrant ainsi la voie à l'utilisation des GPU comme dispositifs de calcul génériques au-delà de simples cartes graphiques.

2. Les limites des GPU et le besoin de CPU : l'inefficacité du 'déplacement des données'

Il est clair que les GPU sont au cœur du calcul IA, mais le transfert de données entre CPU et GPU reste une cause de goulot d'étranglement.

- Transfert de données CPU ↔ GPU : Lors de l'apprentissage ou de l'inférence d'un modèle IA, le CPU prépare les données, le GPU effectue les calculs sur ces données et renvoie les résultats au CPU. Ce processus de déplacement de données consomme beaucoup plus de temps et d'énergie que prévu. Lorsque le CPU et le GPU sont physiquement éloignés, les interfaces utilisées pour le transfert de données, comme le PCIe (PCI Express), peuvent ne pas suivre la vitesse de traitement incroyable des GPU.

NVIDIA a commencé à voir la nécessité d'un CPU dédié à côté des GPU pour surmonter ces limitations et fournir des solutions de calcul optimisées pour l'ère IA. Peu importe à quel point un GPU est exceptionnel, sans un CPU capable de soutenir efficacement le GPU et d'échanger rapidement des données, l'efficacité du système entier ne pourra qu'en pâtir.

3. L'émergence du CPU de NVIDIA : le processeur 'Grace' basé sur ARM

Au lieu de développer directement des CPU x86, NVIDIA s'est intéressée à l'architecture ARM, qui offre une excellente efficacité énergétique et une personnalisation facile. En 2022, elle a officialisé son entrée sur le marché des CPU avec l'annonce du 'NVIDIA Grace', un CPU destiné aux data centers.

-

Basé sur ARM Neoverse : Le CPU Grace est conçu sur la base des cœurs de serveur 'Neoverse' d'ARM. Cela reflète une stratégie selon laquelle NVIDIA choisit d'utiliser une technologie éprouvée de l'ARM pour entrer rapidement sur le marché plutôt que de plonger directement dans la conception de cœurs CPU.

-

Le cœur de la stratégie 'superchip' : La véritable force du CPU Grace se manifeste lorsqu'il est combiné avec le GPU de NVIDIA sous la forme d'un 'superchip', dépassant ainsi les performances d'un CPU seul.

-

Superchip Grace Hopper : C'est un produit qui connecte le CPU Grace au puissant GPU H100 Hopper via un interconnexion ultra-rapide appelée NVLink-C2C. Cette connexion fournit une bande passante beaucoup plus rapide que le PCIe existant (plus de 900 Go/s), minimisant ainsi les goulots d'étranglement de données entre le CPU et le GPU.

-

Superchip Grace Blackwell : Une forme combinée du dernier architecture de GPU Blackwell et du CPU Grace, conçue pour des charges de travail IA et HPC (calcul haute performance) de nouvelle génération.

-

Cette stratégie de 'superchip' démontre la vision de NVIDIA de construire un système d'intégration beaucoup plus efficace et puissant, en fournissant directement des CPU personnalisés optimisés pour le calcul GPU, plutôt que d'utiliser séparément des CPU x86 et des GPU NVIDIA.

4. Les bouleversements sur le marché des CPU et les perspectives d'avenir

L'émergence du CPU Grace de NVIDIA forme un nouveau schéma concurrentiel dans le marché des CPU, qui était précédemment divisé entre x86 (Intel, AMD) et ARM (Qualcomm, Apple, etc.).

-

Optimisation pour l'ère de l'IA : NVIDIA se concentre sur des CPU pour data centers spécialisés dans les charges de travail IA et HPC, plutôt que sur le marché des CPU généralistes. C'est une stratégie pour répondre à la demande de calcul IA qui connaît une croissance explosive à l'échelle mondiale.

-

Concurrence et coopération : Intel et AMD sont dans une relation complexe, en concurrence avec NVIDIA sur le marché des accélérateurs AI tout en devant continuer à développer des CPU x86 fonctionnant bien avec les GPU de NVIDIA. Des rumeurs circulent selon lesquelles NVIDIA pourrait, dans certains cas, avoir recours aux services de fonderie d'Intel, illustrant divers modèles de coopération et de concurrence pour le développement technologique et l'occupation de marché.

-

Importance des solutions intégrées : À l'avenir, il ne suffira plus de se concentrer sur les performances individuelles des composants, mais il sera crucial de voir comment CPU, GPU, mémoire et interconnexion s'intègrent organiquement pour offrir des performances optimisées pour des charges de travail spécifiques. La stratégie 'superchip' de NVIDIA est un exemple représentatif de ces solutions intégrées.

Conclusion

Aujourd'hui, nous avons examiné pourquoi le géant des GPU NVIDIA s'est aventuré dans le marché des CPU et comment, à travers le CPU 'Grace' et la stratégie des 'superchips', elle tente de transformer le paradigme du calcul à l'ère de l'IA. Au-delà de l'histoire de l'évolutions des rôles respectifs des CPU et GPU, il est clair que nous avançons vers une intégration plus étroite et plus complète.

Nous attendons de voir quelles résultats et changements l'assaut de NVIDIA sur le marché des CPU apportera, comment les acteurs historiques de l'x86 réagiront, et finalement à quoi ressemblera l'avenir du calcul IA. Dans le prochain post, nous vous retrouverons avec une autre histoire technologique fascinante. Merci !

Aucun commentaire.