Ceux qui visitent cet article cherchent probablement à commencer le développement de l'apprentissage profond en utilisant un GPU.

Cet article est un guide pratique documentant le processus de préparation des opérations GPU basées sur CUDA dans un environnement Ubuntu.

Il est particulièrement conçu pour les débutants qui souhaitent vérifier si CUDA est correctement installé sur leur PC.

Pour ceux qui se demandent ce qu'est CUDA, je vous recommande de lire d'abord l'article précédent Qu'est-ce que CUDA ? Introduction au GPU et au calcul parallèle.

1. Pourquoi configurer un environnement GPU ?

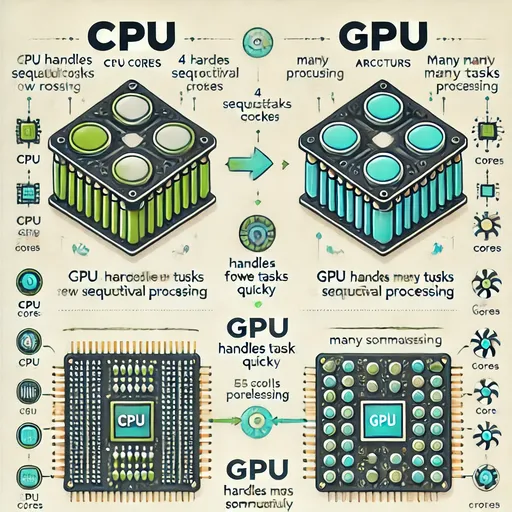

L'apprentissage des modèles d'IA nécessite un grand nombre d'opérations matricielles.

Ces opérations sont effectuées beaucoup plus rapidement sur un GPU spécialisé dans le calcul parallèle que sur un CPU.

Cependant, avoir un GPU ne suffit pas.

Il faut un driver pour faire reconnaître le GPU par le système d'exploitation,

le CUDA pour permettre les opérations sur le GPU,

et une bibliothèque optimisée pour l'apprentissage profond appelée cuDNN.

Ces trois éléments doivent être correctement installés pour utiliser le GPU.

2. Vérifier l'état de mon GPU – ai-je un driver et CUDA ?

nvidia-smi

Ceci est un outil qui montre l'état actuel du GPU.

Si vous voyez la version CUDA et le nom du GPU de manière précise,

cela signifie que le GPU est correctement reconnu et que le driver est installé.

3. Outil de développement CUDA – pourquoi ai-je besoin de nvcc ?

nvcc est l'outil permettant de compiler le code CUDA (.cu).

Pour faire une analogie, c'est le compilateur nécessaire pour “utiliser réellement CUDA”.

sudo apt update

sudo apt install nvidia-cuda-toolkit

nvcc --version

4. cuDNN – l'arme secrète pour exécuter rapidement des opérations d'apprentissage profond sur un GPU

cuDNN est une bibliothèque de calcul numérique à grande vitesse dédiée à l'apprentissage profond, développée par NVIDIA.

Elle permet de calculer de manière très rapide et efficace sur un GPU des opérations telles que :

- Convolution

- Pooling

- RNN

- LSTM

- BatchNorm

- Activation

Si vous envisagez d'utiliser des frameworks d'apprentissage profond (PyTorch, TensorFlow, etc.), c'est une bibliothèque vraiment indispensable.

Vous devez installer le paquet cuDNN correspondant à votre version de CUDA pour que le framework puisse utiliser efficacement le GPU.

La méthode de téléchargement du paquet cuDNN peut varier selon le système d'exploitation et l'architecture CPU, donc lorsque vous le téléchargez, assurez-vous de visiter la page officielle de téléchargement de cuDNN de NVIDIA et de télécharger et installer la bibliothèque correspondant à votre configuration.

Lien de téléchargement de NVIDA cuDNN

Lors du téléchargement de cuDNN via le lien ci-dessus, assurez-vous de confirmer la version de CUDA que vous avez vérifiée avec nvidia-smi pour installer la bonne version de cuDNN.

5. Test – vérifions si le GPU fonctionne en Python

Une fois installé, voyons s'il fonctionne correctement.

import torch

print(torch.cuda.is_available()) # True

print(torch.cuda.get_device_name(0)) # NVIDIA GeForce RTX XXXX

6. Résumé

| Éléments | Votre action | Pourquoi vous avez fait cela |

|---|---|---|

| Driver NVIDIA | Vérifier l'état de l'installation (nvidia-smi) |

Reconnaissance du GPU par le système |

| CUDA Toolkit | Installer nvcc |

Compilateur pour exécuter le code CUDA |

| cuDNN | Installer cudnn-cuda-12 |

Bibliothèque d'optimisation des calculs d'apprentissage profond |

| Test PyTorch | Vérifier l'intégration GPU | Valider que des calculs réels peuvent être effectués |

7. Conclusion de Jesse

Votre système est maintenant prêt pour effectuer des opérations de calcul GPU.

Vous pourrez rapidement entraîner ou exécuter divers modèles tels que Whisper, LLaMA, ChatGPT avec cet environnement.

Aucun commentaire.