Опыт работы с LLM (Large Language Model) в локальной среде сильно зависит от характеристик оборудования. В последние несколько лет, используя модели GGUF на ПК среднего уровня, я столкнулся с определёнными ограничениями. Теперь, с переходом на высокопроизводительную рабочую станцию Spark (DGX Spark), я хочу поделиться своим опытом и изменениями в локальной исследовательской среде ИИ.

1. Эпоха GGUF: эстетика компромисса и эффективности

Перед внедрением Spark моё основное оборудование состояло из i7 12700F CPU, 32GB RAM и RTX 2060 12GB. В этих условиях единственным выбором для запуска огромных языковых моделей был GGUF (GPT-Generated Unified Format).

Тугая квантования (Quantization)

Критерием выбора модели тогда была не производительность, а 'возможность запуска'. При поиске на Hugging Face я привычно искал тег GGUF, среди которых особенно выделялся Q4_K_M формат.

- Q4_K_M: Формат, который сжимает параметры модели до 4 бит, уменьшая использование памяти и минимизируя падение производительности.

12GB VRAM RTX 2060 позволял запустить модель всего на 7B, или же использовать системы для временной выгрузки (Offloading), что вело к медленной скорости. Я испытывал удовлетворение от самого факта работы, но это явно было компромиссом.

2. Ограничения простого вывода (Inference) и сомнения

Запуск LLM локально с помощью GGUF был интересен, но вскоре я столкнулся с фундаментальным вопросом.

"Если мне нужно только делать выводы, действительно ли мне нужна локальная среда?"

Если цель заключается в простом вопросах и ответах и генерации текста, уже существуют Google Gemini или OpenAI GPT, демонстрирующие впечатляющую производительность. Стоимость API для исследований может быть значительно ниже затрат на строительство личной рабочей станции. Выполнение только вывода, без обучения или изменений, делает целесообразность локальной среды сомнительной.

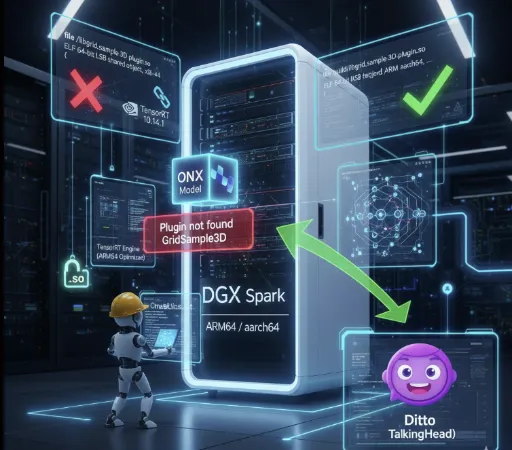

3. Внедрение Spark и мир FP16

Инвестировав около 4,000 долларов в машину Spark, моя среда исследований ИИ полностью изменилась. Первым делом изменилось моё отношение к моделям.

Safetensors и полная точность

Теперь я уже не ищу GGUF. Я просто скачиваю оригинальную модель на основе FP16 (Half Precision) с .safetensors.

Скорость и качество: Качество вывода оригинальной модели без потерь при квантовании явно отличается. Благодаря высокопроизводительному GPU скорость вывода также дарит комфорт.

- Фактическая разница в скорости очевидна.

- Среда RTX 2060: Mistral 7B GGUF Q4_K_M → около 10–20 tokens/s

- Среда Spark (GPT-OSS-20B FP16): около 80–90 tokens/s

- Среда Spark (GPT-OSS-120B FP16): около 40–50 tokens/s

На подобном уровне скорости в ноутбуках или ПК невозможно достичь, даже используя FP16 модели без потерь при квантовании, что полностью меняет парадигму локальных исследований ИИ.

Гибкая квантование: Если это необходимо, я сам пробую квантование до FP8 или FP4. Я больше не использую готовые файлы, а контролирую процесс в соответствии с моими целями исследований.

4. Истинная ценность: LoRAFine-Tuning

Я считаю, что решение о внедрении Spark было "действительно правильным", потому что оно открыло территорию обучения (Training).

Ранее, даже вывод был слишком сложным, чтобы мечтать о fine-tuning. Но теперь я могу применять LoRA (Low-Rank Adaptation), о которой учил только по теории.

-

Практический опыт: Подготовка набора данных, настройка гиперпараметров и тонкая настройка модели предоставляют опыт глубже, чем просто вывод.

-

Моя модель: Возможность создавать модели, адаптированные под конкретные домены или мой стиль, является истинным очарованием локальной среды.

Среда, позволяющая перейти от вывода к обучению, вот почему расходы в 4,000 долларов не кажутся неоправданными.

5. По-прежнему актуальные ценности GGUF

Конечно, мои условия изменились, но это не значит, что я отрицаю ценности GGUF.

Суть GGUF не в ‘абсолютной производительности’, а в доступности.

Это единственный формат, который позволяет запускать большие языковые модели на CPU или низкопроизводительных GPU без необходимости в дорогих GPU. Однако, из-за особенностей квантования возможны потери точности и ухудшение качества вывода, а также нестабильность при обработке длинного контекста. Таким образом, GGUF имеет преимущество "моделей, которые могут запускаться всеми", но в то же время несет "ограничения по качеству, скорости и согласованности".

Кроме того, GGUF по-прежнему является отличным форматом с точки зрения демократизации ИИ. Не все пользователи нуждаются в fine-tuning, и не у всех есть возможность иметь дорогое оборудование. Экосистема GGUF, обеспечивающая оптимальную производительность вывода для легких пользователей в стандартизированной среде, продолжит развиваться вместе с улучшением производительности персональных ПК. Возможно, через несколько лет модели формата gguf будут работать на планшетах или наших мобильных телефонах.

В заключение

Если время, проведенное за запуском модели Q4_K_M на RTX 2060, было “пробой”, то сейчас, с Spark, это ощущается как “приготовление”.

Мир локального ИИ предлагает не только запуск моделей, но и возможность понимать, изменять и делать их своими собственными. Если вы испытываете жажду понимания структуры модели и кастомизации, выходящей за рамки простого вывода, инвестиции в оборудование будут наиболее надежным ключом к его удовлетворению.

Комментариев нет.