Теперь ИИ - это не привилегия огромных облачных серверов, а технология, которую можно достаточно удобно использовать на личном ноутбуке или настольном компьютере. Одной из ключевых технологий, сделавших такие изменения возможными, является проект llama.cpp, а в центре его внимания находится GGUF (GPT-Generated Unified Format).

В этой статье мы глубоко рассмотрим структурные особенности и философию дизайна GGUF, а также выясним, почему этот формат стал стандартом в экосистеме локальных LLM.

1. Что такое GGUF?

GGUF - это новое поколение формата GGML (Geroge Georgiev Machine Learning), разработанного командой llama.cpp, представляющее собой объединенный формат файлов модели.

Если первоначальный GGML был просто структурой для хранения тензоров (весов), то GGUF предлагает новый уровень архитектуры для "упаковки" модели в полном объеме.

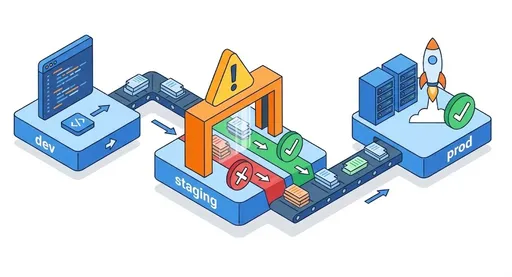

Существующие файлы PyTorch .pth или Hugging Face .safetensors просто хранят веса модели. Поэтому на этапе загрузки требовалось отдельно загружать токенизатор, конфигурационный файл и информацию об архитектуре, а это также подразумевало необходимость настройки GPU и сложной среды CUDA.

С другой стороны, GGUF объединяет веса + метаданные + токенизатор + гиперпараметры в одном бинарном файле.

Таким образом, "перемещение модели" превращается из сложной задачи, включающей код или настройки, в просто копирование одного файла.

Фоном для такого дизайна является философия «полноты загрузки (Complete Loadability)». То есть один и тот же GGUF файл должен работать одинаково на любом оборудовании.

2. Ключевые технические особенности GGUF

GGUF - это не просто формат, это своего рода парадигма системного дизайна для эффективного локального вывода.

(1) Структура единого файла

GGUF объединяет все данные в одном бинарном файле. Это означает не только эффективность доступа к файлам (IO), но и упрощение развертывания модели.

Внутри файла имеется заголовок (Header), метаданные (Key-Value Dictionary) и блоки тензоров (Tensor Blocks).

Благодаря такой структуре даже при добавлении новых полей остается обратная совместимость. Например, если добавляются новые метаданные, такие как “prompt_format”, то старые загрузчики их игнорируют, а новые их распознают.

(2) Memory Mapping (mmap)

GGUF активно использует функцию отображения памяти (mmap) на уровне ОС. Это означает, что файл не загружается целиком в RAM, а загружаются только необходимые блоки.

Таким образом, при выполнении модели размером 10 ГБ объем, который фактически загружается в память, ограничивается "текущими вычисляемыми тензорами". Это позволяет запускать большие модели даже в условиях низкой памяти.

(3) Аппаратное ускорение и оффлоудинг (Offloading)

В целом GGUF спроектирован на основе предположения о вычислениях на CPU, но если доступна GPU, некоторые матричные операции могут быть оффлоудингом на GPU.

Благодаря этой структурной гибкости GGUF поддерживает три режима выполнения: CPU Only → Hybrid → GPU Assisted и обеспечивает согласованный профиль производительности на различных платформах.

3. Глубокое понимание квантования (Quantization)

Главная инновация формата GGUF заключается не просто в “сохранении” модели, а в способности “пересчитывать (Quantize)” числовую точность модели.

Квантование - это процесс сжатия весов, изначально представленных в формате с плавающей точкой (например, FP16, FP32), до более низкой битовой точности (например, 4bit, 5bit и т.д.).

В результате размер файла и объем используемой памяти резко уменьшаются, но семантическая производительность модели в основном сохраняется.

(1) Значение обозначения квантования (Qn_K_M, Q8_0 и т.д.)

Используемая в GGUF форма квантования - это не просто аббревиатура, а код, отражающий структуру внутреннего алгоритма.

-

Q: Квантование (тип квантования)

-

число (n): количество бит, используемых для представления одного веса (например, Q4 → 4 бита)

-

K: обозначает _K-блоковое квантование_, то есть структуру, в которой матрица разбивается на блоки размером K и квантуется независимо.

Например, если этоQ4_K, то тензор весов разбивается на блоки размера K, и для каждого блока отдельно вычисляются масштаб (scale) и нулевая точка (zero-point).

Это позволяет учитывать локальные характеристики, обеспечивая значительно более высокую точность по сравнению с простым глобальным квантованием. -

M: означает _Смешанную точность_ (Mixed Precision).

Некоторые тензоры (особенно проекции ключей/значений и другие важные части) сохраняются с более высокой точностью, а остальные - с низкой.

То есть это метод дифференцированного применения точности в зависимости от структурной важности модели. -

0 (Zero): означает структуру “non-K” блока. То есть это просто глобальное масштабное квантование, не основывающееся на K-блоках, что является самой простой структурой, но тонкая настройка здесь усложнена.

(2) Принципы и контексты применения различных методов квантования

| Тип квантования | Техническое описание | Внутренний механизм | Рекомендуемая среда использования |

|---|---|---|---|

| Q2_K | 2-битное квантование. Теоретически может добиться сжатия в 16 раз | Каждый блок восстанавливается на основе 4-х значений (2 бита × 16) | Крайне ограниченная память (Raspberry Pi, Edge устройства) |

| Q3_K_M | 3-битное квантование + Смешанная точность | Представляется в 3 бита, но для важных тензоров используется 4 бита и более | Ноутбуки с низкой производительностью, встроенные среды |

| Q4_K_M | Фактически стандарт 4-битного квантования | Сбалансированное блочное масштабирование, K-блочное квантование | Для обычных пользователей (MacBook, игровые ПК) |

| Q5_K_M | 5-битное квантование, минимизация потерь | Предоставляет более детализированные масштабные диапазоны | Среды с достаточной памятью |

| Q6_K | Квантование почти без потерь с высокой точностью | Масштабирование на основе минимальных и максимальных значений в каждом блоке | Для высококачественного вывода |

| Q8_0 | 8-битное простое квантование без блоков | Наиболее близкое к оригинальной производительности | GPU и высокопроизводительные рабочие станции |

> Обычно считается, что Q4_K_M является наиболее оптимальной точкой (Sweet Spot) в отношении качества к ёмкости, поскольку баланс локальной точности, обеспечиваемой структурой K-блоков, и 4-битного сжатия хорошо согласуется с большинством текущих единиц вычислений CPU/GPU (AVX, Metal, CUDA). |

4. Дизайнерские преимущества GGUF

-

Платформенная независимость: Позволяет проводить вывод с одинаковым бинарным файлом на разных аппаратных средствах, включая CPU, GPU, Apple Silicon.

-

Эффективность загрузки: Модели объемом несколько ГБ могут быть немедленно запущены с использованием загрузки на основе mmap.

-

Полная воспроизводимость: Внутри файла хранятся токенизатор и параметры, так что один и тот же GGUF файл везде выдает одинаковый результат.

-

Расширяемость экосистемы: Стандартом стали различные инструменты, такие как

llama.cpp,Ollama,LM Studio,LocalAI,llamacpp-python.

5. Ограничения и практические соображения

-

Непригодность для обучения.

GGUF является “форматом оптимизации вывода”, поэтому точность данных для обратного распространения (Gradient Backpropagation) не сохраняется.

Поэтому для повторного обучения, например, Fine-Tuning или LoRA приходится снова преобразовывать в формат FP16. -

Ограничения скорости по сравнению с форматами, оптимизированными для GPU

Форматы, такие как EXL2, AWQ, GPTQ, которые оптимизированы для GPU, могут быстрее генерировать токены за счет прямого использования матричных вычислений GPU.

Однако почти все они зависят от среды CUDA, и поддержка универсальных платформ, таких как CPU/Metal, ограничена.

GGUF проектировался с философией, нацеленной на универсальность и доступность, а не на скорость.

6. Заключение: GGUF — это “стандартный формат для персонального ИИ”

С появлением GGUF, большие языковые модели больше не являются собственностью лабораторий.

Достигнув трех столпов: эффективности вывода в локальной среде, единства файлов и независимости от оборудования, GGUF стал фактически де факто стандартом локальных LLM.

Если вы хотите протестировать такие современные модели, как Llama 3, Mistral, Phi-3 на MacBook или обычном ПК —

точка отсчета одна: скачать модель в формате GGUF.

Комментариев нет.