RTX 4090とDGX Spark、何が違うのか – オンプレミスAIインフラを考える企業のための比較分析

最近、AIインフラの構築を考えている企業や開発者は、一度は考えたことでしょう。 「今RTX 4090で十分なのに、DGX Sparkは本当に必要なのか?」

この記事はその質問に対する慎重な探求です。私自身、現在DGX Sparkを予約して配送を待っている立場として、RTX 4090ベースの環境で感じた限界と期待を元にまとめてみました。

GPUサーバー vs 高性能ワークステーション – どのインフラがAI最適化に適しているか?

| 区分 | RTX 4090ワークステーション | DGX Spark |

|---|---|---|

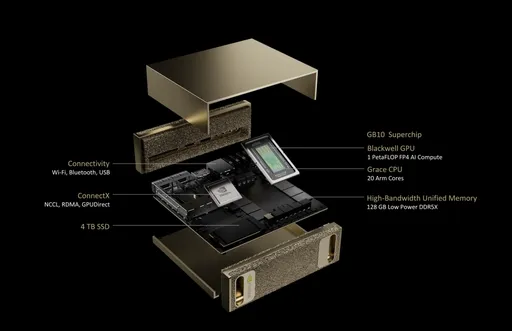

| GPUアーキテクチャ | Ada Lovelace | NVIDIA Blackwell |

| CPU | 外部CPU使用 | 20コアArm (10×Cortex-X925 + 10×Cortex-A725) |

| メモリ | 24GB GDDR6X | 128GB LPDDR5x (統合メモリ) |

| メモリ帯域幅 | 1,008 GB/s | 273 GB/s |

| ストレージ | ユーザー構成SSD | 1TBまたは4TB NVMe M.2 (暗号化対応) |

| ネットワーク | オプション | 10GbE + ConnectX-7 Smart NIC |

| 消費電力 | 約450W~600W | 170W |

| システムサイズ | ATXまたはタワー型 | 150 x 150 x 50.5 mm (1.2kg) |

| オペレーティングシステム | WindowsまたはLinuxユーザーインストール | NVIDIA DGX Base OS (Ubuntuベース) |

▶ 主な違い: 単なるパフォーマンスよりも「AI用に設計されているか」がキーポイントです。

業界で重要な違い: オンプレミスAIインフラの最適化

AIインフラの導入を検討する企業が重点的に見るのは単なる演算速度ではありません。次のような業界特有の違いが実際の選択基準となります:

- AIデータのセキュリティとデータ主権: クラウドに送れないデータ処理に必須

- エッジAIの展開: 製造/金融/医療分野のプライベートGPUサーバー需要急増

- AI推論の安定性: サーバー級の電力設計で24/7推論運用可能

- クラスタ統合: Grace CPU + Blackwell GPUの構造は単一マシンで高密度演算を実行可能

この観点から、DGX Sparkは単なるGPUデバイスではなくプライベートAIインフラソリューションです。

総所有コスト(TCO)と投資効率 – オンプレミスAIインフラのROIは?

| 比較項目 | RTX 4090単一システム | DGX Spark |

|---|---|---|

| 初期機器価格 | 約$3,500~$5,000 | $4,000 (NVIDIA公式発表基準) |

| 運営費 | 電力、発熱を考慮し自己管理 | ARMベースの低電力設計で電力効率と維持費削減 |

| 投資対象 | 個人または小規模実験 | 企業用モデル学習/推論プラットフォーム |

▶ 価格は似ているか、DGX Sparkがより低いレベルですが、運営効率とシステム統合価値まで考慮すれば長期的な総所有コスト(TCO)において競争力があります。

個人開発者?スタートアップ?誰にとってより適切か?

- RTX 4090がより適している場合:

- モデルサイズが小さく、個人学習および実験中心

- クラウドと混合して使用する開発者

-

コストに敏感なフリーランサー/研究者

-

DGX Sparkが適した場合:

- LLM社内展開/チューニング, データ主権保護が必要な企業

- クラウドに対してROIを高めたい産業ユーザー

- 24時間推論サービスを自社運営したいチーム

結論: 現在は「待機中」ですが、選択基準は明確です

RTX 4090は今でも十分優れたGPUです。 しかし、私はDGX Sparkがもたらす「AIサーバーの標準化」を期待しながら待っています。

単により速い速度よりも重要なのは: - どのシステムを基にAIを運用するか - どれだけ安全に、持続可能に、コスト効率よくAIインフラを構築するかです。

今後、実際の使用体験を残す日を楽しみにしており、この比較が賢明な選択基準となることを願っています。

コメントはありません。