ローカル環境でLLM(Large Language Model)を稼働させる経験は、ハードウェアのスペックによって明確に異なります。過去数年間、中級スペックのPCでGGUFモデルを動かし感じた限界、そして高性能ワークステーションであるSpark(DGX Spark)を導入した後に変化したローカルAI研究環境についての経験を共有したいと思います。

1. GGUF時代: 妥協と効率の美学

Sparkを導入する前、私のメイン機材はi7 12700F CPU、32GB RAM、そしてRTX 2060 12GBでした。このスペックで巨大な言語モデルを動かすための選択肢は一つだけ、GGUF(GPT-Generated Unified Format)でした。

量子化(Quantization)の沼

当時、モデルを選ぶ基準は性能よりも「稼働可能性」でした。Hugging Faceを探すときは習慣的にGGUFタグを検索し、その中でもQ4_K_Mフォーマットを探し回っていました。

- Q4_K_M: モデルのパラメータを4ビットに圧縮してメモリ使用量を削減しつつ、性能低下を最小限に抑えたフォーマット。

RTX 2060の12GB VRAMは7Bモデルをかろうじて立ち上げるか、システムRAMにオフロード(Offloading)して遅い速度を耐えなければなりませんでした。「動いている」という事実に満足し楽しんでいましたが、明らかに妥協された環境でした。

2. 単純推論(Inference)の限界と懐疑感

GGUFを通じてローカルでLLMを稼働させるのは興味深かったですが、すぐに根本的な疑問にぶつかりました。

「単に推論だけを行うのなら、オンプレミス環境は本当に必要か?」

単に質問応答をしテキストを生成することが目的なら、すでに世の中には圧倒的な性能を誇るGoogle GeminiやOpenAI GPTがあります。研究用APIのコストが個人ワークステーション構築のコストよりもはるかに安い場合もあります。学習やカスタムなしで他が作ったモデルをダウンロードして実行するだけ(Inference Only)は、ローカル環境を構築する必然性を弱めました。

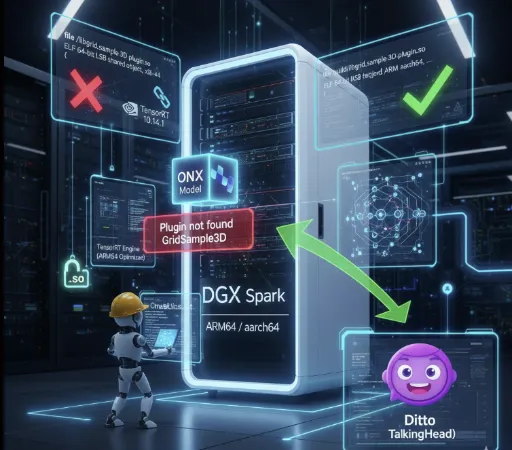

3. Spark導入とFP16の世界

約4,000ドルを投資してSparkマシンを導入した後、私のAI研究環境は完全に変わりました。最初に変わったのはモデルに対する姿勢です。

SafetensorsとFull Precision

もはやGGUFを探していません。今はFP16(Half Precision)ベースの.safetensors原本モデルをそのままダウンロードします。

速度とクオリティ: 量子化損失のない原本モデルの推論クオリティは確実に異なります。さらに高性能GPUのおかげで推論速度も快適です。

- 実際の速度差は明確です。

- RTX 2060環境: Mistral 7B GGUF Q4_K_M → 約10–20 tokens/s

- Spark環境(GPT-OSS-20B FP16): 約80–90 tokens/s

- Spark環境(GPT-OSS-120B FP16): 約40–50 tokens/s

同じ価格帯のノートPC・PCでは不可能なレベルの速度で、量子化損失なしにFP16モデルをそのまま使用してもこの程度の推論性能が得られることがローカルAI研究のパラダイムを完全に変えました。

柔軟な量子化: 必要があれば、自分自身でFP8やFP4に量子化を試みます。誰かが変換したファイルを使うのではなく、自分の研究目的に合わせて直接コントロールできるようになったのです。

4. 真の価値: LoRAファインチューニング(Fine-Tuning)

Sparkを導入したことが「本当に良い決断だった」と思う核心的な理由は、まさに学習(Training)の領域に進入したからです。

以前のスペックでは推論さえも苦労しておりファインチューニングの夢すら見れませんでした。しかし今は理論でしか学べなかったLoRA(Low-Rank Adaptation)を実際に行うことができます。

-

実践経験: データセットを準備し、ハイパーパラメータを調整しモデルを微調整する過程は単純な推論とは比べ物にならない深さの経験を提供します。

-

自分専用のモデル: 一般的なモデルではなく、特定のドメインや自分の文体に特化したモデルを作れることがオンプレミス環境の本当の魅力です。

推論を超え学習まで可能な環境、これが4,000ドルというコストが惜しくない理由です。

5. 依然として有効なGGUFの価値

もちろん、私の環境が変わったからといってGGUFの価値を否定するわけではありません。

GGUFの本質は「絶対的な性能」ではなくアクセス性にあります。

高価なGPUなしでもCPU・低スペックGPUだけで大規模な言語モデルを稼働させることができるほぼ唯一のフォーマットです。代わりに、量子化の特性上精度損失や推論品質低下、長文脈処理時の不安定さは避けられません。つまりGGUFは「誰でも動かせるモデル」という利点と「品質・速度・一貫性の限界」という両面性を持ったフォーマットなのです。

そしてGGUFは依然としてAI民主化の側面で優れたフォーマットです。全てのユーザーがファインチューニングを必要としているわけでもなく、高価な機材をそろえることもできません。ライトユーザーに標準化された環境で最適な推論性能を提供するGGUFエコシステムは、今後も個人PC性能の進展とともにより一般化されていくでしょう。数年後にはタブレットPCや私たちの携帯電話でGGUFフォーマットのモデルが稼働しているかもしれません。

最後に

RTX 2060でQ4_K_Mモデルを稼働させていた時期が「試食」だったとすれば、今のSparkと共にいることは「料理」をしている気分です。

ローカルAIの世界は単にモデルを動かすことを超え、モデルを理解し、修正し、自分のものにする過程で真の楽しみを見つけられます。もし皆さんが単純な推論を超え、モデルの構造的理解とカスタマイズに飢えているなら、ハードウェアへの投資はその飢えを解消する最も確実な鍵となるでしょう。

コメントはありません。