L’esthétique du tail de logs : le monde des bots qui passent sur votre serveur

Une pluie de texte blanc s’écoule sur l’écran noir du terminal. C’est un moment que tout administrateur système ou développeur backend connaît. Vous tapez tail -f access.log et vous laissez les logs vous parler.

Regarder ces logs qui montent sans cesse procure une étrange sérénité. On pourrait l’appeler un « digital zen ». Mais même dans cette quiétude, la curiosité s’éveille : « Qui est ce qui frappe la porte de mon serveur ? »

En scrutant les logs, on découvre que les vrais utilisateurs ne sont pas les plus nombreux. La majorité des requêtes proviennent de « bots » qui nagent dans l’océan d’internet. Dans ce billet, nous allons passer en revue les différents crawlers que l’on rencontre en tailant les logs, leurs identités et leurs particularités.

Bots : invités non désirés ou visiteurs bienvenus ?

Les web crawlers, ou spiders, visitent les sites web à l’aide de scripts automatisés pour collecter des informations.

1. Bots polies

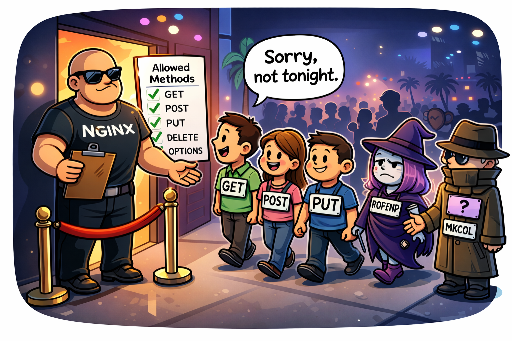

Ces bots annoncent clairement leur identité (User‑Agent), respectent le fichier robots.txt et visitent le serveur à des intervalles raisonnables pour éviter la surcharge. Ils sont nos alliés : ils améliorent la visibilité sur les moteurs de recherche.

2. Bots impolis

Ils se déguisent en navigateurs (spoofing) ou cachent leur identité. Certains ignorent robots.txt et bombardent le serveur à un rythme proche d’une attaque DDoS, épuisant les ressources. Ces bots sont la première cible des pare‑feux.

Maîtrise complète des bots courants

Voici une liste des bots les plus fréquents que l’on voit en tailant les logs, avec leur User‑Agent, leur propriétaire, leur objectif et quelques indices d’IP.

| Nom du bot (User‑Agent) | Propriétaire | Objectif et caractéristiques | Plage d’IP (référence) |

|---|---|---|---|

| Googlebot | Principal crawler pour l’indexation Google. Bienvenu. | 66.249.x.x (à vérifier via DNS) |

|

| Mediapartners‑Google | Crawler pour AdSense, analyse le contenu pour la publicité. | 66.249.x.x |

|

| Google‑InspectionTool | Outil de Search Console, déclenché par l’utilisateur. | 66.249.x.x |

|

| Bingbot | Microsoft | Crawler de Bing, deuxième moteur de recherche majeur. | 157.55.x.x, 40.77.x.x |

| Yeti | Naver | Crawler de Naver, indispensable pour les sites coréens. | 210.117.x.x, 114.111.x.x |

| DuckDuckBot | DuckDuckGo | Crawler de DuckDuckGo, axé sur la confidentialité. | 20.191.x.x (Azure) |

| YandexBot | Yandex | Crawler de Yandex, le plus grand moteur de recherche russe. | 5.255.x.x, 77.88.x.x |

| Baiduspider | Baidu | Crawler de Baidu, très agressif, souvent bloqué hors Chine. | 116.179.x.x, 220.181.x.x |

| GPTBot | OpenAI | Crawler pour collecter des données d’entraînement de ChatGPT. | 20.15.x.x (Azure) |

| ChatGPT‑User | OpenAI | Trafic provenant de l’outil de navigation de ChatGPT. | – |

| Bytespider | ByteDance | Crawler de TikTok, très agressif. | 47.128.x.x et autres |

| PetalBot | Huawei | Crawler de Petal Search, mobile‑orienté. | 114.119.x.x |

| AhrefsBot | Ahrefs | Outil d’analyse SEO, peut surcharger le serveur. | 54.36.x.x |

| SemrushBot | Semrush | Outil d’analyse SEO similaire à Ahrefs. | 46.229.x.x |

| DotBot | Moz | Outil d’analyse SEO, collecte de données de liens. | 216.244.x.x |

| Amazonbot | Amazon | Crawler d’Alexa et d’autres services Amazon. | 52.95.x.x (AWS) |

| FreshRSS / Reeder | Open Source | Lecteurs RSS personnels, pas vraiment des bots. | IP utilisateur |

| python‑requests / curl | – | Outils de script, souvent utilisés pour des tests ou des attaques automatisées. | – |

| peer39_crawler | Peer39 | Outil d’analyse publicitaire. | – |

Classement personnel des bots

En regardant les logs, j’ai créé un classement subjectif des bots, sachant que ce classement peut changer selon la philosophie du propriétaire et la cible de trafic.

🏆 Groupe 1 : VIP (Bienvenue !)

« Ils apportent du trafic, ils sont la raison d’être de mon serveur. Les plus précieux. »

- Membres :

Googlebot,Bingbot,Yeti,DuckDuckBot,Mediapartners‑Google,YandexBot,FreshRSS,Reeder - Raison :

- Moteurs de recherche : Sans eux, le site est comme une île déserte.

- YandexBot : Important pour le trafic russe et d’Europe de l’Est.

- Lecteurs RSS : Les abonnés fidèles qui lisent votre contenu.

😐 Groupe 2 : Citoyens ordinaires (Passez, c’est pas mal)

« Pas de bénéfice immédiat, mais potentiellement utiles ou inoffensifs. »

- Membres :

Baiduspider,ChatGPT‑User,Google‑InspectionTool,Amazonbot - Raison :

- Baiduspider : Marché chinois à ne pas négliger.

- ChatGPT‑User et Amazonbot : Pas nuisibles, indiquent simplement que votre contenu est référencé.

😤 Groupe 3 : Intrus (Ne venez pas !)

« Ils ne respectent pas les règles, ils consomment des ressources sans rien donner en retour. »

- Membres :

Bytespider,PetalBot,AhrefsBot,SemrushBot,DotBot,python‑requests,curl - Raison :

- Collecteurs agressifs :

Bytespider,PetalBot. - Outils SEO :

Ahrefs,Semrush,DotBot. - Scripts non identifiés :

python‑requests,curlsouvent utilisés pour le scraping ou la recherche de vulnérabilités.

En conclusion

Le tail de logs est plus qu’une simple surveillance : c’est une fenêtre sur la façon dont votre serveur interagit avec le réseau mondial.

Même si certains bots comme Bytespider semblent vouloir tout gratter, je préfère les laisser entrer tant qu’ils affichent un User‑Agent honnête. C’est un peu de la courtoisie minimale.

Je continue d’observer les logs qui s’écoulent, pensant :

« D’accord, je les laisse entrer tant qu’ils restent raisonnables ! »

Aucun commentaire.