L'expérience d'exécuter un LLM (modèle de langage de grande taille) dans un environnement local varie énormément selon les spécifications matérielles. Au cours des dernières années, j'ai ressenti les limites de faire tourner des modèles GGUF sur un PC de milieu de gamme, et je souhaite partager mon expérience sur le changement d'environnement de recherche en IA locale avec l'introduction d'une station de travail hautes performances, le Spark (DGX Spark).

1. L'ère GGUF : L'esthétique du compromis et de l'efficacité

Avant d'adopter Spark, mon équipement principal était un CPU i7 12700F, 32 Go de RAM et un RTX 2060 12 Go. Dans cette configuration, il n'y avait qu'une seule option pour exécuter un modèle de langage à grande échelle : le GGUF (Format Unifié Généré par GPT).

Les pièges de la quantification

À cette époque, le critère de choix des modèles était moins axé sur la performance que sur la 'possibilité de fonctionnement'. En fouillant dans Hugging Face, je cherchais systématiquement le tag GGUF, en errant à la recherche du format Q4_K_M.

- Q4_K_M : Un format qui compresse les paramètres du modèle à 4 bits, réduisant l'utilisation de la mémoire tout en minimisant la dégradation des performances.

Avec 12 Go de VRAM sur le RTX 2060, je ne pouvais faire tourner qu'un modèle de 7B ou j'étais contraint de le délester sur la RAM système, supportant ainsi une lenteur inacceptable. Tout en étant ravi de pouvoir « faire tourner » un modèle, c'était clairement un environnement compromis.

2. Limites de l'inférence simple et scepticisme

Faire fonctionner un LLM localement via GGUF était captivant, mais j'ai vite été confronté à une question fondamentale.

« N'est-il pas nécessaire d'avoir un environnement on-premise juste pour faire de l'inférence ? »

Si le but est simplement de faire des questions-réponses et de générer du texte, il existe déjà des modèles offrant des performances écrasantes, tels que Google Gemini ou OpenAI GPT. Le coût des API de recherche pourrait être bien inférieur au coût de construction d'une station de travail personnelle. Exécuter un modèle sans apprentissage ou personnalisation (Inference Only) affaiblissait la légitimité de construire un environnement local.

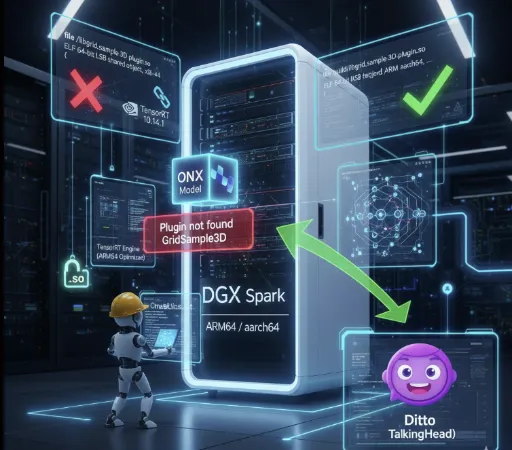

3. L'adoption de Spark et le monde du FP16

Après avoir investi environ 4 000 dollars dans une machine Spark, mon environnement de recherche IA a complètement changé. La première chose à changer est mon attitude envers les modèles.

Safetensors et Full Precision

Je ne cherche plus de GGUF. Désormais, je télécharge directement les modèles originaux basés sur FP16 (Demi-Précision) au format .safetensors.

Vitesse et qualité : La qualité d'inférence des modèles originaux sans perte de quantification est indiscutablement différente. De plus, grâce à un GPU haute performance, la vitesse d'inférence est également très agréable.

- La différence de vitesse est frappante.

- Environnement RTX 2060 : Mistral 7B GGUF Q4_K_M → environ 10–20 tokens/s

- Environnement Spark (GPT-OSS-20B FP16) : environ 80–90 tokens/s

- Environnement Spark (GPT-OSS-120B FP16) : environ 40–50 tokens/s

À une vitesse qui est impossible dans la même plage de prix pour les ordinateurs portables ou PC, montrer que même en utilisant le modèle FP16 sans perte de quantification a permis d'obtenir de telles performances d'inférence a complètement changé le paradigme de la recherche en IA locale.

Quantification flexible : Si nécessaire, j'essaie moi-même de quantifier en FP8 ou FP4. Au lieu d'utiliser des fichiers préalablement convertis, j'ai désormais un contrôle direct adapté à mes besoins de recherche.

4. La véritable valeur : LoRA Fine-Tuning

La raison principale pour laquelle je considère l'adoption de Spark comme « une très bonne décision » est que j'ai enfin pu entrer dans le domaine de l'apprentissage (Training).

Avec mon ancien matériel, même l'inférence était difficile, rendant le fine-tuning un rêve lointain. Mais maintenant, je peux directement effectuer le LoRA (Low-Rank Adaptation) que j'étudiais uniquement sur le papier.

-

Expérience pratique : La préparation de datasets, le réglage d'hyperparamètres et le raffinement du modèle offrent une profondeur d'expérience incomparable à l'inférence simple.

-

Mon propre modèle : La possibilité de créer un modèle spécifiquement adapté à un domaine ou à mon style plutôt qu'un modèle général est le véritable attrait d'un environnement on-premise.

Un environnement capable d'apprentissage en plus d'être capable d'inférence, voilà pourquoi le coût de 4 000 dollars n'est pas vain.

5. La valeur de GGUF reste pertinente

Cependant, le fait que mon environnement ait changé ne signifie pas que je renie la valeur de GGUF.

L'essence de GGUF ne réside pas dans la ‘performance absolue’ mais dans l'accessibilité.

C'est presque le seul format permettant d'exécuter de grands modèles de langage avec uniquement un CPU ou un GPU basse gamme, sans avoir besoin de GPU coûteux. Cependant, en raison de ses caractéristiques de quantification, il est inévitable d'accepter une perte de précision et une dégradation de la qualité d'inférence, ainsi qu'une instabilité lors du traitement de longs contextes. En d'autres termes, GGUF a à la fois l'avantage d'être un « modèle que tout le monde peut faire tourner » et la dualité « limitations de qualité, de vitesse et de cohérence ».

De plus, GGUF reste un excellent format en termes de démocratisation de l'IA. Tous les utilisateurs n'ont pas besoin de fine-tuning, et beaucoup ne peuvent pas se permettre d'acheter un équipement coûteux. Je pense que l'écosystème GGUF, qui offre des performances d'inférence optimales aux utilisateurs légers dans un environnement normalisé, sera de plus en plus démocratisé avec les avancées de la performance des PC personnels. Dans quelques années, nous pourrions voir des modèles au format gguf opérés sur des tablettes ou nos téléphones.

Pour conclure

Si l'époque où je faisais tourner des modèles Q4_K_M sur RTX 2060 était un ‘aperçu’, maintenant, avec Spark, je me sens comme en train de ‘cuisiner’.

Le monde de l'IA locale ne se limite pas à faire tourner des modèles, mais c'est dans le processus de compréhension, de modification et de personnalisation des modèles que l'on peut vraiment trouver du plaisir. Si vous ressentez le besoin d'une compréhension structurelle des modèles, au-delà de la simple inférence et de la personnalisation, l'investissement matériel sera la clé la plus sûre pour apaiser cette soif.

Aucun commentaire.