Die Leser dieses Beitrags sind sicherlich diejenigen, die mit der Entwicklung von Deep Learning unter Nutzung von GPUs beginnen möchten. Dieser Artikel ist ein praktischer Leitfaden, der die Schritte zur Vorbereitung der CUDA-basierten GPU-Berechnungen in einer Ubuntu-Umgebung zusammenfasst.

Besonders für Anfänger habe ich Inhalte erstellt, die hilfreich sind, um zu überprüfen, ob "CUDA korrekt auf meinem PC installiert ist?"

Wenn Sie sich für das Konzept von CUDA interessieren, empfehle ich Ihnen, zuerst den vorherigen Beitrag Was ist CUDA? Der Anfang von GPU und paralleler Berechnung zu lesen.

1. Warum sollte ich eine GPU-Umgebung einrichten?

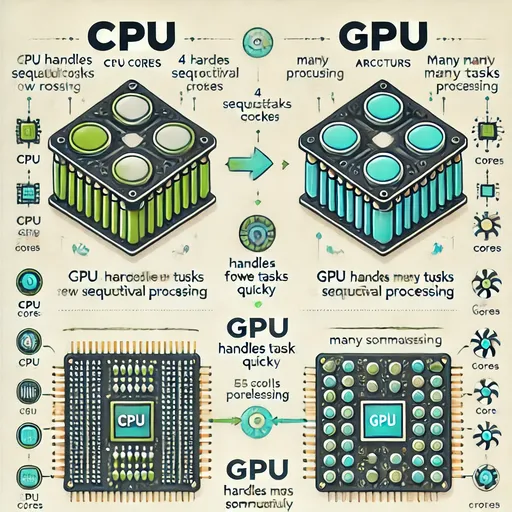

Das Training von KI-Modellen erfordert eine enorme Anzahl von Matrixoperationen.

Solche Berechnungen werden viel schneller auf einer GPU, die auf parallele Berechnungen spezialisiert ist, ausgeführt als auf einer CPU.

Aber nur eine GPU zu haben, reicht nicht aus.

Es müssen ein Treiber, der das Betriebssystem über die GPU informiert,

sowie CUDA, das Berechnungen auf der GPU ermöglicht,

und die für Deep Learning optimierte Bibliothek cuDNN

alle drei genau richtig installiert sein, um die GPU nutzen zu können.

2. GPU-Status überprüfen – Gibt es Treiber und CUDA?

nvidia-smi

Dies ist ein Tool, das den aktuellen Status der GPU anzeigt.

Wenn hier die CUDA-Version angezeigt wird und der Name der GPU korrekt erscheint,

bezeichnet dies, dass "die GPU korrekt erkannt wurde und der Treiber installiert ist".

3. CUDA-Entwicklungstools – Warum ist nvcc notwendig?

nvcc ist ein Tool zum Kompilieren von CUDA-Code (.cu).

Um es zu veranschaulichen, ist der CUDA-Kompiler nötig, um CUDA “wirklich zu nutzen”.

sudo apt update

sudo apt install nvidia-cuda-toolkit

nvcc --version

4. cuDNN – Das geheime Werkzeug für schnelle Deep Learning-Berechnungen auf der GPU

cuDNN ist eine von NVIDIA entwickelte Hochgeschwindigkeitsbibliothek für numerische Berechnungen, die Deep Learning optimiert.

Es wird in Deep Learning-Frameworks (z.B. PyTorch, TensorFlow) verwendet, um

- Faltung

- Pools

- RNN

- LSTM

- BatchNorm

- Aktivierung.

Wer plant, Deep Learning-Frameworks wie PyTorch oder TensorFlow zu nutzen, sollte diese Bibliothek unbedingt installieren.

Damit das Framework die GPU effizient nutzen kann, muss das cuDNN-Paket installiert werden, das zur Version von CUDA passt.

Der Download des cuDNN-Pakets variiert je nach Betriebssystem und CPU-Architektur, also besuchen Sie unbedingt die offizielle cuDNN-Download-Seite von NVIDIA und laden Sie die richtige Bibliothek herunter und installieren Sie sie.

Wenn Sie cuDNN über den obigen Link herunterladen, überprüfen Sie bitte zuerst die CUDA-Version, die Sie in nvidia-smi gesehen haben, und installieren Sie das passende cuDNN.

5. Testen – Überprüfen wir, ob die GPU in Python funktioniert

Nachdem Sie installiert haben, lassen Sie uns überprüfen, ob alles richtig funktioniert.

import torch

print(torch.cuda.is_available()) # True

print(torch.cuda.get_device_name(0)) # NVIDIA GeForce RTX XXXX

6. Zusammenfassung

| Komponente | Ihr Handeln | Warum Sie das getan haben |

|---|---|---|

| NVIDIA-Treiber | Installationsstatus überprüfen (nvidia-smi) |

GPU im System erkennen |

| CUDA Toolkit | nvcc installieren |

Kompiler für die Ausführung von CUDA-Code |

| cuDNN | cudnn-cuda-12 installieren |

Optimierungsbibliothek für Deep Learning-Berechnungen |

| PyTorch-Test | Überprüfung der GPU-Verbindung | Überprüfung, ob reale Berechnungen möglich sind |

7. Abschließende Worte von Jesse

Jetzt ist Ihr System bereit, GPU-Berechnungen durchzuführen.

Auf dieser Grundlage können Sie verschiedene Modelle wie Whisper, LLaMA, ChatGPT schnell auf der GPU trainieren oder ausführen.

Es sind keine Kommentare vorhanden.