在几年前,"我买了一张好的显卡(GPU)" 的意思通常是 "我会玩高配置的游戏" 或 "我开始视频剪辑了"。一般计算机的核心一直是CPU,而GPU则只是一个辅助设备,用来美化显示。

然而,随着生成式AI和深度学习时代的到来,局面完全翻转。现在,为了在个人电脑上运行或训练AI模型,高性能GPU成为必不可少的。正因如此,英伟达(NVIDIA)成为了全球市值最高的公司。

究竟是什么原因,让聪明的博士们——CPU被置于一边,而看似简单的劳动者——GPU成为了AI时代的主角呢?其背后的秘密隐藏在我们高中数学课上学过的‘向量’ 和 ‘矩阵’,以及大学时学习的 ‘线性代数’ 中。

1. 教计算机“苹果”和“香蕉”的方法:向量(Vector)

当我们想到“苹果是红色的、圆圆的”,“香蕉是黄色的、长长的”时,计算机是如何理解这些概念的呢?计算机只知道0和1,也就是数字。因此,计算机工程师和数学家决定将世界上所有的概念转化为数字的集合,也就是向量(Vector).

例如,假设用[颜色、形状、甜度]这个三维向量来表示水果的特征。(红色=1,黄色=10 / 圆形=1,长条形=10)

-

苹果: $[1, 1, 8]$

-

香蕉: $[10, 10, 9]$

-

青苹果: $[2, 1, 7]$

把数据转换成向量后,就会发生惊人的事情。也就是可以计算“相似度(Similarity)”。

在空间中,苹果和青苹果的坐标非常接近,而香蕉则远离。这使得AI判断“苹果和青苹果是相似的!”的依据正是这个向量空间中距离的计算。

2. 向量组合成的巨大立方体:张量(Tensor)

然而,AI需要处理的数据可不仅仅是三种水果。

试想想一张宽高1000像素的彩色照片。每个像素需要三个数字R、G、B,因而一张照片由 $1000 \times 1000 \times 3$ 个数字组成,构成了一大块数据。

-

标量(Scalar): 一个数字 (例如:5)

-

向量(Vector): 数字的一行数组 (例如:[1, 2])

-

矩阵(Matrix): 数字的二维表格 (Excel表)

-

张量(Tensor): 三维以上的数字块 (立方体形状)

谷歌的AI框架被命名为‘TensorFlow’,原因就在于此。AI实际上是一个不停处理这些巨大数字块(张量)的计算机器。

3. AI的本质:无限的乘法和加法(矩阵运算)

当提到深度学习(Deep Learning)时,似乎会做出极其复杂的逻辑推理,但深入观察,实际上是简单的矩阵乘法(Matrix Multiplication)的反复计算。

像输入数据(X)乘以权重(W)并加上偏置(b)的公式$Y = WX + b$会被重复数亿次、数万亿次。

问题不在于计算的难度,而在于“数量”。

-

CPU的方式: “好吧,先计算第一行……完成了吗?那么第二行……”(顺序处理)

-

AI的要求: “现在马上同时做1亿次乘法!”

在这种情况下,天才数学家(CPU)会感到崩溃。再怎么聪明,身体只有一个,无法同时完成1亿个作业。

4. 涂色的画笔,成为AI的大脑

这时的救世主正是GPU(Graphics Processing Unit)。GPU本是为了在屏幕上绘制图像而诞生的。

想想看显示器上的屏幕。FHD屏幕大约有200万像素。在玩3D游戏时,GPU需要同时对这200万个每个像素进行计算:“你应该是什么颜色”,“这里是阴影,所以要更暗些”。

-

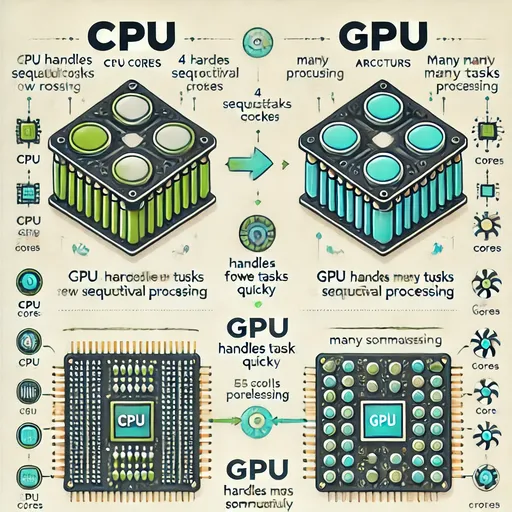

CPU: 少数非常聪明的核心(博士4~16名)→ 复杂逻辑及有序工作的最佳选择

-

GPU: 只会进行简单计算的数千个核心(小学5,000名学生)→ 适合同时处理简单重复计算(并行计算)

开发者们意识到:

“等一下,将3D游戏中的像素坐标计算并同时进行上色,以及AI深度学习中的矩阵乘法同时进行,这不都是数学上完全一样的吗?”

为了图形处理不断发展的GPU的大规模并行处理能力,恰好(或者说必然地)和深度学习中的矩阵运算完美契合。在GPU看来,它所做的工作(矩阵运算)基本上和在屏幕上绘制像素是一样的,只是换了任务而已。

5. 结论:学生时代的数学课没有白费

总结一下:

-

计算机工程师和数学家们为了理解世界(或者让机器理解),将信息转化为向量和张量。

-

处理这些张量则需要线性代数(矩阵运算)。

-

同时计算成千上万像素的GPU,早已对这种矩阵运算进行了优化。

这三者的结合促成了现在的AI革命。

在高中时抱怨“学向量和标量有什么用?”在大学时又为线性代数的矩阵乘法抓狂?我记得在大学一年级时,线性代数让我觉得特别无聊,结果分数不好,到了三年级时重修并恢复了成绩。第二次上课时虽然努力了,但相比于微分方程来说,线性代数的枯燥依旧不变。然而,令人惊讶的是,这些晦涩的数学竟成了20年后创造人类历史上最聪明的人工智能的关键所在,这让我感到一种感动。

数学家的理论与硬件工程师的技术相交之处,正是GPU和AI的所在。

🚀 下一篇文章预告

现在我们了解了CPU和GPU的区别。然而,最近新闻中频繁出现的NPU(神经处理单元)又是什么呢?让我们来探讨一下NPU与GPU的AI优化之间的关系。

目前没有评论。