インターネットは絶えず変化し、拡大する巨大な情報の海です。この膨大なデータを探索し、収集するために欠かせない役割を担っているのが、ウェブクローラー(Web Crawler)、一般にボット(Bot)と呼ばれる自動化プログラムたちです。ウェブを巡って情報をインデックス化し、データを収集し、さまざまなサービスを提供するこれらのボットは、ウェブエコシステムの重要な構成要素です。しかし、すべてのボットがウェブにとって有益なわけではありません。時にはウェブサイトに損害を与えたり、悪用されたりする有害なボットも存在します。

今回の記事では、ウェブでよく見かける有名なボットの種類と特徴、そして有益なボットと有害なボットを区別する方法、さらに有害なボットからウェブサイトを守るための効果的な方法について探ります。

ウェブでよく見られる有名なボット(有益なボット)

ウェブのトラフィックのほとんどは人ではなくボットによって生成されています。その中でも最も重要で有益なボットは以下の通りです。

1. 検索エンジンボット (Search Engine Bots)

最も一般的で重要なボットです。ウェブページを探索してコンテンツを収集し、検索エンジンのインデックスに追加してユーザーが情報を見つけられるように支援します。

-

Googlebot (Google): グーグルの代表的なウェブクローラーです。ウェブのほぼすべてのページを探索して検索結果を更新し、グーグルサービス(地図、ニュースなど)にデータを提供します。

User-AgentにGooglebotまたはMediapartners-Googleなどと表示されます。 -

Bingbot (Microsoft Bing): マイクロソフトのBing検索エンジンクローラーです。

User-AgentにBingbotと表示されます。 -

Baidu Spider (Baidu): 中国の主要な検索エンジンBaiduのクローラーです。中国市場をターゲットにしている場合、Baidu Spiderの訪問も重要です。

User-AgentにBaiduspiderと表示されます。 -

Yandex Bot (Yandex): ロシアの主要な検索エンジンYandexのクローラーです。

User-AgentにYandexBotと表示されます。 -

Yeti (Naver): 韓国のネイバーの代表的な検索エンジンクローラーです。韓国市場に特化した検索結果を収集し、

User-AgentにYetiと表示されます。

2. ソーシャルメディアボット (Social Media Bots)

ソーシャルメディアでリンクを共有する際、そのリンクのプレビュー(タイトル、説明、画像)を生成するために使用されます。

-

Facebook External Hit (Facebook): フェイスブックでリンクを共有する際ページ情報を取得します。

User-Agentにfacebookexternalhitと表示されます。 -

Twitterbot (Twitter/X): ツイッター(X)でリンクプレビューを生成します。

User-AgentにTwitterbotと表示されます。 -

Slackbot (Slack): スラックでリンクを共有する際プレビューを生成します。

User-AgentにSlackbotと表示されます。

3. モニタリング/分析ボット (Monitoring/Analytics Bots)

ウェブサイトの状態、パフォーマンス、セキュリティの脆弱性を監視したり、トラフィック分析を行うために使用されます。

-

UptimeRobot, Pingdom: ウェブサイトの稼働時間を監視し、ダウンした際に通知を送ります。

-

Site Crawlers (Screaming Frog, Ahrefsbot, SemrushBotなど): SEOツールがウェブサイトを分析し、SEOの改善点を探したり、競合分析のデータを収集します。

User-Agentに該当ツールの名前が含まれます。 -

Ahrefsbot (Ahrefs): Ahrefsは、上記で説明した強力なSEO分析クローラーの1つで、 Ahrefsbotはウェブで最も活発に活動している商業用クローラーです。ウェブサイトのバックリンク、キーワードランク、オーガニックトラフィックなど膨大なSEOデータを収集し、Ahrefsサービスのユーザーに提供します。特にバックリンクデータベースを構築するためにインターネットを非常に広範囲にクローリングし、そのためウェブサーバーログで

Googlebotの次によく見られるボットの一つです。User-AgentにAhrefsBotと表示されます。

有害なボットと有益なボットの区別

ボットトラフィックがウェブサイトに与える影響は、ボットの目的と行動方式によって大きく異なります。有害なボットはウェブサイトのリソースを枯渇させたり、データを盗んだり、セキュリティの脆弱性を悪用することがあります。

有益なボットの特徴

-

robots.txtの遵守: 大多数の有益なボットはウェブサイトのrobots.txtファイルを尊重し、ここに明記された規則(クローリング許可/禁止領域、クローリング速度など)に従います。 -

正常なリクエストパターン: リクエスト間に適切な遅延時間を設け、サーバーに過負荷をかけません。

-

正式な

User-Agent: 明確で知られているUser-Agent文字列を使用し、しばしばボットの所有者情報(例:Googlebot/2.1 (+http://www.google.com/bot.html))を含みます。 -

正規のIPアドレス: そのボット所有者の実際のIPアドレス範囲からリクエストを送ります。(例:Googlebotはグーグル所有のIP帯域を使用)

有害なボットの特徴

-

robots.txtの無視:robots.txtファイルを無視し、アクセスが許可されていない領域に無断でアクセスしようとします。 -

非正常なリクエストパターン: 特定のページへの短時間内の繰り返しリクエスト(DDoS攻撃の試み)、異常に早いクローリング速度などでサーバーに過負荷をかけます。

-

偽造された

User-Agent: 有益なボット(例:Googlebot)のUser-Agentを偽造して隠れたり、無作為に生成されたUser-Agentを使用します。 -

不明なIPアドレス: プロキシサーバーやVPN、ゾンビPCなどを利用してIPアドレスを隠したり頻繁に変更します。

-

悪意のある活動:

-

コンテンツスクレイピング(Content Scraping): ウェブサイトのコンテンツを無断でコピーし、他のウェブサイトに掲載したり再販売します。

-

在庫スナイピング(Inventory Sniping): 電子商取引サイトで商品在庫を素早く把握し、転売などに悪用します。

-

資格情報スタッフィング(Credential Stuffing): 盗まれたユーザーアカウント情報を他のウェブサイトに利用してログインを試みます。

-

スパム登録: 掲示板やコメントセクションにスパムコンテンツを自動的に登録します。

-

DDoS攻撃: 大量のトラフィックを発生させてウェブサイトを麻痺させます。

-

脆弱性スキャン: ウェブサイトの既知のセキュリティ脆弱性を自動でスキャンして攻撃ポイントを探します。

-

有害なボットを効果的にブロックする方法

悪意のあるボットはrobots.txtのようなルールを無視し、実際のユーザーになりすましてウェブサイトに侵入しようとします。そのため、これらをブロックするためには、彼らの非正常な行動パターンを検知し、そのリクエストだけを選択的にブロックする高度な戦略が必要です。

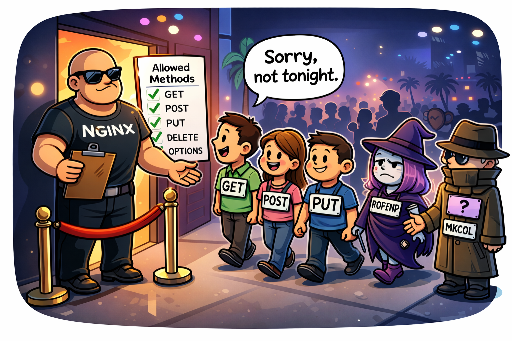

1. IPアドレスおよびUser-Agentに基づくブロック(限定的な初期防御線)

悪性トラフィックが特定のIPアドレスやIP範囲で継続的に発生する場合や、明らかに有害なUser-Agent文字列を使用する場合、一時的に効果を発揮することがあります。

-

ウェブサーバー設定 (Apache, Nginx):

- 特定IPアドレスのブロック:

# Nginx の例

deny 192.168.1.100;

deny 10.0.0.0/8;

- **悪性 `User-Agent`のブロック:**

# Apache .htaccess の例

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} "BadBotString|AnotherBadBot" [NC]

RewriteRule .* - [F,L] # 403 Forbidden を返す

限界: IPアドレスは動的であったりプロキシ、VPN、Torネットワークを通じて簡単に回避される可能性があります。悪性ボットはIPをほぼ無限に変えながら攻撃を試みることができるため、IPベースのブロックは管理負担を増して長期的な解決策になり得ません。 User-Agentも容易に偽造されるため、この方法だけでは精巧な悪性ボットを阻止することは困難です。

2. リクエスト速度制限 (Rate Limiting)

特定のIPアドレス、User-Agent、または特定のURLに対するリクエスト数が短時間内に異常に急増する際に、そのリクエストを制限またはブロックします。これはDDoS攻撃や過剰なスクレイピング試行を阻止するのに効果的です。

- ウェブサーバー設定 (Nginxの例):

# Nginx http ブロック内

limit_req_zone $binary_remote_addr zone=mylimit:10m rate=5r/s;

# server または location ブロック内

location / {

limit_req zone=mylimit burst=10 nodelay; # 秒間5つのリクエストを許可し、バースト10つまで

# ...

}

難易度とリスク: リクエスト速度制限は非常に有用ですが、適切な閾値設定が非常に厳しいです。 あまりにも厳格に設定すると、正常なユーザーや有益な検索エンジンボットのトラフィックまで制限され、サービスのアクセス可能性が低下することがあります。逆に、緩すぎる設定にしてしまうと悪性ボットの目的を達成させる可能性もあります。サービスの特性や一般的なトラフィックパターンに対する深い理解に基づいて継続的な監視と調整が求められる部分です。

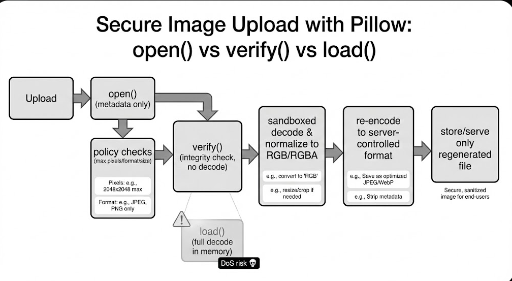

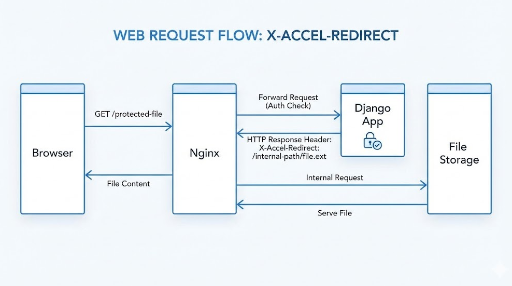

3. 行動ベースの検出およびカスタム防御システムの構築(最も効果的な戦略)

最も精巧で効果的な方法です。悪意のあるボットはIPやUser-Agentを偽装することができますが、ウェブサイト内での彼らの行動パターンは特異に現れます。 これらの非正常な行動を分析して悪意のあるボットを特定し、そのパターンに対する防御システムを構築することが鍵です。

-

トラフィックモニタリングとログ分析の重要性:

ウェブサーバーログ(アクセスログ)はボットの行動を把握するための最も重要なデータソースです。ログを定期的に(1日1回以上)検討し、分析する習慣を身につけることが必須です。ログ分析を通じて以下のような悪性ボットの異常行動を発見できます。

-

異常な探索経路: 人が通常移動しないページの順序、異常に速いページ移動、特定のページに対する繰り返しのアクセス。

-

繰り返し特定の作業の試み: ログイン失敗の繰り返し、存在しないアカウントでのログイン試み、特定のフォームの無限提出、予約システムでのマクロを使用した席取り。

-

疑わしいURLリクエスト: ウェブサイトに存在しない既知の脆弱性パス(例:

/wp-admin/、/phpmyadmin/、.envファイルなど)に対する繰り返しのアクセス試み。 -

HTTPヘッダー分析: 異常なHTTPヘッダーの組み合わせや順序、ヘッダーの欠如など。

-

-

悪性ボットの行動パターン化の例:

ログで発見される悪意のあるボットの具体的な行動パターンを把握し、これを基に防御ロジックを実装する必要があります。

-

GET /cgi-bin/luci/;stok=.../shell?cmd=RCE- 説明:

OpenWrt管理パネルのリモートコード実行(RCE)脆弱性を狙った攻撃の試みです。ルーターや組み込みデバイスで主に使用されるLinuxベースのシステムの脆弱性を探索します。

- 説明:

-

POST /wp-login.php(繰り返しのログイン試み)- 説明: ワードプレス管理ページに対するブルートフォース攻撃または資格情報スタッフィングの試みです。

-

GET /HNAP1/- 説明: D-Linkルーターで見つけられたHNAP1(Home Network Administration Protocol)脆弱性を狙ったスキャンと攻撃の試みです。

-

GET /boaform/admin/formLogin- 説明: 古いルーターやウェブカメラなどで使用される

Boaウェブサーバーの管理者ログインパネル侵入試みです。

- 説明: 古いルーターやウェブカメラなどで使用される

-

GET /.envまたはGET /.git/config- 説明:

.envファイル(環境変数)や.gitディレクトリへのアクセスを通じて敏感な情報を盗もうとする試みです。

- 説明:

これらのパターンを検知すると、そのリクエストをブロックしたり、一時的にIPをブラックリストに追加するなどの対応が可能です。これはサーバーサイドでミドルウェア(例:Djangoミドルウェア)やウェブサーバー設定(Nginx

mapモジュール、Apachemod_rewriteなど)を通じて実現できます。 -

-

JavaScript実行の有無確認:

ほとんどの悪性ボットは実際のブラウザのようにJavaScriptを完全に実行しません。隠れたJavaScriptコード(例:特定のDOM要素のクリックを誘導)、canvasフィンガープリンティング、またはブラウザAPIの呼び出しの有無などを通じてボットかどうかを判別し、JavaScript実行に失敗したクライアントをブロックする方法があります。

4. Honeypot(罠)の活用

ハニーポット(Honeypot)は悪意のあるボットを引き寄せ、特定するための意図的な「罠」です。正常なユーザーには見えないが、自動化されたボットが探索または相互作用するように設計された要素をウェブページに隠します。

-

動作原理:

-

隠しリンク/フィールド: CSS(

display: none;、visibility: hidden;、height: 0;など)を利用するか、JavaScriptで動的に生成した後、画面外に移動させてユーザーには全く見えないリンクやフォームフィールドを生成します。 -

ボットの行動誘導: 正常なウェブブラウザを使用する人はこの要素を見ることができないため相互作用できません。しかし、ウェブページのすべてのリンクやフォームを機械的に解析する悪性ボットは、この隠された要素を発見し、相互作用しようと試みます(例:隠されたフォームフィールドに値を入力したり、隠されたリンクをクリックする)。

-

悪性ボットの特定: 隠されたフィールドに値が入力されたり、隠されたリンクへのアクセスリクエストが発生すると、これは明らかに悪性ボットによる行動と見なすことができます。

-

自動ブロック: このような行動が検出されたIPアドレスやセッションは即座にブラックリストに追加されたりブロックされます。

-

-

実装例:

<form action="/submit" method="post">

<label for="username">ユーザー名:</label>

<input type="text" id="username" name="username">

<div style="position: absolute; left: -9999px;">

<label for="email_hp">このフィールドは空にしてください:</label>

<input type="text" id="email_hp" name="email_hp">

</div>

<label for="password">パスワード:</label>

<input type="password" id="password" name="password">

<button type="submit">ログイン</button>

</form>

サーバーでは `email_hp`フィールドに値がある場合、そのリクエストをボットと判断してブロックします。

- 利点: ユーザー体験を妨げることなく悪性ボットのみを効果的に特定できます。比較的実装が簡単で、偽造が困難です。

5. ウェブアプリケーションファイアウォール (WAF) および専門ボット管理ソリューション

大規模なウェブサイトや敏感なサービスを運営している場合、専門的なWAFソリューション(Cloudflare、AWS WAF、Sucuriなど)やボット管理ソリューション(Cloudflare Bot Management、Akamai Bot Manager、PerimeterXなど)を使用するのが最も効果的です。これらのソリューションは:

-

高度な行動分析: 機械学習に基づいてリアルタイムトラフィックを分析し、人間とボットの微妙な行動の違いを検知します。

-

脅威インテリジェンス: 世界的な攻撃パターンやIPブラックリストデータベースを活用して広範な脅威を特定します。

-

誤ブロックの最小化: 精巧なアルゴリズムを通じて有益なボットや正常なユーザーに対する誤ブロックを最小限に抑えつつ、悪意のあるボットのみをフィルタリングします。

-

自動化された対応: 検知された悪性ボットに対して自動的にブロック、チャレンジ提供などの対策を取ります。

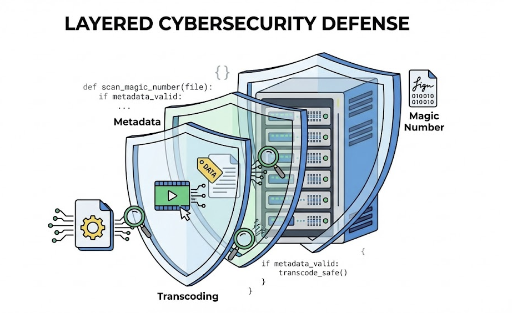

結論: 能動的で多層的なボット防御戦略

悪意のあるボットは絶えず進化し、ウェブサイトを攻撃しようとします。robots.txtは正直なボットのための指針にすぎず、侵入者を防ぐ盾にはなりません。したがって、ウェブサイトのセキュリティと安定性を確保するためには、ボットの行動を分析し特定して悪意のあるボットのみを選択的にブロックする能動的で多層的な防御戦略が必須です。

ログ分析を通じて非正常行動のパターン化、リクエスト速度制限の精緻な設定、ハニーポットを用いた罠の設置、そして必要に応じて専門ボット管理ソリューションやWAFの導入を通じてウェブサイトをさらに安全に保護し、有益なボットとの円滑な相互作用を維持しながらユーザーに快適なサービスを提供できるでしょう。あなたのウェブサイトは、どのボットの脅威に最も脆弱ですか?適切な防御戦略を考えるべき時です。

コメントはありません。