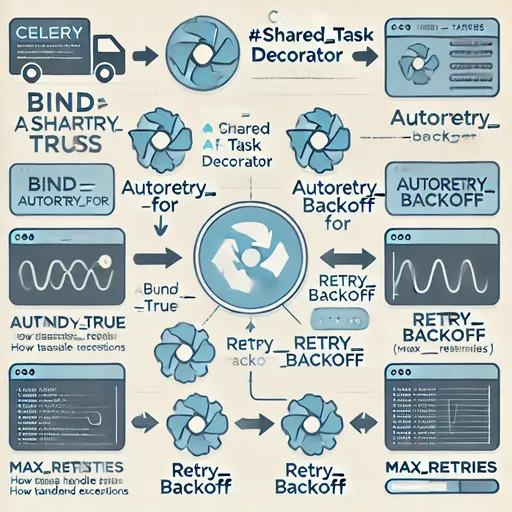

Celeryは非同期タスク処理をサポートする強力なフレームワークです。 @shared_task デコレーターはタスクを定義するために使用され、特にオプションである bind, autoretry_for, retry_backoff, max_retries を活用することで タスクの安定性と自動エラー処理を大幅に向上させることができます。

この記事では、各オプションの動作方法と活用法を探り、よくある混乱とその解決策を紹介します。

1. bind=True

定義

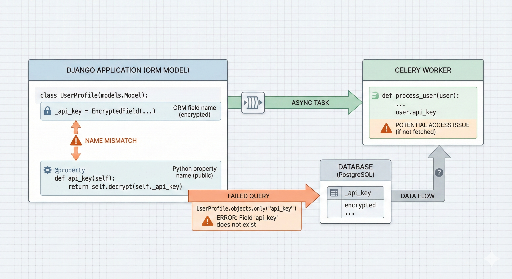

bind=True は現在のタスクを最初のパラメータとして渡し、タスク内部で self を使用できるようにします。これにより、タスクの状態、メソッド、属性などにアクセスできます。

主要機能

- タスク状態にアクセス可能: タスクのID、リクエスト情報などにアクセスして状態を確認したり、ログを記録したりできます。

- 明示的な再試行ロジック:

self.retry()メソッドを使用して再試行ロジックを手動で実装できます。

例

@shared_task(bind=True)

def my_task(self, some_arg):

print(f"Task ID: {self.request.id}") # タスク ID を出力

self.retry() # タスクを再試行2. autoretry_for=(ExceptionType, ...)

定義

指定された 例外タイプ が発生したときに、Celeryがタスクを自動的に 再試行(retry) するように設定します。開発者が self.retry() を明示的に呼び出す必要はなく、例外を処理して再試行を自動化します。

注意点

autoretry_forを使用する場合: 再試行が自動で行われるため、self.retry()と重複しないように使用する必要があります。- 混用時の問題点:

autoretry_forとself.retry()を同時に使用すると、同じ例外に対して 重複再試行 が発生する可能性があります。

例

推奨方法: autoretry_for のみを使用する場合

import requests

@shared_task(bind=True, autoretry_for=(requests.RequestException,), retry_backoff=True)

def my_task(self, url):

response = requests.get(url)

response.raise_for_status() # ステータスコードが200でない場合に例外を発生させる特定条件でのみ明示的に再試行 (self.retry()) を使用する場合

import requests

@shared_task(bind=True, retry_backoff=True, max_retries=5)

def my_task(self, url):

try:

response = requests.get(url)

response.raise_for_status()

except requests.RequestException as e:

print(f"Retrying due to error: {e}")

self.retry(exc=e) # 明示的な再試行3. retry_backoff=True

定義

タスク再試行の間隔を段階的に増加させる 指数バックオフ(Exponential Backoff) を有効にします。最初の再試行は即時、以降の再試行は1秒、2秒、4秒...と間隔が増加します。

主要機能

- サーバー負荷を軽減し、ネットワーク障害を効率的に処理。

- バックオフ時間はCeleryのデフォルト設定を通じてカスタマイズ可能。

例

@shared_task(bind=True, autoretry_for=(requests.RequestException,), retry_backoff=True)

def my_task(self):

# 最初の再試行は1秒後、2回目は2秒後...

raise requests.RequestException("Simulated failure")4. max_retries

定義

タスクの 最大再試行回数 を制限します。タスクが指定された回数だけ再試行しても成功しない場合、タスクは失敗として記録されます。

主要機能

- 無限再試行を防ぎ、サーバーリソースの消費を制限。

- 失敗条件に応じてタスクを記録するか、他のロジックを実行可能。

例

@shared_task(bind=True, autoretry_for=(requests.RequestException,), retry_backoff=True, max_retries=5)

def my_task(self):

raise requests.RequestException("Simulated failure")5. 混用時の注意事項: autoretry_for vs self.retry()

正しい使用ガイド

autoretry_for使用時: 自動再試行が設定されるため、self.retry()を明示的に呼び出す必要はありません。特定の例外に対してタスクを再試行する際は、シンプルなコードを書くことができます。self.retry()使用時: 再試行前に追加作業(例: ログ記録、特定条件のチェック)が必要な場合に使用します。autoretry_forと重複しないように注意してください。

6. オプションの概要

| オプション | 説明 |

|---|---|

bind=True |

タスクで self を通じてタスクの状態とメソッドにアクセス可能。 |

autoretry_for |

特定の例外が発生したときタスクを自動的に再試行。 |

retry_backoff |

再試行間隔を段階的に増加させる指数バックオフを有効化。 |

max_retries |

最大再試行回数を制限してタスクの失敗条件を定義。 |

7. 結論

Celeryの @shared_task オプションは、タスクの失敗を効果的に処理し、安定性を高めるのに役立ちます。

autoretry_forを使用する場合: 再試行ロジックが自動化されるため、self.retry()と重複しないように注意してください。- 条件付きのロジックや追加作業が必要な場合は、

self.retry()を活用できます。

Celeryを活用したタスクを安定して実装するためには、これらのオプションを組み合わせて状況に応じた最適化されたコードを書いてみてください! 😊

コメントはありません。