En las dos últimas publicaciones, hemos explorado a fondo la historia de la arquitectura de CPU (x86, x64) y el auge de ARM. Hoy, vamos a hablar sobre la empresa que está en la cúspide de toda esta conversación sobre CPU y que se ha vuelto uno de los temas más candentes: NVIDIA.

NVIDIA ha dominado durante mucho tiempo el mercado de GPU (unidad de procesamiento gráfico). Sin embargo, recientemente, han estado ampliando su influencia más allá de los GPU hacia el mercado de CPU, reescribiendo el futuro de la computación. Vamos a averiguar por qué NVIDIA está fabricando CPUs y qué significa esto en la era de la IA.

1. ¿No era NVIDIA originalmente una empresa de GPU? ¿Cuál es su relación con la CPU?

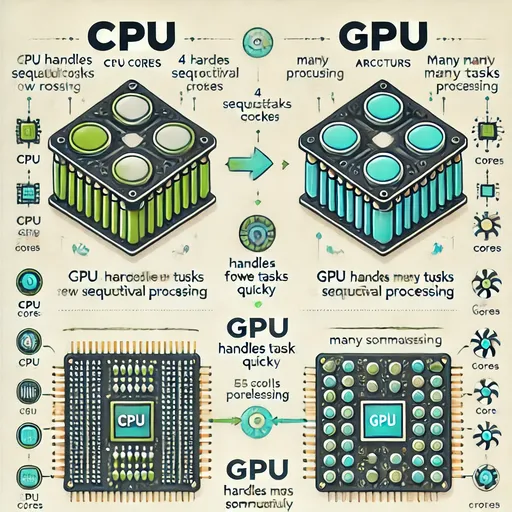

Así es. NVIDIA es conocida principalmente por sus GPUs GeForce (para juegos), Quadro/RTX (para profesionales) y, más recientemente, por sus GPUs para centros de datos A/H. Los GPUs procesan las operaciones de una manera diferente que los CPUs.

-

CPU: Está especializado en procesar rápidamente tareas complejas y secuenciales. (Ej: ejecución del sistema operativo, trabajo en documentos, navegación web)

-

GPU: Opera miles de pequeños núcleos en paralelo al mismo tiempo, siendo muy potente en el manejo de operaciones masivas, simples, pero repetitivas. (Ej: renderizado gráfico, simulación física y aprendizaje/inferencia de inteligencia artificial)

Durante mucho tiempo, los CPU y GPU han complementado sus roles en la configuración de sistemas informáticos. El CPU actuaba como el 'cerebro' del sistema, mientras que el GPU manejaba gráficos o tareas que requerían operaciones paralelas como un 'experto'.

Sin embargo, con la llegada de la era de la inteligencia artificial (IA), la relación entre ellos ha comenzado a cambiar. Las tareas de IA que requieren aprender enormes volúmenes de datos y calcular redes neuronales complejas casi no serían posibles sin la capacidad de procesamiento paralelo de los GPUs. NVIDIA se dio cuenta de este potencial temprano y desarrolló una plataforma de computación paralela llamada CUDA, permitiendo que los GPUs se utilizaran como dispositivos de cálculo versátiles más allá de las simples tarjetas gráficas.

2. Limitaciones del GPU y necesidad del CPU: Ineficiencia en 'movimiento de datos'

Es claro que los GPUs han sido fundamentales en los cálculos de IA, pero el movimiento de datos entre CPUs y GPUs sigue siendo una fuente de cuellos de botella.

- Transferencia de datos CPU ↔ GPU: Durante el proceso de aprendizaje o inferencia de modelos de IA, el CPU prepara los datos, y el GPU recibe esos datos, realiza los cálculos y luego envía los resultados de regreso al CPU. Este proceso de movimiento de datos consume más tiempo y energía de lo que podría pensarse. Los CPUs y GPUs están físicamente separados, y las interfaces como PCIe (PCI Express) utilizadas para la transferencia de datos a menudo no pueden igualar la impresionante velocidad de procesamiento del GPU.

NVIDIA comenzó a sentir la necesidad de un propio CPU que se colocara al lado de los GPUs para superar estas limitaciones y ofrecer soluciones de computación optimizadas para la era de IA. No importa cuán excelentes sean los GPUs, la eficiencia del sistema completo se verá afectada si no hay un CPU que los soporte eficazmente y permita una rápida transferencia de datos.

3. La llegada del CPU de NVIDIA: procesador 'Grace' basado en ARM

NVIDIA, en lugar de desarrollar directamente CPUs x86, ha puesto su atención en la arquitectura ARM, que es altamente eficiente energéticamente y fácil de personalizar. Y en 2022, formalizaron su entrada al mercado de CPUs al anunciar la CPU para centros de datos llamada 'NVIDIA Grace'.

-

Basado en ARM Neoverse: La CPU Grace está diseñada sobre el núcleo de servidor 'Neoverse' de ARM. Esto se puede interpretar como que NVIDIA prefiere utilizar la tecnología comprobada de ARM para entrar rápidamente en el mercado, en lugar de meterse en el diseño de núcleos de CPU directamente.

-

El núcleo de la estrategia de 'superchip': La verdadera fortaleza de la CPU Grace no radica solo en su rendimiento como CPU independiente, sino que se despliega completamente cuando se combina con el GPU de NVIDIA en forma de 'superchip'.

-

Superchip Grace Hopper: Es un producto que conecta la CPU Grace con el potente GPU H100 Hopper mediante un interconector de ultra alta velocidad llamado NVLink-C2C. Esta conexión ofrece un ancho de banda mucho más rápido que el PCIe convencional (más de 900GB por segundo), minimizando los cuellos de botella de datos entre CPU y GPU.

-

Superchip Grace Blackwell: Es una combinación del último diseño de arquitectura GPU Blackwell y la CPU Grace, diseñada para cargas de trabajo de AI de próxima generación y HPC (computación de alto rendimiento).

-

Esta estrategia de 'superchip' muestra la visión de NVIDIA de construir un sistema integrado que sea mucho más eficiente y poderoso al ofrecer un CPU personalizado optimizado para operaciones de GPU, en comparación con el uso separado de las CPUs x86 y los GPUs de NVIDIA.

4. Cambios radicales en el mercado de CPU y perspectivas futuras

La llegada de la CPU Grace de NVIDIA está formando un nuevo esquema competitivo en el mercado de CPU, que estaba dividido entre x86 (Intel, AMD) y ARM (Qualcomm, Apple, etc.).

-

Optimización para la era de IA: NVIDIA se está enfocando en CPUs para centros de datos especializadas en cargas de trabajo de AI y HPC, en lugar de en el mercado de CPUs de uso general. Esta es una estrategia para responder a la creciente demanda de computación de IA en todo el mundo.

-

Competencia y cooperación: Intel y AMD se encuentran en una relación complicada, compitiendo con NVIDIA en el mercado de aceleradores de IA, mientras continúan desarrollando CPUs x86 que funcionen bien con los GPUs de NVIDIA. Existen rumores de que NVIDIA podría utilizar los servicios de fundición de Intel según el caso, lo que indica diversos modelos de cooperación y competencia para el desarrollo tecnológico y la captura del mercado.

-

Importancia de soluciones integradas: En el futuro, será aún más importante que no solo el rendimiento de los componentes individuales, sino cómo el CPU, GPU, memoria e interconectores estén orgánicamente integrados y optimizados para un rendimiento específico en determinadas cargas de trabajo. La estrategia de 'superchip' de NVIDIA es un claro ejemplo de estas soluciones integradas.

Conclusión

Hoy hemos visto por qué el gigante de los GPUs NVIDIA ha ingresado al mercado de CPUs y cómo pretende cambiar el paradigma computacional de la era de IA a través de la CPU 'Grace' y la estrategia de 'superchip'. Es evidente que, más allá de la historia en la que los CPUs y GPUs complementaban los roles de los otros, ahora se dirigen hacia una integración e interacción más estrecha.

Se espera con gran interés cómo la incursión de NVIDIA en el CPU resultará en cambios y qué respuestas darán los gigantes del x86, así como cuál será el futuro final de la computación de IA. En la próxima publicación, volveremos con otra historia tecnológica interesante. ¡Gracias!

No hay comentarios.