La estética del tail de logs: el mundo de los bots que cruzan tu servidor

Una lluvia de texto blanco sobre la pantalla negra del terminal. Es un momento que cualquier sysadmin o desarrollador backend reconocerá. Cuando escribes tail -f access.log y observas los logs sin hacer nada más.

Mirar cómo los logs se acumulan sin cesar genera una extraña sensación de estabilidad. ¿Un tipo de “digital chill”? Pero incluso en esa calma, la curiosidad se despierta. "¿Quién está tocando la puerta de mi servidor ahora?"

Al analizar los logs con más detalle, descubres que la mayoría de las solicitudes no provienen de usuarios reales, sino de innumerables bots que navegan por la red. En esta publicación, clasificaremos los diferentes crawlers que aparecen mientras tailas los logs y describiremos sus características.

Bots: ¿invitados no deseados o visitantes útiles?

Los web crawlers, también llamados spiders, visitan sitios web con scripts automatizados para recopilar información.

1. Bots corteses (Polite Bots)

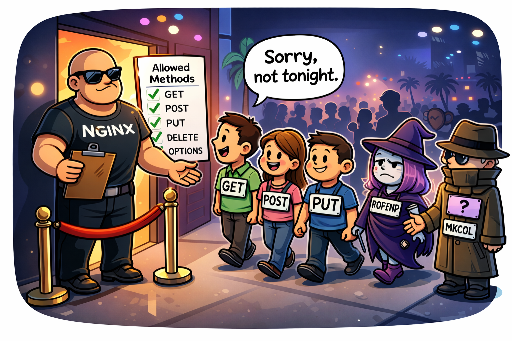

Bots que revelan su identidad (User‑Agent), respetan la normativa de robots.txt y visitan el servidor a intervalos razonables sin sobrecargarlo. Son aliados que traen beneficios como la aparición en motores de búsqueda.

2. Bots groseros (Bad Bots)

Ocultan su identidad disfrazándose de navegadores comunes (spoofing) o permanecen anónimos. Ignoran robots.txt y pueden lanzar peticiones a velocidades que se asemejan a un ataque DDoS, agotando recursos del servidor. Son la primera prioridad para bloquear en firewalls.

Dominando los bots principales

A continuación, una lista de los bots más frecuentes que aparecen en los logs, identificados por su cadena de User‑Agent. Analizaremos su propósito y características.

| Bot (User‑Agent) | Operador | Propósito y características | Rango de IP (referencia) |

|---|---|---|---|

| Googlebot | Crawler principal para indexación de Google. El visitante más querido. | 66.249.x.x (ver DNS) |

|

| Mediapartners‑Google | Bot de AdSense que analiza el contexto de la página para la entrega de anuncios. | 66.249.x.x |

|

| Google‑InspectionTool | Herramienta de Search Console para inspección de URLs. Se activa cuando un usuario solicita indexación manual. | 66.249.x.x |

|

| Bingbot | Microsoft | Crawler de Bing, el segundo motor de búsqueda más importante. | 157.55.x.x, 40.77.x.x |

| Yeti | Naver | Crawler de Naver, imprescindible para sitios coreanos. | 210.117.x.x, 114.111.x.x |

| DuckDuckBot | DuckDuckGo | Crawler de DuckDuckGo, enfocado en la privacidad. | 20.191.x.x (Azure) |

| YandexBot | Yandex | Crawler de Yandex, el mayor motor de búsqueda ruso. | 5.255.x.x, 77.88.x.x |

| Baiduspider | Baidu | Crawler de Baidu, el motor de búsqueda chino. Conocido por su agresividad. | 116.179.x.x, 220.181.x.x |

| GPTBot | OpenAI | Bot que recopila datos para entrenar modelos como ChatGPT. | 20.15.x.x (Azure) |

| ChatGPT‑User | OpenAI | Tráfico generado cuando un usuario de ChatGPT accede a enlaces externos. | - |

| Bytespider | ByteDance | Bot de la empresa matriz de TikTok. Recientemente muy agresivo. | 47.128.x.x y otros |

| PetalBot | Huawei | Crawler de Petal Search, centrado en móviles. | 114.119.x.x |

| AhrefsBot | Ahrefs | Herramienta de análisis SEO que puede generar carga significativa. | 54.36.x.x |

| SemrushBot | Semrush | Herramienta de marketing SEO similar a Ahrefs. | 46.229.x.x |

| DotBot | Moz | Herramienta de Moz para construcción de datos de enlaces. | 216.244.x.x |

| Amazonbot | Amazon | Crawler de Alexa y otros servicios de Amazon. | 52.95.x.x (AWS) |

| FreshRSS / Reeder | Open Source | Lectores de RSS que actualizan sus suscripciones. | IP del usuario |

| python‑requests / curl | - | Herramientas de scripting; pueden usarse para pruebas o ataques automatizados. | - |

| peer39_crawler | Peer39 | Herramienta de análisis de publicidad contextual. | - |

Clasificación subjetiva de los bots

Al observar los logs, he creado una clasificación personal de los bots. Esta jerarquía puede cambiar según la filosofía del operador y el objetivo del tráfico.

🏆 Grupo 1: Invitados VIP (¡Bienvenidos!)

"Son los que traen tráfico y son la razón de ser de mi servidor. Los más valiosos."

- Miembros:

Googlebot,Bingbot,Yeti,DuckDuckBot,Mediapartners‑Google,YandexBot,FreshRSS,Reeder - Motivo:

- Motores de búsqueda (

Googlebot,Yeti,Bingbot): Sin ellos, el sitio sería un archipiélago. - YandexBot: Importante si te interesa el tráfico ruso y de Europa del Este.

- Suscriptores de RSS (

FreshRSS,Reeder): Usuarios que realmente quieren leer tu contenido.

😐 Grupo 2: Ciudadanos comunes (Pasa, no es malo)

"No aportan mucho de inmediato, pero tienen potencial o son inofensivos."

- Miembros:

Baiduspider,ChatGPT‑User,Google‑InspectionTool,Amazonbot - Motivo:

- Baiduspider: Gran mercado potencial en China.

- Otros: No causan daño y son señales de que alguien está consultando tu contenido.

😤 Grupo 3: Invitados no deseados (No vengan…)

"Tienen un nombre, pero no aportan nada y solo consumen recursos."

- Miembros:

Bytespider,PetalBot,AhrefsBot,SemrushBot,DotBot,python‑requests,curl - Motivo:

- Crawlers agresivos (

Bytespider,PetalBot): Recopilan de forma descontrolada. - Herramientas SEO (

Ahrefs,Semrush): Usan tus datos sin devolver tráfico. - Scripting sin identidad (

python‑requests,curl): Probablemente scraping no autorizado o escaneo de vulnerabilidades.

Conclusión

El tail de logs va más allá de la simple monitorización; es una ventana que muestra cómo tu servidor interactúa con la red global.

Aunque a veces quieras bloquear a bots como Bytespider con iptables, la honestidad de su User‑Agent y su presencia constante me hacen pensar que, al menos, es un mínimo de respeto. Reflexiono mientras observo los logs fluir.

"Si al menos dicen quiénes son, los dejo entrar. Pero que no se excedan."

No hay comentarios.