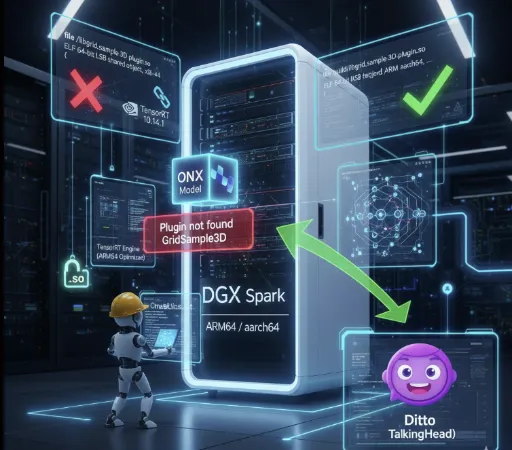

La experiencia de ejecutar un LLM (Modelo de Lenguaje Grande) en un entorno local varía drásticamente según las especificaciones del hardware. En los últimos años, he sentido las limitaciones de operar modelos GGUF en una PC de especificaciones medias, y quiero compartir mi experiencia tras la implementación de la estación de trabajo de alto rendimiento, Spark (DGX Spark), y cómo ha cambiado el entorno de investigación de IA local.

1. Era GGUF: La estética de la compensación y la eficiencia

Antes de la implementación de Spark, mi equipo principal contaba con un CPU i7 12700F, 32GB de RAM y una RTX 2060 12GB. En esta configuración, la única opción para operar un modelo de lenguaje gigante era el GGUF (Formato Unificado Generado por GPT).

La trampa de la cuantización

En ese momento, el criterio para elegir un modelo no era el rendimiento, sino la 'posibilidad de operación'. Al buscar en Hugging Face, me acostumbraba a buscar la etiqueta GGUF y me perdía buscando el formato Q4_K_M.

- Q4_K_M: Formato que comprime los parámetros del modelo a 4 bits, reduciendo el uso de memoria mientras minimiza la disminución del rendimiento.

La VRAM de 12GB de la RTX 2060 apenas podía soportar modelos de 7B, o necesitaba hacer offloading en la RAM del sistema, lo que resultaba en velocidades lentas. Mientras disfrutaba de la simple satisfacción de que “funcionaba”, claramente estaba operando en un entorno comprometido.

2. Las limitaciones de la inferencia simple y la duda

Ejecutar un LLM localmente a través de GGUF era interesante, pero pronto me enfrenté a una duda fundamental.

"Si solo se trata de inferencia, ¿realmente es necesario un entorno on-premise?"

Si el objetivo es solo hacer preguntas y generar texto, ya existen en el mundo opciones altamente eficientes como Google Gemini o OpenAI GPT. El costo de las API de investigación puede ser mucho más barato que construir una estación de trabajo personal. La posibilidad de descargar y ejecutar modelos creados por otros (solo inferencia) debilitó la justificación para construir un entorno local.

3. La llegada de Spark y el mundo del FP16

Después de invertir alrededor de $4,000 en una máquina Spark, mi entorno de investigación de IA cambió completamente. Lo primero que cambió fue mi actitud hacia los modelos.

Safetensors y precisión total

Ya no busco GGUF. Ahora descargo directamente el modelo original basado en FP16 (Media Precisión) en formato .safetensors.

Velocidad y calidad: La calidad de inferencia del modelo original sin pérdidas por cuantización es definitivamente diferente. Además, gracias a la potente GPU, la velocidad de inferencia también es satisfactoria.

- La diferencia de velocidad es evidente.

- Entorno RTX 2060: Mistral 7B GGUF Q4_K_M → aproximadamente 10–20 tokens/s

- Entorno Spark (GPT-OSS-20B FP16): aproximadamente 80–90 tokens/s

- Entorno Spark (GPT-OSS-120B FP16): aproximadamente 40–50 tokens/s

A velocidades que no son posibles en laptops o PCs de precios similares, es notable que incluso usando modelos FP16 sin pérdidas por cuantización se obtiene este nivel de rendimiento de inferencia, cambiando por completo el paradigma de investigación de IA local.

Cuantización flexible: Si es necesario, puedo intentar cuantizar a FP8 o FP4 por mi cuenta. No se trata de usar un archivo convertido por alguien más, sino de tener el control para adaptarlo a mis objetivos de investigación.

4. Verdadero valor: Fine-Tuning de LoRA

Una de las razones clave por las que creo que la adopción de Spark fue “una excelente decisión” es porque he entrado en el territorio de entrenamiento (Training).

En especificaciones anteriores, ni siquiera podía pensar en fine-tuning debido a las dificultades con la inferencia. Pero ahora puedo realizar directamente LoRA (Adaptación de Bajo Rango), que solo había estudiado teóricamente.

-

Experiencia práctica: Preparar conjuntos de datos, ajustar hiperparámetros y ajustar finamente el modelo proporciona una experiencia de profundidad incomparable con la simple inferencia.

-

Mi propio modelo: La posibilidad de crear un modelo especializado en un dominio específico o en mi estilo, en lugar de un modelo general, es el verdadero atractivo del entorno on-premise.

Un entorno donde no solo es posible la inferencia, sino también el aprendizaje, es la razón por la que no siento que $4,000 sea una inversión excesiva.

5. El valor aún relevante de GGUF

Por supuesto, no estoy negando el valor de GGUF solo porque mi entorno haya cambiado.

La esencia de GGUF no radica en el 'rendimiento absoluto', sino en la accesibilidad.

Es casi el único formato que permite ejecutar modelos de lenguaje grandes sin una GPU costosa, solo con CPU o GPU de baja especificación. Sin embargo, debido a su naturaleza de cuantización, no se pueden evitar la pérdida de precisión y la degradación de la calidad de inferencia, así como la inestabilidad en el procesamiento de contextos largos. En otras palabras, GGUF tiene la ventaja de ser un “modelo que cualquiera puede ejecutar” y, al mismo tiempo, la dualidad de las “limitaciones en calidad, velocidad e coherencia”.

Y GGUF sigue siendo un excelente formato en términos de democratización de la IA. No todos los usuarios necesitan fine-tuning, y no todos pueden equiparse con costosos equipos. La ecosfera GGUF, que ofrece el mejor rendimiento de inferencia en entornos estandarizados para usuarios ocasionales, creo que se volverá aún más popular con el avance de las capacidades de las PCs personales. En unos años, podríamos ver modelos en formato GGUF operando en tablets o nuestros teléfonos móviles.

Conclusión

Si la época de ejecutar modelos Q4_K_M en la RTX 2060 fue un 'aperitivo', ahora con Spark me siento como si estuviera 'cocinando'.

El mundo de la IA local es donde se puede encontrar el verdadero deleite no solo en ejecutar modelos, sino en entender, modificar y personalizarlos. Si sientes sed por una comprensión estructural de los modelos y la personalización más allá de la mera inferencia, la inversión en hardware será la clave más segura para saciar esa sed.

No hay comentarios.