Der KI-Spracherkennungsmarkt hat mit Innovationen begonnen. Im Mai veröffentlichte NVIDIA ein nachfolgendes Open-Source-Spracherkennungsmodell parakeet-tdt-0.6b-v2, das Whisper herausfordert. Dieses Modell, das für GPUs optimiert ist, zeigt starke kommerzielle Nutzungsmöglichkeiten in Bereichen wie Echtzeit-Sprachverarbeitung, automatisierte Protokollerstellung, Audio-Transkription, KI-Spracherkennungs-API, und inhaltliche Erstellung auf Basis von Werbeeinnahmen, und wackelt damit die Spielregeln im Markt für KI-Spracherkennung.

Schneller Spracherkennungs-Engine basierend auf FastConformer + TDT

parakeet-tdt-0.6b-v2 ist ein Modell, das nur Englisch erkennt und hat etwa 600 Millionen Parameter. Dieses Modell besteht aus zwei technologischen Strukturen:

- FastConformer-Encoder: Dieser analysiert die Merkmale von Sprache effektiv und ist darauf ausgelegt, sehr schnell auf NVIDIA-Grafikkarten (GPU) zu arbeiten. Dies ermöglicht eine schnellere und genauere Verarbeitung komplexer Sprache.

- TDT-Decoder (Transducer-Decoder Transformer): Eine Struktur, die stark darin ist, Klänge in Schrift zu verwandeln, und besonders lange Audiodateien stabil ohne Unterbrechungen verarbeiten kann.

Dank dieser beiden Strukturen ist das Modell optimiert, um Audios, egal wie lang sie sind, schnell und genau in Echtzeit in Text zu verwandeln.

Geschwindigkeit Tausende Male schneller als Whisper, optimal für kommerzielle Dienste

Laut offiziellen Benchmarks:

- RTFx (Real Time Factor): 3386.02 (basierend auf Batch 128)

- WER (Word Error Rate): 6.05%

Während Whisper-large-v3 einen durchschnittlichen RTFx von 2 bis 5 hat, kann Parakeet mit tausendmal schnellerer Geschwindigkeit aufwarten.

Die experimentellen Ergebnisse waren noch beeindruckender. Ich verwendete absichtlich eine 3 Minuten und 40 Sekunden lange Musikaufnahme mit gemischten Hintergrundgeräuschen, anstatt nur einer klaren Sprachaufnahme. Die Transkription dauerte nur 13 Sekunden. In diesem erstaunlichen Ergebnis waren folgende Faktoren enthalten:

- Trotz des Hintergrundgeräuschs wurde der Zeitstempel genau zugeordnet

- Automatisierung von Satzzeichen und Groß- und Kleinschreibung war nahezu perfekt

- Für das Wort 'you' wurde 'ya' geschrieben, was Akzent und Ausdruck des tatsächlichen Sprechers lebhaft widerspiegelt

Wenn jedoch Audios in Japanisch oder Koreanisch getestet wurden, gab es keine Ausgabe. Es war klar, dass es ein Englisch-sprachiges ASR-Modell ist.

Vergleich der KI-Spracherkennungs-Engines: NVIDIA Parakeet vs OpenAI Whisper

| Element | NVIDIA Parakeet | OpenAI Whisper |

|---|---|---|

| Unterstützte Sprachen | Nur Englisch | Mehrsprachig (über 98) |

| Modellstruktur | FastConformer + TDT | Convolution + Transformer |

| Geschwindigkeit (RTFx) | Über 3000 | 2–5 |

| Lizenz | Open Source (kommerzielle Nutzung möglich) | Open Source (kommerzielle Nutzung möglich) |

| Robustheit der Audioqualität | Stark auch bei Musik in Audio | Relativ schwach |

| Multimodale Verbindung | Keine | GPT-Verknüpfungen möglich |

Whisper hat einen Vorteil bei der mehrsprachigen Verarbeitung, aber Parakeet übertrifft in Echtzeit-Sprachverarbeitung und Genauigkeit.

Überlegungen für die kommerzielle Nutzung

- Keine Unterstützung für Sprachen außer Englisch (Tests auf Koreanisch/Japanisch waren negativ)

- Könnte in lauten Umgebungen empfindlicher sein als Whisper

- Multimodale Analysen (z.B. semantische Interpretationen) werden nicht unterstützt

Dennoch gibt es genügend Erwartungselemente, wie:

- Feinabstimmung auf Mehrsprachigkeit wie mit Common Voice möglich

- Hohe praktische Anwendbarkeit für automatisierte Protokollerstellung, Gerichtsprotokolle, Interviewtranskriptionen usw.

- Einfach aufdienend als Backend für Whisper-basierte Dienste

- Geeignet als Engine für KI-Spracherkennungs-API-Dienste

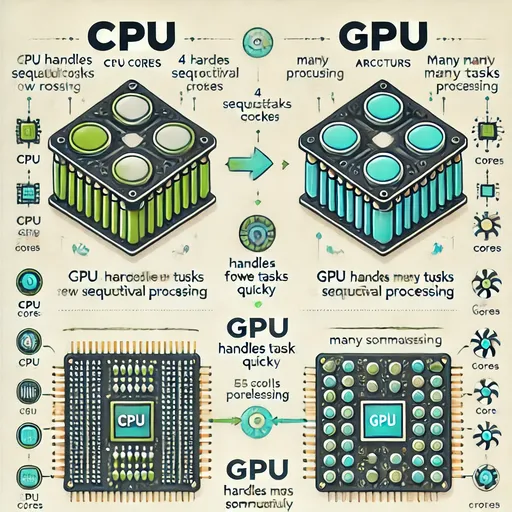

Technologische Innovation: Echtzeit-Verarbeitungsstrukturen auf CTC-Basis

Der Schlüssel zur Geschwindigkeitsmaximierung von Parakeet liegt in der CTC (Connectionist Temporal Classification)-Methode. Sprachdaten sind lang und komplex und jedes Wort wird zu einem anderen Zeitpunkt gesagt. Die präzise Umwandlung in Text entsprechend der Sprechreihenfolge ist jedoch schwieriger als gedacht.

CTC ist eine Technik, die wichtige Informationen aus diesen komplexen Audioflüssen extrahiert und automatisch ausrichtet und zuordnet, wo welcher Buchstabe hinsoll. Darüber hinaus kann CTC mehrere Teile gleichzeitig behandeln, was es sehr schnell macht.

Dank dessen kann Parakeet Echtzeit-Sprachaufnahmen entgegennehmen und ohne Verzögerung Buchstaben- und Wortweise ausgeben, unabhängig von der Länge des Audios konstant schnell bleiben. Man könnte sagen, es funktioniert wie ein schriftlicher Dolmetscher in Echtzeit, aber mit einem viel schnelleren Algorithmus.

NeMo + Hugging Face: Integrierte KI-Ökosystemstrategie

Das Parakeet-Modell stärkt die Ökosystemstrategie von NVIDIA durch eine integrierte Struktur:

- Vollständige Integration mit NeMo Toolkit

- Pipeline, die direkt von Hugging Face genutzt werden kann

- GPU-optimiertes Modell, das Hardwarebedarf anregt

Dies ist nicht nur ein Modell, sondern eine strategische Handlung, die sich als “das am schnellsten auf NVIDIA-Hardware arbeitende Open-Source-KI-Modell” positioniert.

Fazit: Eine neue Waffe für Entwickler von AI-Transkriptionsdiensten

Whisper ist nach wie vor stark. Aber jetzt ist Whisper nicht mehr die einzige Lösung.

NVIDIA Parakeet ist:

- Ein Open-Source-Modell, das für kommerzielle Nutzung geeignet ist

- Eine KI-spracherkennungsengine, die für Echtzeit-Transkriptionen optimiert ist

- Vielseitig in der praktischen Integration, von automatisierter Protokollerstellung über Audio-Inhaltstranskription bis hin zur Erstellung von inhaltsbasiert auf Werbung

- Ideal für den Betrieb von KI-Spracherkennungsinhalten, die mit hochpreisigen Google AdSense-Keywords verbunden sind.

Für alle Entwickler und Dienstplaner, die sich mit Echtzeits-Sprachverarbeitung, KI-Audio-Transkriptionsdiensten und GPU-optimierten Spracherkennungssystemen beschäftigen, wird NVIDIA Parakeet ein strategisches Gegenmittel mit Geschwindigkeit, Qualität und Kommerzialisierung sein.

Es sind keine Kommentare vorhanden.