NVIDIA DGX Spark - Die Geburt eines kompakten GPU-Servers für On-Premises AI

Im Mai 2025 wird NVIDIA voraussichtlich einen kleinen Hochleistungs-GPU-Server namens DGX Spark als neuen Standard für AI-Infrastrukturen präsentieren. Das offizielle Erscheinungsdatum steht noch nicht fest, aber durch die veröffentlichten Spezifikationen und die Strategie von NVIDIA wollen wir im Voraus verstehen, was für eine Maschine dieses Produkt ist und wie es in AI-bezogenen Geschäftsfeldern eingesetzt werden kann.

Was ist DGX Spark?

DGX Spark ist eine On-Premises AI-Lösung, die auf der Philosophie der bestehenden DGX-Systeme (z. B. DGX H100, A100) aufbaut und in einem kompakten Formfaktor starke AI-Leistung bietet.

✅ Hauptziele

- Eigene AI-Infrastruktur für AIs-Startups, Klein- und Mittelunternehmen, Forschungseinrichtungen aufbauen

- Eine Cloud-Alternative in Umgebungen, in denen Datenschutz und Datensouveränität wichtig sind

- Optimierung von Experimenten und Inferenz mit niedrigem Stromverbrauch, geräuscharm, Desktop-GPU-Servern

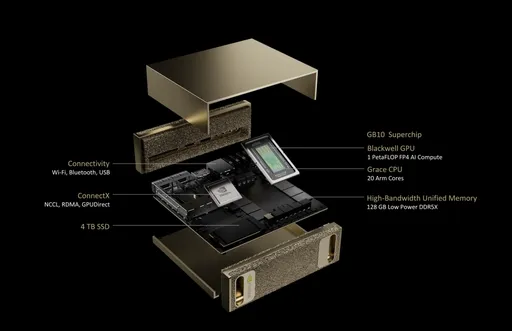

Erwartete Spezifikationen von DGX Spark (basierend auf veröffentlichten Informationen)

| Element | Spezifikationen (erwartet oder geleakt) |

|---|---|

| GPU | 1-2 NVIDIA Blackwell-basierte GPUs (z. B. B100 oder GB200) |

| Speicher | 128 GB - 192 GB HBM3e |

| Speicher | Schnelle NVMe SSD (TB-basiert erweiterbar) |

| Netzwerk | 10/100 Gb Ethernet oder NVLink-Unterstützung möglich |

| Stromverbrauch | 800 W - 1200 W erwartet |

| Formfaktor | Desktop Tower oder 4U Rack-Mount |

⚠️ Die Spezifikationen werden bei der offiziellen Veröffentlichung aktualisiert.

Typische Anwendungsgebiete von DGX Spark

1. Plattform für lokales AI-Modelltraining und Feintuning

- Selbstentwicklung von mittelgroßen LLMs, Vision-Modellen usw.

- Internes AI-F+R-Experimentierumfeld auf GPU-Server-Basis

2. On-Premises AI-Inferenz Infrastruktur

- Geeignet für den Aufbau von privaten Chatbots, Dokumentensuche, Edge AI-Analyserver

- Erwartete Nachfrage in Branchen, die AI-Datensicherheit und Cloud-Alternativen benötigen

3. Edge AI-Bereitstellung und industrielle Automatisierung

- Geeignet für Edge Computing-Umgebungen in Bereichen wie Fertigung, Finanzen, Gesundheitswesen

- In Kombination mit NVIDIA AI Enterprise kraftvolle GPU-basierten Inferenzoptimierungen möglich

4. GPU-Experiment-Infrastruktur für Bildungseinrichtungen, Forschungsinstitute und Startups

- Statt teurer DGXs Leistung mit kleinen GPU-Servern maximieren

- Eine realistische Lösung für Nutzer, die die Cloud-GPU-Kosten ersetzen möchten

Warum wird DGX Spark in der Industrie beachtet?

- Der Markt für On-Premises AI-Infrastruktur wächst, mit zunehmender Nachfrage nach Risikominderung bei der Cloud

- Wachsendes Interesse an kompakten Hochleistungsgeräten auf dem GPU-Server-Markt

- Steigender Bedarf an lokalen Inferenzservern aufgrund von Datensouveränitäts- und Sicherheitsfragen

- Entspricht dem Trend der Edge AI, AI-Inferenzoptimierung und Privatcluster-Betrieb

Fazit: Für wen ist der AI-GPU-Server gedacht?

DGX Spark ist: - Ein AI-Supercomputer auf dem Schreibtisch, kein großes Rechenzentrum - Eine realistische Wahl für Teams, die eine Cloud+On-Premises-Hybridstrategie verfolgen - Vielseitig einsetzbar für AI-F+R, datenempfindliche Dienstleistungen, industrielle Edge-Bereitstellungen

NVIDIA DGX Spark ist mehr als nur ein Server. In einer Zeit, in der das Computing des AI-Zeitalters von der Cloud zurück vor Ort kommt, gibt es eine hohe Wahrscheinlichkeit, dass es der Standard für private GPU-Infrastrukturen wird.

Es sind keine Kommentare vorhanden.