Die Erfahrung, ein LLM (Large Language Model) in einer lokalen Umgebung zu betreiben, variiert stark je nach Hardware-Spezifikationen. In den letzten Jahren habe ich an einem PC mit mittlerer Ausstattung die Grenzen des GGUF-Modells erlebt und möchte nun meine Erfahrungen über die veränderte Forschungsumgebung nach der Einführung des Hochleistungs-Workstations Spark (DGX Spark) teilen.

1. GGUF-Ära: Die Ästhetik von Kompromiss und Effizienz

Vor der Einführung von Spark war meine Hauptausstattung ein i7 12700F CPU, 32GB RAM und eine RTX 2060 12GB. Die einzige Wahl, um ein großes Sprachmodell in dieser Spezifikation zu betreiben, war GGUF (GPT-Generated Unified Format).

Der Sumpf der Quantisierung

Die Kriterien für die Modellwahl waren damals weniger auf Leistung als auf die 'Betriebsfähigkeit' ausgerichtet. Wenn ich auf Hugging Face unterwegs war, suchte ich routinemäßig nach dem GGUF-Tag und durchforstete gezielt nach dem Q4_K_M-Format.

- Q4_K_M: Ein Format, das die Parameter des Modells auf 4 Bit komprimiert, um den Speicherverbrauch zu reduzieren und gleichzeitig die Leistungsminderung zu minimieren.

Der 12GB VRAM der RTX 2060 erlaubte es mir nur, ein 7B-Modell mühsam zu betreiben oder durch Offloading in den Systemspeicher die langsamen Geschwindigkeiten zu ertragen. Ich fühlte mich zwar zufrieden mit der Tatsache, dass es „funktionierte“, dennoch war es offensichtlich eine kompromittierte Umgebung.

2. Die Grenzen und Zweifel der einfachen Inferenz

Das Betreiben eines LLM lokal über GGUF war spannend, aber bald stieß ich auf eine grundlegende Frage.

„Ist eine On-Premise-Umgebung wirklich notwendig, wenn es nur um die Inferenz geht?“

Wenn das Ziel darin besteht, einfach Fragen zu beantworten und Texte zu generieren, gibt es bereits überwältigend leistungsstarke Lösungen wie Google Gemini oder OpenAI GPT. Die Kosten für Forschungs-APIs sind möglicherweise viel günstiger als die Kosten für den Aufbau eines eigenen Workstations. Das bloße Ausführen eines heruntergeladenen Modells (Inferenz nur) mindert die Notwendigkeit, eine lokale Umgebung einzurichten.

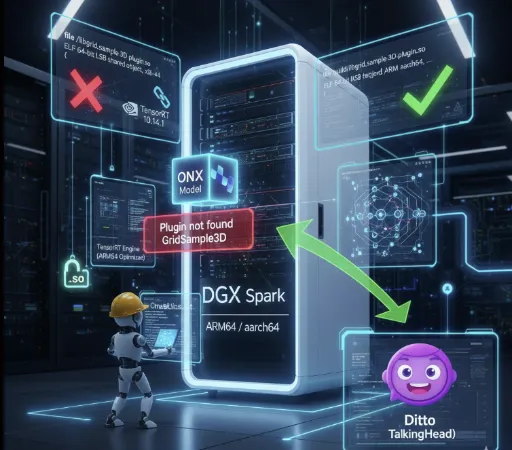

3. Die Einführung von Spark und die Welt von FP16

Nachdem ich etwa 4.000 US-Dollar in die Spark-Maschine investiert hatte, hat sich meine KI-Forschungsumgebung vollkommen verändert. Das erste, was sich änderte, war meine Einstellung zu Modellen.

Safetensors und volle Präzision

Ich suche nicht mehr nach GGUF. Jetzt lade ich einfach das Originalmodell basierend auf FP16 (Halbe Präzision) als .safetensors herunter.

Geschwindigkeit und Qualität: Die Inferenzqualität des Originalmodells ohne Quantisierungsverlust ist definitiv anders. Darüber hinaus sorgt die Hochleistungs-GPU auch für ein angenehmesInference-Geschwindigkeit.

- Der tatsächliche Geschwindigkeitsunterschied ist drastisch.

- RTX 2060-Umgebung: Mistral 7B GGUF Q4_K_M → etwa 10–20 tokens/s

- Spark-Umgebung (GPT-OSS-20B FP16): etwa 80–90 tokens/s

- Spark-Umgebung (GPT-OSS-120B FP16): etwa 40–50 tokens/s

In diesem Preisbereich war es mit Laptops oder PCs nicht möglich, solche Geschwindigkeiten zu erreichen, und die Tatsache, dass selbst das FP16-Modell ohne Quantisierungsverlust diese Inferenzleistung bringen kann, hat das Paradigma der lokalen KI-Forschung völlig verändert.

Flexible Quantisierung: Wenn nötig, versuche ich persönlich FP8 oder FP4 zu quantisieren. Ich benutze nicht das, was jemand anderes konvertiert hat, sondern kann es direkt nach meinen Forschungszwecken anpassen.

4. Der wahre Wert: LoRA-Fine-Tuning

Der Hauptgrund, warum ich die Einführung von Spark als „eine sehr gute Entscheidung“ betrachte, ist, dass ich in den Bereich des Trainings eingetreten bin.

Früher war das sogar für die Inferenz ein großer Aufwand, so dass ich nicht einmal von Fine-Tuning träumen konnte. Aber jetzt kann ich LoRA (Low-Rank Adaptation), das ich nur theoretisch studiert habe, tatsächlich durchführen.

-

Praktische Erfahrungen: Das Vorbereiten von Datensätzen, das Anpassen von Hyperparametern und das Feintuning des Modells bieten eine tiefere Erfahrung als einfache Inferenz.

-

Mein eigenes Modell: Die Möglichkeit, ein Modell zu erstellen, das nicht allgemein, sondern auf spezifische Domänen oder meinen eigenen Stil spezialisiert ist, ist der wahre Reiz einer On-Premise-Umgebung.

Eine Umgebung, die sowohl Inferenz als auch Training ermöglicht, ist der Grund, warum die Kosten von 4.000 US-Dollar nicht verschwendet wirken.

5. Der immer noch gültige Wert von GGUF

Natürlich bedeutet es nicht, dass ich den Wert von GGUF ablehne, nur weil sich meine Umgebung geändert hat.

Die Essenz von GGUF liegt nicht in der „absoluten Leistung“, sondern in der Zugänglichkeit.

Es ist fast das einzige Format, das es ermöglicht, große Sprachmodelle nur mit CPU- und Low-Spec-GPU ohne teure GPUs zu betreiben. Allerdings hat es aufgrund der Quantisierungseigenschaften auch Präzisionsverluste und eine Verschlechterung der Inferenzqualität sowie Instabilität bei der Verarbeitung langer Kontexte. Mit anderen Worten, GGUF besitzt den Vorteil eines „Modells, das jeder betreiben kann“ und trotzdem die „Grenzen der Qualität, Geschwindigkeit und Konsistenz“ in einer einzigen Form hat.

Darüber hinaus ist GGUF nach wie vor ein hervorragendes Format im Hinblick auf die Demokratisierung von KI. Nicht alle Benutzer benötigen Fine-Tuning und nicht jeder kann teure Ausrüstung anschaffen. Das GGUF-Ökosystem bietet den leichten Benutzern einen optimalen Inferenzleistungsstandard, und ich denke, es wird sich mit der fortschreitenden Leistungsentwicklung des persönlichen PCs weiter verbreiten. In ein paar Jahren könnten Modelle im GGUF-Format auf Tablet-PCs oder unseren Handys laufen.

Fazit

Wenn die Zeit, in der ich das Q4_K_M-Modell auf RTX 2060 betrieben habe, ein 'Vorgeschmack' war, fühle ich mich jetzt, wo ich mit Spark arbeite, wie beim 'Kochen'.

Die Welt der lokalen KI geht über einfaches Betriebsmodelling hinaus und ermöglicht es, wahres Vergnügen bei dem Verständnis, der Modifikation und dem Eigenmachen von Modellen zu finden. Wenn Sie das Bedürfnis nach strukturellem Verständnis und Anpassungen jenseits der einfachen Inferenz haben, wird eine Investition in Hardware der sicherste Schlüssel sein, um dieses Bedürfnis zu stillen.

Es sind keine Kommentare vorhanden.