RTX 4090與DGX Spark的區別 – 適合考慮本地AI基礎設施的企業的比較分析

最近,正在考慮AI基礎設施建設的企業或開發者或許曾經思考過: 「現在用RTX 4090就已經足夠了,那麼DGX Spark真的有必要嗎?」

這篇文章是對這個問題的謹慎探索。作為一個目前已經預定了DGX Spark並在等待發貨的人,我基於使用RTX 4090的經驗,整理了我所感受到的限制與期待。

GPU伺服器 vs 高性能工作站 – 哪種基礎設施更適合AI優化?

| 項目 | RTX 4090 工作站 | DGX Spark |

|---|---|---|

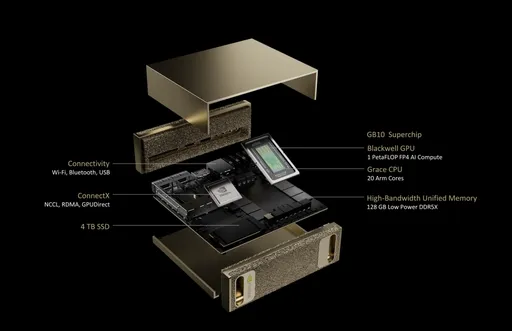

| GPU架構 | Ada Lovelace | NVIDIA Blackwell |

| CPU | 使用外部CPU | 20核Arm (10×Cortex-X925 + 10×Cortex-A725) |

| 記憶體 | 24GB GDDR6X | 128GB LPDDR5x (集成內存) |

| 記憶體帶寬 | 1,008 GB/s | 273 GB/s |

| 儲存設備 | 用戶自定義SSD | 1TB或4TB NVMe M.2 (支持加密) |

| 網絡 | 選項 | 10GbE + ConnectX-7智能NIC |

| 電力消耗 | 約450W~600W | 170W |

| 系統尺寸 | ATX或塔式 | 150 x 150 x 50.5 mm (1.2kg) |

| 操作系統 | 用戶安裝Windows或Linux | NVIDIA DGX Base OS (基於Ubuntu) |

▶ 關鍵差異: 比起單純的性能,「是否為AI設計」才是核心。

產業中重要的差異: 本地AI基礎設施的優化

考慮採用AI基礎設施的企業,重視的並不僅僅是運算速度。以下產業定制的差異是實際選擇的標準:

- AI數據安全與數據主權: 對於無法傳送到雲端的數據處理至關重要

- 邊緣AI部署: 製造/金融/醫療領域對私有GPU伺服器需求急劇上升

- AI推斷穩定性: 伺服器級電力設計實現24/7推斷運行

- 集群整合: Grace CPU + Blackwell GPU的結構能夠進行單一機器的高密度運算

從這些方面來看,DGX Spark並不僅僅是普通的GPU設備,而是一個私有AI基礎設施解決方案。

總擁有成本(TCO)與投資效率 – 本地AI基礎設施的ROI是什麼?

| 比較項目 | RTX 4090 單一系統 | DGX Spark |

|---|---|---|

| 初始設備價格 | 約$3,500 ~ $5,000 | $4,000 (根據NVIDIA官方公告) |

| 運營費用 | 需考慮電力、發熱,執行自我管理 | 基於ARM的低功耗設計,電力效率與維護成本降低 |

| 投資對象 | 個人或小型實驗 | 企業用模型訓練/推斷平台 |

▶ 價格相近或DGX Spark的價位更低,但如果考慮運營效率及系統整合價值在長期的總擁有成本(TCO)中具有競爭力。

個人開發者?創業公司?誰更適合?

- RTX 4090更適合的情況:

- 模型較小,重點在個人學習及實驗

- 混合使用雲端的開發者

-

對成本敏感的自由職業者/研究人員

-

DGX Spark適合的情況:

- 需要內部部署/調優的LLM,需要保護數據主權的企業

- 希望提高ROI的行業用戶

- 希望自我運營24小時推斷服務的團隊

結論: 現在雖然是「等待中」,但選擇的標準卻是清楚的

RTX 4090至今依然是優秀的GPU。 但我期待著DGX Spark所帶來的「AI伺服器的標準化」,並在等待中。

單純比速度更重要的是: - 基於何種系統運營AI - 如何安全、可持續及具成本效益地建立AI基礎設施。

期待有一天寫下我的使用體驗,這個比較能成為明智選擇的標準。

目前沒有評論。