來到這篇文章的朋友們,肯定是想開始利用GPU進行深度學習開發的人。這篇文章是整理在Ubuntu環境下準備基於CUDA的GPU運算過程的實戰指南。

特別是對於初學者們想要"我的PC上CUDA是否正確安裝?"的檢查,可以跟著這裡的內容操作。

如果您對CUDA的概念感到好奇,可以先參考之前的文章 CUDA是什麼?GPU與並行計算的開始。

1. 為什麼要設置GPU環境?

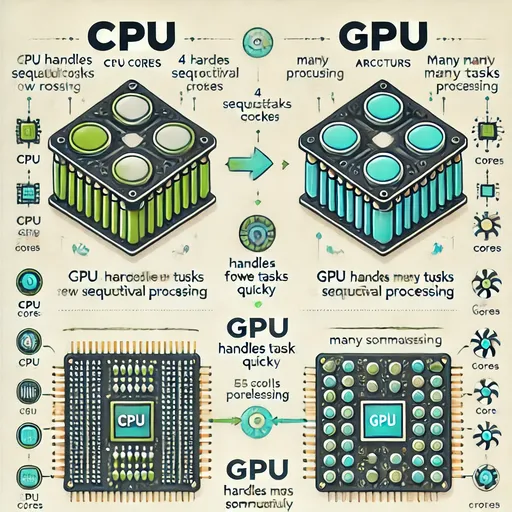

AI模型訓練需要大量的矩陣運算。

這些運算在專門優化為並行運算的GPU上將進行得更快。

但擁有GPU還不夠。

必須準確安裝以下三項才能使用GPU:驅動程式,

能在GPU上進行運算的CUDA,

針對深度學習優化的庫cuDNN。

2. 確認我的GPU狀態 – 是否有驅動程式和CUDA?

nvidia-smi

這是一個展示GPU當前狀態的工具。

如果您看到CUDA版本,並且GPU名稱正確顯示,

這意味著「GPU已正常識別,驅動程式也已安裝」。

3. CUDA開發工具 – nvcc為什麼需要?

nvcc是編譯CUDA程式碼(.cu)的工具。

比方說,CUDA是“真正使用所需的編譯器”。

sudo apt update

sudo apt install nvidia-cuda-toolkit

nvcc --version

4. cuDNN – 讓深度學習運算在GPU上快速進行的秘密武器

cuDNN是NVIDIA專為深度學習優化的高速數值運算庫。

它在深度學習框架(如PyTorch、TensorFlow等)中使用

- 卷積

- 池化

- RNN

- LSTM

- BatchNorm

- 激活等運算

計算可以在GPU上進行得非常快速而高效。

計劃使用PyTorch、TensorFlow等深度學習框架的人,這絕對是必須的庫。

必須安裝與CUDA版本相對應的cuDNN包,才能讓框架有效地使用GPU。

cuDNN包的下載路徑因操作系統和CPU架構而異,下載時請務必前往NVIDIA的官方cuDNN下載頁面,下載適合您的庫並進行安裝。

通過上述鏈接下載cuDNN時,請確認最初在nvidia-smi中查看的自己的CUDA版本,並安裝匹配的cuDNN。

5. 測試 – 確認Python中GPU是否能工作

完成安裝後,讓我們檢查一下它是否正常運行。

import torch

print(torch.cuda.is_available()) # True

print(torch.cuda.get_device_name(0)) # NVIDIA GeForce RTX XXXX

6. 總結

| 組件 | 你的行動 | 為什麼這麼做 |

|---|---|---|

| NVIDIA驅動程式 | 檢查安裝狀態 (nvidia-smi) |

使GPU被系統識別 |

| CUDA Toolkit | nvcc 安裝 |

用於運行CUDA程式碼的編譯器 |

| cuDNN | cudnn-cuda-12 安裝 |

深度學習運算優化庫 |

| PyTorch測試 | 確認GPU連接 | 檢查是否能夠進行實際運算 |

7. Jesse的總結

現在,您的系統已經為GPU運算做好了準備。

您可以在此環境中快速訓練或運行Whisper、LLaMA、ChatGPT等各種模型。

目前沒有評論。