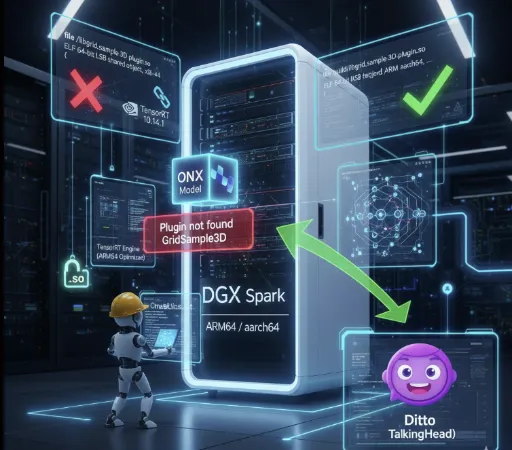

在本地环境中运行LLM(大型语言模型)的体验因硬件规格的不同而截然不同。过去几年,我在中等配置的电脑上运行GGUF模型所感受到的局限性,以及引入高性能工作站Spark(DGX Spark)后发生的本地AI研究环境的变化,想在此与大家分享。

1. GGUF时代:妥协与效率的美学

在引入Spark之前,我的主力设备是i7 12700F CPU、32GB RAM,以及 RTX 2060 12GB。在这个配置下,运行大型语言模型的选择只有一个,GGUF(GPT生成统一格式)。

量化(Quantization)的泥潭

当时选择模型的标准不是性能而是“能否运行”。每当在Hugging Face上搜索时,我都习惯性地搜索 GGUF 标签,尤其是在其中寻找 Q4_K_M 格式。

- Q4_K_M: 将模型参数压缩为4位以减少内存使用,同时将性能下降降到最低的格式。

RTX 2060的12GB VRAM只能勉强运行7B模型,或者通过系统内存进行卸载以承受缓慢的运行速度。虽然对“能运行”这一事实感到满意并乐在其中,但显然这是一个妥协的环境。

2. 简单推理(Inference)的局限与怀疑

通过GGUF在本地运行LLM是令人兴奋的,但很快就遇到了根本性的问题。

“如果只是做推理,是否真的需要本地环境?”

如果仅仅是进行问答和生成文本,那么已经有拥有压倒性性能的 Google Gemini 和 OpenAI GPT 存在,研究用API的费用甚至可能比个人工作站的构建成本要便宜得多。仅仅下载并运行别人创建的模型(仅推理)让本地环境构建的必要性显得薄弱。

3. 引入Spark与FP16的世界

投入约4000美元引入Spark机器后,我的AI研究环境完全改变。首要改变的是对待模型的态度。

Safetensors与全精度

我不再寻找GGUF,现在直接下载基于 FP16(半精度) 的 .safetensors 原始模型。

速度与质量:无量化损失的原始模型推理质量明显不同。而且得益于高性能GPU,推理速度也十分流畅。

- 实际速度差异显著。

- RTX 2060环境: Mistral 7B GGUF Q4_K_M → 约 10–20 tokens/s

- Spark环境 (GPT-OSS-20B FP16): 约 80–90 tokens/s

- Spark环境 (GPT-OSS-120B FP16): 约 40–50 tokens/s

在同等价位的笔记本和PC中无法达到的速度,使用FP16模型而无量化损失的推理性能使本地AI研究范式完全改变。

灵活的量化:如果需要,我可以亲自尝试FP8或FP4的量化。不是使用别人转换过的文件,而是根据我的研究目的进行直接控制。

4. 真实的价值:LoRA微调 (Fine-Tuning)

我认为引入Spark的核心原因在于进入了 训练(Training) 的领域。

在以前的规格下,甚至推理都很吃力,更别提微调了。但现在我可以亲自进行理论学习的 LoRA(低秩适应)。

-

实战经验:准备数据集,调整超参数,微调模型的过程提供了一种与简单推理不可比较的深度体验。

-

我自己的模型:不仅是通用模型,还可以创建特定领域或我自己的风格的模型,这正是本地环境的真正魅力。

可以进行从推理到学习的环境,这就是为何4000美元的花费丝毫不令人觉得可惜的原因。

5. GGUF的价值依然有效

当然,我的环境发生变化并不意味着否定GGUF的价值。

GGUF的本质并不在于‘绝对性能’,而在于 可及性。

它几乎是唯一一种无需高价GPU,仅通过CPU或低规格GPU就能运行大型语言模型的格式。但是,由于量化特性,精度损失和推理质量下降,以及在长上下文处理中的不稳定性是无法避免的。也就是说,GGUF既具有“任何人都能运行的模型”的优势,也同时具备“质量、速度、一致性的局限性”。

而且,GGUF在 AI民主化的方面 依旧是极好的格式。并不是所有用户都需要进行微调,也不一定具备高价设备。为轻用户在标准化环境中提供最佳推理性能的GGUF生态系统,未来随着个人PC性能的提升将会更为普及。我认为几年后,平板电脑和我们的手机上可能会运行gguf格式的模型。

结束语

如果说在RTX 2060上运行Q4_K_M模型的时代是“品尝”,那么与Spark一起的现在就是在“烹饪”。

本地AI的世界不仅仅是运行模型,而是在理解、修改和拥有模型的过程中寻找真正的乐趣。如果您对推理以外的模型结构理解和定制感到渴求,那么硬件投资将是解决这一渴望最可靠的钥匙。

![thumbnail of [Wan2.2 S2V 分析] 從 59 分鐘縮至 6 分鐘:尋找實務使用的速度與品質最佳平衡點](/media/whitedec/blog_img/3eb1e251c0d340af995052050c9fcdab.webp)

目前沒有評論。