RTX 4090 与 DGX Spark,究竟有什么不同 – 为考虑本地 AI 基础设施的企业提供比较分析

最近,如果您是一家正在考虑构建 AI 基础设施的企业或开发者,您一定会思考过这个问题。 “现在 RTX 4090 已经足够了,DGX Spark 真的有必要吗?”

这篇文章是对这个问题的谨慎探索。作为一名正在等待 DGX Spark 送货的用户,我结合了使用 RTX 4090 环境时感受到的局限性与期待来进行整理。

GPU 服务器 vs 高性能工作站 – 哪种基础设施更适合 AI 优化?

| 类别 | RTX 4090 工作站 | DGX Spark |

|---|---|---|

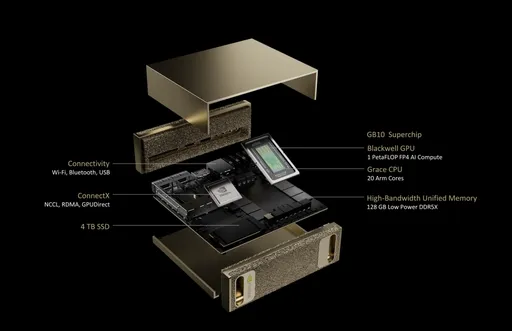

| GPU 架构 | Ada Lovelace | NVIDIA Blackwell |

| CPU | 外部 CPU 使用 | 20 核 Arm (10×Cortex-X925 + 10×Cortex-A725) |

| 内存 | 24GB GDDR6X | 128GB LPDDR5x (集成内存) |

| 内存带宽 | 1,008 GB/s | 273 GB/s |

| 存储设备 | 用户配置 SSD | 1TB 或 4TB NVMe M.2 (支持加密) |

| 网络 | 选项 | 10GbE + ConnectX-7 智能 NIC |

| 功耗 | 约 450W~600W | 170W |

| 系统尺寸 | ATX 或塔式 | 150 x 150 x 50.5 mm (1.2kg) |

| 操作系统 | Windows 或 Linux 用户安装 | NVIDIA DGX 基础操作系统 (基于 Ubuntu) |

▶ 核心区别: "是否为 AI 设计",这才是关键。

行业中的重要区别:本地 AI 基础设施优化

考虑采用 AI 基础设施的企业所关注的并不仅仅是计算速度。以下行业定制化的区别才是实际选择的标准:

- AI 数据安全和数据主权: 处理无法发送到云的数据是必需的

- 边缘 AI 部署: 制造/金融/医疗领域对私有 GPU 服务器需求激增

- AI 推理稳定性: 服务器级电力设计可实现 24/7 推理操作

- 集群整合: Grace CPU + Blackwell GPU 的架构可以实现单一机器的高密度运算

从这个角度来看,DGX Spark 不仅仅是一种 GPU 设备,而是私有 AI 基础设施解决方案。

总拥有成本 (TCO) 和投资效益 – 本地 AI 基础设施的 ROI 如何?

| 比较项 | RTX 4090 单一系统 | DGX Spark |

|---|---|---|

| 初始设备价格 | 约 $3,500 ~ $5,000 | $4,000 (依据 NVIDIA 官方发布) |

| 运营成本 | 考虑到电力和热量,自行管理 | 基于 ARM 的低功耗设计提高能源效率和降低维护成本 |

| 投资对象 | 个人或小型实验 | 企业级模型训练/推理平台 |

▶ 价格相似或 DGX Spark 更低,但考虑到运营效率和系统整合价值,从长远来看总拥有成本 (TCO) 更具竞争力。

个人开发者?初创公司?更适合谁?

- RTX 4090 更合适的情况:

- 模型规模较小,专注于个人学习和实验

- 混合使用云的开发者

-

对成本敏感的自由职业者/研究人员

-

DGX Spark 更适合的情况:

- 需要 LLM 企业内部部署/调优、保护数据主权的企业

- 希望提高相较于云的投资回报率的行业用户

- 希望自行运行 24 小时推理服务的团队

结论:现在是“待机中”,但选择标准是明确的

RTX 4090 现在也是非常出色的 GPU。 但我正在期待DGX Spark 带来的“AI 服务器的标准化”。

比单纯的更快速度更重要的是: - 应该基于什么系统来运作 AI - 如何安全、持续且成本效益高地构建 AI 基础设施

期待着将来能亲自分享使用体验,希望这比较能够成为明智选择的标准。

目前没有评论。