在本地环境中运行 LLM(大语言模型)的体验是因为硬件规格而显著不同。在过去几年中,我一直在中端规格的 PC 上运行 GGUF 模型,感受到限制,今天我想分享在引入高性能工作站 Spark (DGX Spark) 后,本地 AI 研究环境的变化经验。

1. GGUF 时代:妥协与效率的美学

在引入 Spark 之前,我的主设备是 i7 12700F CPU、32GB RAM,以及 RTX 2060 12GB。在这个规格下,运行大型语言模型的选择只有一个,GGUF(GPT 生成统一格式)。

量化(Quantization)的陷阱

当时选择模型的标准更多是基于“能否运行”而非性能。每当我在 Hugging Face 上搜索时,习惯性地搜索 GGUF 标签,并在其中寻找 Q4_K_M 格式。

- Q4_K_M: 将模型参数压缩为 4 位,以减少内存使用同时最小化性能损失的格式。

RTX 2060 的 12GB VRAM 只能勉强加载 7B 模型,或者通过系统 RAM 进行卸载(Offloading)以忍受速度缓慢。虽然满足于“能运行”的事实并感到有趣,但这显然是一个妥协的环境。

2. 单纯推理(Inference)的局限与怀疑

通过 GGUF 在本地运行 LLM 是令人兴奋的,但我很快遇到了根本性的问题。

“如果只是进行推理,真的需要本地环境吗?”

如果仅仅是为了问答和文本生成,世界上已经有如 Google Gemini 或 OpenAI GPT 等性能压倒性的存在。研究用 API 的费用可能远低于个人工作站的构建成本。仅仅下载并运行他人创建的模型(仅推理)减弱了构建本地环境的合理性。

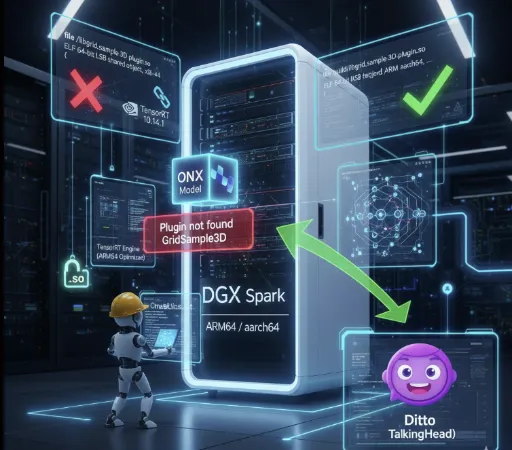

3. Spark 引入与 FP16 的世界

投资约 4000 美元引入 Spark 机器后,我的 AI 研究环境完全改变了。首先改变的就是对模型的态度。

Safetensors 与全精度

我不再寻找 GGUF。现在,我直接下载基于 FP16(半精度) 的 .safetensors 原始模型。

速度与质量: 无量化损失的原始模型的推理质量确实不同。而且,多亏了高性能 GPU,推理速度也非常流畅。

- 实际速度差异显著。

- RTX 2060 环境: Mistral 7B GGUF Q4_K_M → 约 10–20 tokens/s

- Spark 环境(GPT-OSS-20B FP16): 约 80–90 tokens/s

- Spark 环境(GPT-OSS-120B FP16): 约 40–50 tokens/s

同价位的笔记本·PC 无法达到这样的速度,使用无量化损失的 FP16 模型仍然能达到这个推理性能,这点彻底改变了本地 AI 研究的范式。

灵活的量化: 如果需要,我可以直接尝试 FP8 或 FP4 的量化。现在我可以根据自己的研究目标直接控制,而不再依赖某人转换好的文件。

4. 真正的价值:LoRA 微调(Fine-Tuning)

我认为引入 Spark 是“非常明智的决定”的核心原因就在于我进入了 训练(Training) 的领域。

以前的规格连推理都有些吃力,更不用说微调了。但现在我可以亲自进行以前只在理论上学习过的 LoRA(低秩适应)。

-

实战经验: 准备数据集、调整超参数并微调模型的过程提供了与单纯推理不可比拟的深入体验。

-

我自己的模型: 不再是通用模型,而是可以创建特定领域或符合我风格的模型,这正是本地环境的真正魅力。

一个不仅可以推理还可以进行训练的环境,这就是为什么4000美元的投入一点也不显得可惜。

5. GGUF 的价值仍然有效

当然,我的环境变了并不意味着否认 GGUF 的价值。

GGUF 的本质并不是“绝对性能”,而是 可接触性。

几乎是唯一能让没有高价 GPU 的 CPU 和低规格 GPU 运行大语言模型的格式。然而,由于量化特性,不可避免地会面临 精度损失和推理质量下降,以及 长文本处理时的不稳定性。也就是说,GGUF 既有“任何人都能运行的模型”这一优点,同时也具备“质量、速度与一致性的局限性”的双面性。

而且 GGUF 在 AI 民主化的方面 仍是一个出色的格式。并非所有用户都需要微调,也没有能力配备昂贵的设备。为轻量用户在标准化环境中提供最佳推理性能的 GGUF 生态系统,我相信将随着个人 PC 性能的提升而更加普及。几年后,或许我们在平板电脑或手机上也会看到 gguf 格式的模型在运行。

最后

如果说在 RTX 2060 时代运行 Q4_K_M 模型是一次“品尝”,那么与 Spark 共同的现在则是“烹饪”。

本地 AI 的世界不仅仅是运行模型,而是在理解、修改和使之成为我自己的过程中找寻真正的乐趣。如果你渴望超越简单推理,理解模型的结构并进行定制,那么硬件投资将成为缓解这种渴望的最可靠钥匙。

目前没有评论。