现在,人工智能不再是巨型云服务器的专属技术,而是在个人笔记本电脑或台式机上也能充分处理的技术。使这种变化成为可能的关键技术之一正是 llama.cpp 项目,而其核心便是 GGUF(GPT-Generated Unified Format) 格式。

本文将深入探讨 GGUF 的结构特性与设计哲学,以及为何这一格式已成为本地 LLM 生态系统的标准。

1. GGUF 是什么?

GGUF 是 GGML(Geroge Georgiev Machine Learning) 格式的下一代版本,由 llama.cpp 团队设计的 统一模型文件格式。

如果说原有的 GGML 只是简单地存储张量(Weights),那么 GGUF 则提供了一种全新Level的架构,旨在将模型“打包”成完整形态。

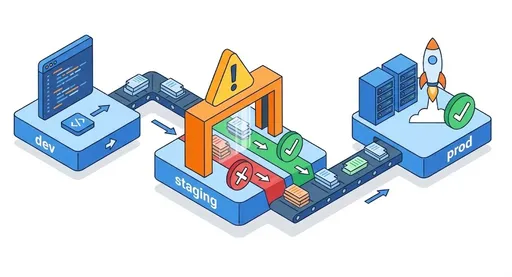

原有的 PyTorch .pth 或 Hugging Face .safetensors 文件只是简单地存储 模型权重。因此,在加载时需要单独提取分词器、配置文件和架构信息,并且必须使用 GPU 及复杂的 CUDA 环境配置。

相比之下,GGUF 将 权重 + 元数据 + 分词器 + 超参数 整合到一个二进制文件中。

换句话说,“移动模型”不再是包含代码或设置的复杂操作,而是 简单地复制一个文件。

这种设计背后的哲学是 ' 加载的完整性(Complete Loadability) '。也就是说,任何硬件上的相同 GGUF 文件都应按相同方式运行。

2. GGUF 的主要技术特性

GGUF 不仅仅是一种格式,更是为了高效本地推理而设立的一种 系统设计范式。

(1) 单一文件结构

GGUF 将所有数据整合到一个二进制文件中。这不仅提高了文件访问(IO)效率,也简化了模型的部署。

文件内部由头部(Header)、元数据(Key-Value Dictionary)、张量块(Tensor Blocks)构成。

得益于这种结构,即使添加新的字段,向下兼容性也能得到保持。例如,即便新增了“prompt_format”这样的元数据,旧加载器仍可无视,而最新加载器则会识别它。

(2) 内存映射(mmap)

GGUF 积极利用操作系统级的 内存映射(mmap) 功能。这是一种不将整个文件一次性加载到 RAM 中,而是仅即时加载所需块的方法。

换句话说,执行 10GB 模型时,实际加载到内存的量仅限于“当前计算中的张量”。因此,能够在低内存环境中运行大型模型。

(3) 硬件加速与卸载(Offloading)

GGUF 本质上是基于 CPU 运算设计的,但在存在 GPU 的情况下,可以将某些矩阵运算 卸载 到 GPU 上。

由于这种结构的灵活性,GGUF 支持 CPU Only → Hybrid → GPU Assisted 三个执行模式,并在各种平台上提供一致的性能档案。

3. 量化(Quantization)的深层理解

GGUF 格式最重要的创新不仅仅是“保存”模型,而是具备“重构(Quantize)”模型数值精度的能力。

量化是将原本以浮点数形式(例如 FP16、FP32)表示的权重压缩为更低位精度(例如 4bit、5bit 等)的过程。

因此,文件大小和内存使用量将急剧减少,但模型的语义性能大多保持不变。

(1) 量化标记(Qn_K_M、Q8_0等)的意义

GGUF 中使用的量化方式名称并非简单的缩写,而是反映了 内部算法结构的代码。

-

Q : 量化(量化方式)

-

数字(n) : 用于表达一个权重的比特数(例如 Q4 → 4位)

-

K : _K-Block Quantization_,表示将矩阵分为 K 单位块进行独立量化的结构。

例如,如果是Q4_K,那么权重张量会被划分为 K 大小的块,并为每个块分别计算 比例(scale) 和 零点(zero-point)。

这样可以反映局部特性,其精确度远高于简单的全局量化。 -

M : _混合精度_。

部分张量(特别是关键/值投影等重要部分)使用更高精度,其他则使用较低精度进行存储。

换句话说,这是一种根据 模型结构的重要性来差异化应用精度 的技术。 -

0 (Zero) : 表示“非 K”块结构。即非 K 块单位的简单全局比例量化,虽然结构最简单,但细微调整的难度较大。

(2) 各量化方式的原理与应用背景

| 量化类型 | 技术描述 | 内部机制 | 推荐使用环境 |

|---|---|---|---|

| Q2_K | 2位量化。理论上可以压缩 16 倍 | 每个块基于比例恢复 4 个值(2 位 × 16) | 极度受限的内存(树莓派、边缘设备) |

| Q3_K_M | 3位量化 + 混合精度 | 使用 3 位表示,但在重要张量中使用 4 位以上 | 低配置笔记本、嵌入式环境 |

| Q4_K_M | 4位量化的实质标准 | 平衡的块比例缩放,K 单位分组量化 | 普通用户(MacBook、游戏 PC) |

| Q5_K_M | 5位量化,尽量减少微小损失 | 提供更精细的比例区间 | 内存余裕环境 |

| Q6_K | 几乎无损的高精度量化 | 基于每块的最小/最大值进行缩放 | 高质量推理用 |

| Q8_0 | 8位,简单量化无块 | 原始性能最接近 | 高性能工作站及 GPU |

> 通常 Q4_K_M 被认为是 容量与质量效率最高的点。原因在于,K 块结构提供的局部精度与 4 位压缩之间的平衡与当前大部分 CPU/GPU 运算单元(AVX、Metal、CUDA)十分契合。 |

4. GGUF 的设计优势

-

平台独立性:在 CPU、GPU、Apple Silicon 等不同硬件上,均可使用相同二进制文件进行推理。

-

加载效率:基于 mmap 的流式加载使得几个 GB 大小的模型也能够立即启动。

-

完全可重现性(Reproducibility):文件内部包含了分词器和参数,任何 GGUF 文件都能在任何时候输出相同结果。

-

生态系统扩展性:围绕

llama.cpp,Ollama、LM Studio、LocalAI、llamacpp-python等多种工具均已被标准化采用。

5. 限制和现实考虑

-

不适合用于训练。

GGUF 是“推理优化格式”,未保持用于反向传播(Gradient Backpropagation)的数据精度。

因此,要进行像微调或 LoRA 这样的再训练,则需要再次转换为 FP16 格式。 -

与 GPU 专用格式相比速度受到限制

EXL2、AWQ、GPTQ 等 GPU 专用格式直接利用 GPU 矩阵运算,因此生成令牌的速度较快。

然而,它们大多依赖于 CUDA 环境,对 CPU/Metal 等通用平台的支持有限。

GGUF 的哲学设计优先考虑 通用性与可达性 而非速度。

6. 结论:GGUF 是“个人 AI 的标准格式”

GGUF 的出现,使得大型语言模型不再是研究所的专有东西。

通过实现推理效率、文件单一性和硬件独立性的三大支柱,GGUF 实际上已成为 本地 LLM 的事实标准。

如果你想在 MacBook 或普通 PC 上运行 Llama 3、Mistral、Phi-3 等最新模型——

唯一的起点就是 下载 GGUF 格式模型。

目前没有评论。