Als je deze post hebt gevonden, ben je waarschijnlijk van plan om te beginnen met het ontwikkelen van deep learning met behulp van GPU's. Dit artikel is een praktische gids die het proces van het voorbereiden van CUDA-gebaseerde GPU-berekeningen in een Ubuntu-omgeving samenvat.

In het bijzonder is de inhoud zo samengesteld dat beginners "Is CUDA correct geïnstalleerd op mijn pc?" willen controleren, deze gemakkelijk kunnen volgen.

Voor degenen die nieuwsgierig zijn naar wat CUDA is, wordt aangeraden om eerst de vorige post Wat is CUDA? De start van GPU en parallel computing te bekijken.

1. Waarom moet ik een GPU-omgeving instellen?

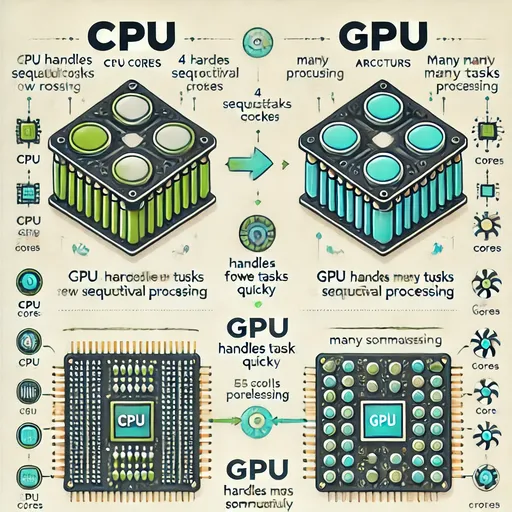

Het trainen van AI-modellen vereist een grote hoeveelheid matrixberekeningen.

Dergelijke berekeningen worden veel sneller uitgevoerd op een GPU die gespecialiseerd is in parallelle berekeningen dan op een CPU.

Echter, alleen een GPU hebben is niet genoeg.

Een driver die het besturingssysteem vertelt dat er een GPU is,

en de cuDNN, een bibliotheek die geoptimaliseerd is voor deep learning,

al deze drie moeten juist goed geïnstalleerd zijn om de GPU te kunnen gebruiken.

2. Controleer de status van je GPU - Hebben we een driver en CUDA?

nvidia-smi

Dit is een tool die de huidige status van de GPU toont.

Als hier CUDA Version staat en de GPU-naam correct weergegeven wordt,

betekent dit dat de GPU correct wordt herkend en de driver geïnstalleerd is.

3. CUDA-ontwikkeltools - Waarom is nvcc nodig?

nvcc is een tool voor het compileren van CUDA-code (.cu).

In analogie, is het een compiler die je nodig hebt om CUDA “echt te gebruiken”.

sudo apt update

sudo apt install nvidia-cuda-toolkit

nvcc --version

4. cuDNN - Het geheime wapen voor snelle deep learning-berekeningen op de GPU

cuDNN is een door NVIDIA ontwikkelde bibliotheek voor hoge snelheid wiskundige bewerkingen speciaal voor deep learning.

Het wordt gebruikt in deep learning frameworks (zoals PyTorch, TensorFlow, etc.) voor:

- Convolutie

- Pooling

- RNN

- LSTM

- BatchNorm

- Activatie, waardoor je deze berekeningen snel en efficiënt op de GPU kunt uitvoeren.

Als je van plan bent om deep learning frameworks zoals PyTorch of TensorFlow te gebruiken, is dit een essentiële bibliotheek.

Je moet de cuDNN-pakket installeren die overeenkomt met de versie van CUDA om ervoor te zorgen dat de frameworks de GPU efficiënt kunnen gebruiken.

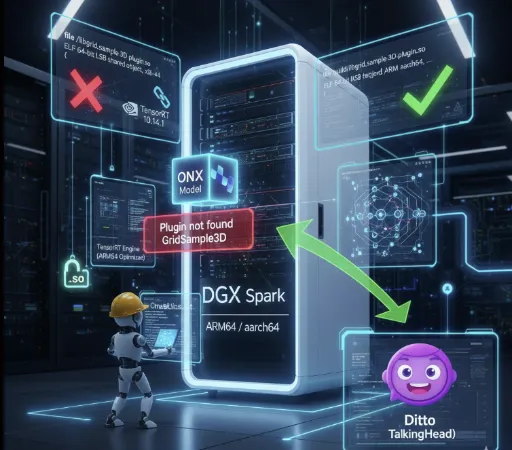

De downloadlocatie van het cuDNN-pakket varieert afhankelijk van het besturingssysteem en de CPU-architectuur, dus zorg ervoor dat je naar de officiële NVIDIA cuDNN-downloadpagina gaat om de juiste bibliotheek te downloaden en te installeren.

Wanneer je cuDNN downloadt via de bovenstaande link, zorg er dan voor dat je eerder de CUDA-versie die je in nvidia-smi hebt gecontroleerd bekijkt en de juiste cuDNN installeert.

5. Testen - Laten we controleren of de GPU werkt in Python

Als je alles hebt geïnstalleerd, laten we dan controleren of het goed werkt.

import torch

print(torch.cuda.is_available()) # True

print(torch.cuda.get_device_name(0)) # NVIDIA GeForce RTX XXXX

6. Samenvatting

| Component | Jouw actie | Waarom je dit hebt gedaan |

|---|---|---|

| NVIDIA driver | Controleer de installatie (nvidia-smi) |

De GPU in het systeem herkennen |

| CUDA Toolkit | nvcc installeren |

Compiler voor de uitvoering van CUDA-code |

| cuDNN | cudnn-cuda-12 installeren |

Bibliotheek voor optimalisatie van deep learning-berekeningen |

| PyTorch testen | Controleer de GPU-integratie | Verifiëren of berekeningen daadwerkelijk kunnen worden uitgevoerd |

7. Jesse's afsluiting

Nu is je systeem klaar voor GPU-berekeningen.

Met deze omgeving kun je snel verschillende modellen zoals Whisper, LLaMA, ChatGPT trainen of uitvoeren op de GPU.

There are no comments.