De esthetiek van logtailing: de wereld van bots die over je server glijden

Een scherm vol zwarte terminal, overheen stroomt wit tekst. Een moment dat elke systeembeheerder of backend‑ontwikkelaar kent: je typt tail -f access.log en kijkt stilletjes naar de log.

Het zien van een log die continu groeit geeft een vreemde rust. Een soort "digitale meditatie"? Toch groeit er nieuwsgierigheid: "Wie klopt er nu aan de deur van mijn server?"

Bij een nauwkeurige blik zie je dat de meeste bezoekers geen echte gebruikers zijn, maar talloze bots die door het internet zwerven. In dit artikel duiken we in de verschillende crawler‑bots die je tegenkomt tijdens logtailing, hun identiteit en kenmerken.

Bots: ongevraagde gasten of welkom geachte bezoekers?

Web‑crawlers of spiders bezoeken websites met geautomatiseerde scripts om informatie te verzamelen.

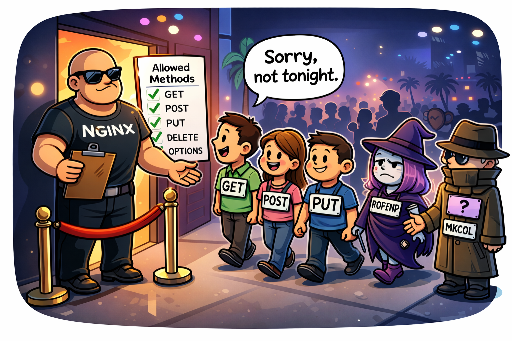

1. Beleefde bots (Polite Bots)

Deze bots geven duidelijk hun User‑Agent aan, volgen de robots.txt‑regels en bezoeken de server op een redelijke frequentie, waardoor ze geen overbelasting veroorzaken. Ze zijn dankbare gasten die ons helpen met zoekmachine‑indexering en meer.

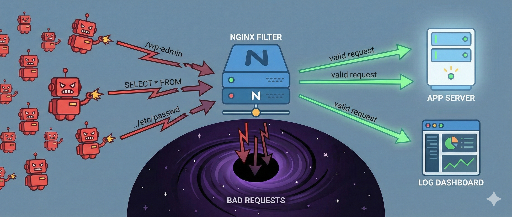

2. Onbeleefde bots (Bad Bots)

Ze verbergen hun identiteit door de User‑Agent te spooien of laten zich niet zien. Ze negeren robots.txt en versturen verzoeken in een DDoS‑achtige snelheid, waardoor serverbronnen uitgeput raken. Deze bots staan bovenaan de lijst van firewall‑blokkades.

De belangrijkste bots volledig onder de loep

Hier volgt een overzicht van de meest voorkomende bots die je tijdens logtailing tegenkomt. Op basis van de User‑Agent‑string kun je hun identiteit en doel bepalen.

| Botnaam (User‑Agent) | Eigenaar | Doel en kenmerken | IP‑bereik (referentie) |

|---|---|---|---|

| Googlebot | De hoofd‑crawler voor Google‑indexering. De meest gewaardeerde gast. | 66.249.x.x etc. (DNS‑lookup nodig) |

|

| Mediapartners‑Google | Bot voor AdSense‑contextanalyse. Analyseert pagina‑inhoud voor advertentiedistributie. | 66.249.x.x |

|

| Google‑InspectionTool | URL‑inspectietool van Search Console. Treedt op bij handmatige index‑aanvragen. | 66.249.x.x |

|

| Bingbot | Microsoft | Crawler van Bing. De tweede belangrijkste zoekmachine. | 157.55.x.x, 40.77.x.x |

| Yeti | Naver | Crawler van Naver. Essentieel voor Koreaanse sites. | 210.117.x.x, 114.111.x.x |

| DuckDuckBot | DuckDuckGo | Privacy‑bewuste crawler van DuckDuckGo. | 20.191.x.x (Azure‑bereik) |

| YandexBot | Yandex | Grootste Russische zoekmachine. Verbruikt middelen als er geen Russisch verkeer is. | 5.255.x.x, 77.88.x.x |

| Baiduspider | Baidu | Grootste Chinese zoekmachine. Zeer agressieve crawling; kan worden geblokkeerd als je geen Chinese services hebt. | 116.179.x.x, 220.181.x.x |

| GPTBot | OpenAI | Bot die data verzamelt voor AI‑training (ChatGPT, etc.). | 20.15.x.x (Azure‑bereik) |

| ChatGPT‑User | OpenAI | Verkeer van ChatGPT‑gebruikers die via de browse‑functie links raadplegen. | - |

| Bytespider | ByteDance | Bot van TikTok‑moederbedrijf. Recentelijk zeer agressief in data‑verzameling. | 47.128.x.x etc. |

| PetalBot | Huawei | Bot van Huawei’s Petal Search. Mobiel‑gericht en frequent. | 114.119.x.x |

| AhrefsBot | Ahrefs | SEO‑analyse‑tool. Kan aanzienlijke serverbelasting veroorzaken. | 54.36.x.x etc. |

| SemrushBot | Semrush | SEO‑marketing‑tool, vergelijkbaar met Ahrefs. | 46.229.x.x |

| DotBot | Moz | SEO‑analyse‑tool van Moz. | 216.244.x.x |

| Amazonbot | Amazon | Crawler voor Alexa en Amazon‑diensten. | 52.95.x.x etc. (AWS‑bereik) |

| FreshRSS / Reeder | Open Source | RSS‑lezer van individuele gebruikers. Niet echt een bot, maar een verzoek om abonnementen te vernieuwen. | Gebruikers‑IP |

| python‑requests / curl | - | Scripting‑tools. Worden soms gebruikt voor testen, maar kunnen ook kwaadaardige bots zijn. | - |

| peer39_crawler | Peer39 | Advertentie‑context‑analyse‑tool. | - |

Mijn eigen bot‑rangschikking

Op basis van mijn log‑observaties heb ik een subjectieve rangschikking van bots gemaakt. Deze kan veranderen afhankelijk van je filosofie en traffic‑doelen.

🏆 Groep 1: VIP‑gasten (Welkom!)

"Ze brengen verkeer, ze zijn de reden dat mijn server bestaat. Ze zijn de meest waardevolle gasten."

- Leden:

Googlebot,Bingbot,Yeti,DuckDuckBot,Mediapartners‑Google,YandexBot,FreshRSS,Reeder - Reden:

- Zoekmachines (

Googlebot,Yeti,Bingbot): Zonder hen is je webservice een onbewoond eiland. - YandexBot: Belangrijk voor Russisch‑ en Oost‑Europese traffic. Ze zijn over het algemeen beleefd.

- RSS‑abonnees (

FreshRSS,Reeder): Niet zoekmachine‑traffic, maar echte fans die je content opvragen.

😐 Groep 2: Gewone burgers (Ga door, het is niet slecht)

"Directe voordelen zijn niet meteen zichtbaar, maar ze hebben potentieel of zijn onschadelijk."

- Leden:

Baiduspider,ChatGPT‑User,Google‑InspectionTool,Amazonbot - Reden:

- Baiduspider: Grote Chinese markt; het is niet verkeerd om ze toe te staan.

- Overige: Ze veroorzaken geen schade en geven aan dat iemand je content gebruikt.

😤 Groep 3: Ongevraagde gasten (Kom niet, alsjeblieft…)

"Ze hebben een mooie User‑Agent, maar ze zijn onbeleefd, verbruiken middelen en helpen me niet."

- Leden:

Bytespider,PetalBot,AhrefsBot,SemrushBot,DotBot,python‑requests,curl - Reden:

- Agressieve verzamelaars (

Bytespider,PetalBot): Ze lijken op DDoS‑aanvallen. - SEO‑tools (

Ahrefs,Semrush): Ze gebruiken je data voor hun eigen diensten zonder verkeer terug te sturen. - Onbekende scripts (

python‑requests,curl): Vaak ongeautoriseerd scrapen of kwetsbaarheids‑scans.

Afsluiting

Logtailing is meer dan eenvoudige monitoring; het is een venster op hoe je server interacteert met het wereldwijde netwerk.

Hoewel bots zoals Bytespider agressief kunnen zijn, vind ik het een minimale beleefdheid dat ze hun naam (UA) eerlijk vermelden. Ik laat ze binnen, maar vraag ze om gematigd te blijven.

Ik blijf stilletjes naar de stroom loggen kijken en denk na:

"Ja, als ze hun naam laten zien, laat ik ze binnen. Maar laat ze wel even rustig gaan!"

There are no comments.