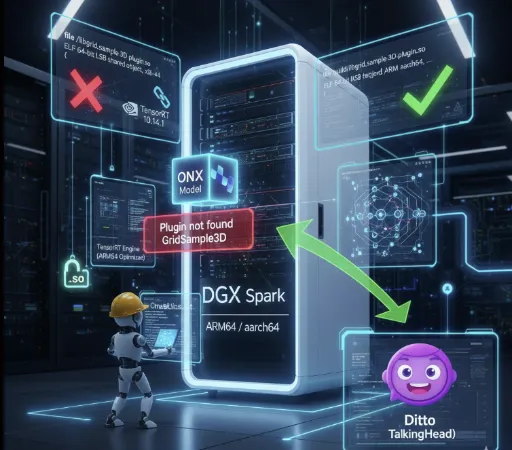

De ervaring om een LLM (Large Language Model) in een lokale omgeving te draaien, varieert sterk afhankelijk van de hardware-specificaties. In de afgelopen jaren heb ik de beperkingen ervaren van het draaien van GGUF-modellen op een PC met gemiddelde specificaties, en ik wil mijn ervaringen delen over de veranderingen in de lokale AI-onderzoeksomgeving na de introductie van de krachtige werkstation Spark (DGX Spark).

1. Het GGUF Tijdperk: De Esthetiek van Compromis en Efficiëntie

Voor de introductie van Spark was mijn belangrijkste apparatuur een i7 12700F CPU, 32GB RAM, en een RTX 2060 12GB. In deze specificaties was de enige keuze om grote taalmodellen te draaien, GGUF (GPT-Generated Unified Format).

De Moeras van Kwantisatie (Quantization)

De criteria voor het kiezen van een model waren op dat moment minder gericht op prestaties, maar meer op 'de mogelijkheid om deze te draaien'. Bij het doorbladeren van Hugging Face, zocht ik habitueel naar de GGUF tag en zocht ik wanhopig naar het Q4_K_M formaat.

- Q4_K_M: Een formaat dat de parameters van het model comprimeert naar 4-bits om het geheugengebruik te verminderen, terwijl de prestatieverlies tot een minimum wordt beperkt.

De 12GB VRAM van de RTX 2060 kon net een 7B-model draaien, of de systeem-RAM moest worden gebruikt voor offloading, wat resulteerde in een langzaam tempo. Hoewel ik genoot van de voldoening dat het 'werkte', waren er duidelijke compromissen in de omgeving.

2. De Beperkingen van Eenvoudige Inferentie en Cynisme

Het draaien van een LLM lokaal via GGUF was interessant, maar vroeg al snel om fundamentele vragen.

"Als het alleen gaat om inferentie, is een on-premise omgeving dan echt nodig?"

Als het doel simpelweg is om vragen te beantwoorden en tekst te genereren, zijn er al krachtige opties zoals Google Gemini of OpenAI GPT. De kosten van een onderzoeks-API kunnen veel lager zijn dan de kosten voor het opzetten van een persoonlijke werkstation. Het feit dat je een model alleen maar hoeft te downloaden en uit te voeren zonder zelf te leren of aanpassingen te doen (Inference Only), maakt de noodzaak voor het opzetten van een lokale omgeving twijfelachtig.

3. De Introductie van Spark en de Wereld van FP16

Nadat ik ongeveer 4.000 dollar had geïnvesteerd in een Spark-machine, veranderde mijn AI-onderzoeksomgeving volledig. Het eerste dat veranderde, was mijn houding ten opzichte van modellen.

Safetensors en Full Precision

Ik zoek niet langer naar GGUF. Nu download ik simpelweg het FP16 (Half Precision) gebaseerde .safetensors origineel model.

Snelheid en Kwaliteit: De inferentiekwaliteit van het originele model zonder kwantisatieverlies is zeker anders. Bovendien is de inferentiesnelheid aangenaam dankzij de krachtige GPU.

- Het werkelijke snelheidsverschil is opmerkelijk.

- RTX 2060 omgeving: Mistral 7B GGUF Q4_K_M → circa 10–20 tokens/s

- Spark omgeving (GPT-OSS-20B FP16): circa 80–90 tokens/s

- Spark omgeving (GPT-OSS-120B FP16): circa 40–50 tokens/s

Een snelheid die ondenkbaar is op een laptop/PC in dezelfde prijsklasse, en zelfs met het FP16-model kan ik deze inferentieprestaties bereiken zonder kwantisatieverlies, wat het lokale AI-onderzoek paradigma volledig heeft veranderd.

Flexibele Kwantisatie: Indien nodig kan ik zelf experimenteren met kwantisatie naar FP8 of FP4. Ik ben niet langer afhankelijk van iemand die een bestand heeft geconverteerd; ik heb de mogelijkheid om het direct aan te passen aan mijn onderzoeksdoelen.

4. De Ware Waarde: LoRA Fijn-tuning (Fine-Tuning)

De reden waarom ik denk dat de introductie van Spark een "uitstekende beslissing" was, is omdat ik nu het domein van Training ben binnengestapt.

Met de eerdere specificaties was zelfs inferentie een uitdaging, laat staan fijn-tuning. Maar nu kan ik zelf de LoRA (Low-Rank Adaptation) uitvoeren, waar ik vroeger slechts theorieën over had bestudeerd.

-

Praktische Ervaring: Het voorbereiden van datasets, het afstemmen van hyperparameters en het fijn afstemmen van modellen biedt een ervaring van een andere diepte vergeleken met eenvoudige inferentie.

-

Mijn Eigen Model: Het feit dat ik een model kan creëren dat niet algemeen is, maar specifiek is voor bepaalde domeinen of mijn eigen schrijfstijl, is de ware aantrekkingskracht van een on-premise omgeving.

Een omgeving die verder gaat dan alleen inferentie en ook training mogelijk maakt, is de reden waarom ik de investering van 4.000 dollar niet betreur.

5. De Waarde van GGUF blijft Relevant

Natuurlijk, het feit dat mijn omgeving is veranderd betekent niet dat ik de waarde van GGUF ontken.

De essentie van GGUF ligt niet in 'absolute prestaties', maar in toegankelijkheid.

Het is bijna het enige formaat waarmee grote taalmodellen kunnen worden gedraaid met alleen een CPU of low-end GPU, zonder dure GPU's. Echter, als gevolg van kwantisatie is het onvermijdelijk dat er nauwkeurigheidsverlies en afname van inferentiekwaliteit, evenals onstabiliteit bij het verwerken van lange contexten is. Dit betekent dat GGUF het voordeel heeft van "iedereen kan een model draaien", maar ook de tweesnijdende zwaard van "beperkingen in kwaliteit, snelheid en consistentie".

Bovendien blijft GGUF een geweldig formaat in termen van AI-democratisering. Niet alle gebruikers hebben fijn-tuning nodig, en niet iedereen kan dure apparatuur aanschaffen. De GGUF-ecosystemen bieden standaard optimale inferentiekwaliteit in een omgeving voor casual gebruikers, en ik ben ervan overtuigd dat het in de toekomst nog populairder zal worden, samen met de vooruitgang in persoonlijke PC-prestaties. Over een paar jaar kan het zijn dat modellen in gguf-formaat op tablet-pc's of onze smartphones draaien.

Conclusie

Als de tijd dat ik Q4_K_M-modellen op een RTX 2060 draaide een 'proeverij' was, voelt het werken met Spark nu als 'koken'.

De wereld van lokale AI biedt niet alleen de mogelijkheid om modellen te draaien, maar ook echte vreugde te vinden in het begrijpen, aanpassen en persoonlijk maken van die modellen. Als je hunkert naar een structureel begrip van modellen en aanpassingen voorbij eenvoudige inferentie, zal een investering in hardware de meest zekere sleutel zijn om die hunkering te vervullen.

There are no comments.