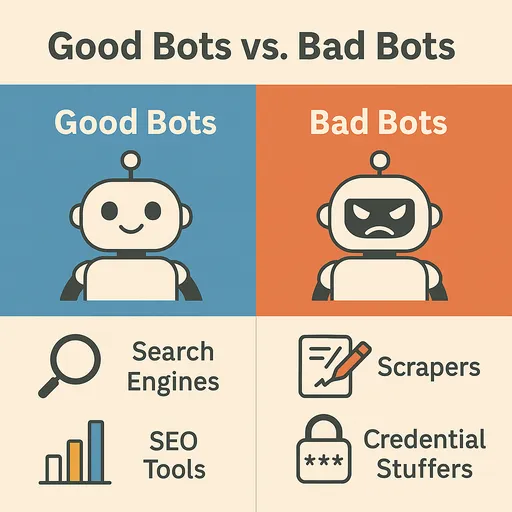

인터넷은 끊임없이 변화하고 확장하는 거대한 정보의 바다입니다. 이 방대한 데이터를 탐색하고 수집하는 데 필수적인 역할을 하는 것이 바로 웹 크롤러(Web Crawler), 흔히 봇(Bot)이라고 불리는 자동화된 프로그램들입니다. 웹을 돌아다니며 정보를 색인화하고, 데이터를 수집하며, 다양한 서비스를 제공하는 이 봇들은 웹 생태계의 중요한 구성원이죠. 하지만 모든 봇이 웹에 이로운 것만은 아닙니다. 때로는 웹사이트에 피해를 주거나 악용될 수 있는 유해한 봇들도 존재합니다.

이번 글에서는 웹에서 자주 마주치는 유명한 봇들의 종류와 특징을 살펴보고, 유익한 봇과 유해한 봇을 구별하는 방법, 그리고 유해한 봇으로부터 웹사이트를 보호하는 데 특화된 효과적인 방법에 대해 알아보겠습니다.

웹에서 자주 보이는 유명한 봇들 (유익한 봇)

대부분의 웹 트래픽은 사람이 아닌 봇에 의해 발생합니다. 그중에서도 가장 중요하고 유익한 봇들은 다음과 같습니다.

1. 검색 엔진 봇 (Search Engine Bots)

가장 흔하고 중요한 봇들입니다. 웹페이지를 탐색하여 콘텐츠를 수집하고, 검색 엔진 색인에 추가하여 사용자들이 정보를 찾을 수 있도록 돕습니다.

-

Googlebot (Google): 구글의 대표적인 웹 크롤러입니다. 웹의 거의 모든 페이지를 탐색하여 검색 결과를 업데이트하고, 구글 서비스(지도, 뉴스 등)에 데이터를 제공합니다.

User-Agent에Googlebot또는Mediapartners-Google등으로 표시됩니다. -

Bingbot (Microsoft Bing): 마이크로소프트의 Bing 검색 엔진 크롤러입니다.

User-Agent에Bingbot으로 표시됩니다. -

Baidu Spider (Baidu): 중국의 주요 검색 엔진인 Baidu의 크롤러입니다. 중국 시장을 겨냥한다면 Baidu Spider의 방문도 중요합니다.

User-Agent에Baiduspider로 표시됩니다. -

Yandex Bot (Yandex): 러시아의 주요 검색 엔진인 Yandex의 크롤러입니다.

User-Agent에YandexBot으로 표시됩니다. -

Yeti (Naver): 대한민국의 네이버의 대표적인 검색 엔진 크롤러입니다. 한국 시장에 특화된 검색 결과를 수집하며,

User-Agent에Yeti로 표시됩니다.

2. 소셜 미디어 봇 (Social Media Bots)

소셜 미디어에서 링크를 공유할 때, 해당 링크의 미리보기(제목, 설명, 이미지)를 생성하는 데 사용됩니다.

-

Facebook External Hit (Facebook): 페이스북에서 링크를 공유할 때 페이지 정보를 가져옵니다.

User-Agent에facebookexternalhit으로 표시됩니다. -

Twitterbot (Twitter/X): 트위터(X)에서 링크 미리보기를 생성합니다.

User-Agent에Twitterbot으로 표시됩니다. -

Slackbot (Slack): 슬랙에서 링크를 공유할 때 미리보기를 생성합니다.

User-Agent에Slackbot으로 표시됩니다.

3. 모니터링/분석 봇 (Monitoring/Analytics Bots)

웹사이트의 상태, 성능, 보안 취약점 등을 모니터링하거나 트래픽 분석을 위해 사용됩니다.

-

UptimeRobot, Pingdom: 웹사이트의 가동 시간을 모니터링하여 다운되었을 때 알림을 보냅니다.

-

Site Crawlers (Screaming Frog, Ahrefsbot, SemrushBot 등): SEO 도구들이 웹사이트를 분석하여 SEO 개선점을 찾거나 경쟁사 분석 데이터를 수집합니다.

User-Agent에 해당 도구 이름이 포함됩니다. -

Ahrefsbot (Ahrefs): Ahrefs는 위에서 설명한 강력한 SEO 분석 크롤러 중 하나로, Ahrefsbot은 웹에서 가장 활발하게 활동하는 상업용 크롤러입니다. 웹사이트의 백링크, 키워드 순위, 유기적 트래픽 등 방대한 SEO 데이터를 수집하여 Ahrefs 서비스 사용자에게 제공합니다. 특히 백링크 데이터베이스 구축을 위해 인터넷을 매우 광범위하게 크롤링하며, 이 때문에 웹 서버 로그에서

Googlebot다음으로 자주 눈에 띄는 봇 중 하나입니다.User-Agent에AhrefsBot으로 표시됩니다.

유해한 봇과 유익한 봇 구별하기

봇 트래픽이 웹사이트에 미치는 영향은 봇의 목적과 행동 방식에 따라 크게 달라집니다. 유해한 봇은 웹사이트 리소스를 고갈시키거나, 데이터를 훔치거나, 보안 취약점을 악용할 수 있습니다.

유익한 봇의 특징

-

robots.txt준수: 대부분의 유익한 봇은 웹사이트의robots.txt파일을 존중하고, 여기에 명시된 규칙(크롤링 허용/불허 영역, 크롤링 속도 등)을 따릅니다. -

정상적인 요청 패턴: 요청 간에 적절한 지연 시간을 두어 서버에 과부하를 주지 않습니다.

-

정식

User-Agent: 명확하고 알려진User-Agent문자열을 사용하며, 종종 봇의 소유자 정보(예:Googlebot/2.1 (+http://www.google.com/bot.html))를 포함합니다. -

정품 IP 주소: 해당 봇 소유자의 실제 IP 주소 범위에서 요청을 보냅니다. (예: Googlebot은 구글 소유의 IP 대역을 사용)

유해한 봇의 특징

-

robots.txt무시:robots.txt파일을 무시하고 접근이 허용되지 않은 영역에 무단으로 접근하려고 시도합니다. -

비정상적인 요청 패턴: 특정 페이지에 대한 짧은 시간 내의 반복적인 요청(DDoS 공격 시도), 비정상적으로 빠른 크롤링 속도 등으로 서버에 과부하를 줍니다.

-

위조된

User-Agent: 유익한 봇(예: Googlebot)의User-Agent를 위조하여 숨거나, 무작위로 생성된User-Agent를 사용합니다. -

알 수 없는 IP 주소: 프록시 서버나 VPN, 좀비 PC 등을 이용하여 IP 주소를 숨기거나 자주 변경합니다.

-

악의적인 활동:

-

콘텐츠 스크래핑(Content Scraping): 웹사이트의 콘텐츠를 무단으로 복사하여 다른 웹사이트에 게시하거나 재판매합니다.

-

재고 스나이핑(Inventory Sniping): 전자상거래 사이트에서 상품 재고를 빠르게 파악하여 사재기 등에 악용합니다.

-

자격 증명 스터핑(Credential Stuffing): 훔친 사용자 계정 정보를 다른 웹사이트에 대입하여 로그인 시도합니다.

-

스팸 등록: 게시판이나 댓글 섹션에 스팸 콘텐츠를 자동으로 등록합니다.

-

DDoS 공격: 대량의 트래픽을 발생시켜 웹사이트를 마비시킵니다.

-

취약점 스캐닝: 웹사이트의 알려진 보안 취약점을 자동으로 스캔하여 공격 포인트를 찾습니다.

-

유해한 봇만을 효과적으로 차단하는 법

악의적인 봇들은 robots.txt와 같은 규칙을 무시하고, 실제 사용자를 가장하며 웹사이트에 침입하려 합니다. 따라서 이들을 차단하기 위해서는 그들의 비정상적인 행동 패턴을 감지하고, 해당 요청만을 선별적으로 차단하는 고급 전략이 필요합니다.

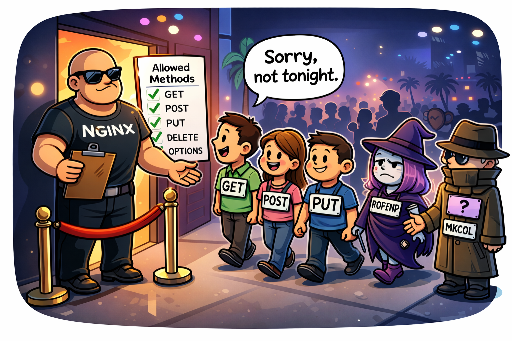

1. IP 주소 및 User-Agent 기반 차단 (제한적 초기 방어선)

악성 트래픽이 특정 IP 주소나 IP 대역에서 지속적으로 발생하거나, 명백히 유해한 User-Agent 문자열을 사용하는 경우에 일시적으로 효과를 볼 수 있습니다.

-

웹 서버 설정 (Apache, Nginx):

- 특정 IP 주소 차단:

# Nginx 예시

deny 192.168.1.100;

deny 10.0.0.0/8;

- **악성 `User-Agent` 차단:**

# Apache .htaccess 예시

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} "BadBotString|AnotherBadBot" [NC]

RewriteRule .* - [F,L] # 403 Forbidden 반환

한계점: IP 주소는 유동적이거나 프록시, VPN, Tor 네트워크를 통해 쉽게 우회될 수 있습니다. 악성 봇들은 IP를 거의 무한히 바꿔가며 공격을 시도할 수 있기에, IP 기반 차단은 관리 부담만 가중시키고 장기적인 해결책이 되기 어렵습니다. User-Agent 또한 손쉽게 위조될 수 있어, 이 방법만으로는 정교한 악성 봇을 막기 어렵습니다.

2. 요청 속도 제한 (Rate Limiting)

특정 IP 주소, User-Agent, 또는 특정 URL에 대한 요청 수가 짧은 시간 내에 비정상적으로 급증할 때 해당 요청을 제한하거나 차단합니다. 이는 DDoS 공격이나 과도한 스크래핑 시도를 막는 데 효과적입니다.

- 웹 서버 설정 (Nginx 예시):

# Nginx http 블록 내

limit_req_zone $binary_remote_addr zone=mylimit:10m rate=5r/s;

# server 또는 location 블록 내

location / {

limit_req zone=mylimit burst=10 nodelay; # 초당 5개 요청 허용, 버스트 10개까지

# ...

}

난이도 및 위험: 요청 속도 제한은 매우 유용하지만, 적절한 임계값 설정이 매우 까다롭습니다. 너무 엄격하게 설정하면 정상적인 사용자나 유익한 검색 엔진 봇의 트래픽까지 제한하여 서비스 접근성을 떨어뜨릴 수 있습니다. 반대로 너무 느슨하게 설정하면 악성 봇의 목적을 달성하게 만들 수 있습니다. 서비스의 특성과 일반적인 트래픽 패턴에 대한 깊은 이해를 바탕으로 지속적인 모니터링과 튜닝이 요구되는 부분입니다.

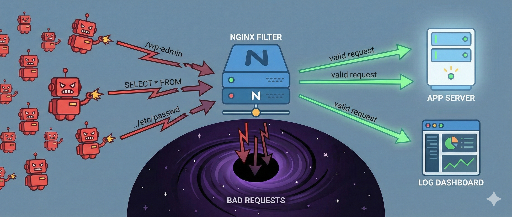

3. 행위 기반 감지 및 맞춤형 방어 시스템 구축 (가장 효과적인 전략)

가장 정교하고 효과적인 방법입니다. 악의적인 봇은 IP나 User-Agent를 위장할 수 있지만, 웹사이트 내에서의 그들의 행동 패턴은 특이하게 나타나기 마련입니다. 이러한 비정상적인 행위를 분석하여 악의적인 봇을 식별하고, 해당 패턴에 대한 방어 시스템을 구축하는 것이 핵심입니다.

-

트래픽 모니터링 및 로그 분석의 중요성:

웹 서버 로그(Access Log)는 봇의 행동을 파악할 수 있는 가장 중요한 데이터 소스입니다. 로그를 주기적으로(매일 1회 이상) 검토하고 분석하는 습관을 들이는 것이 필수적입니다. 로그 분석을 통해 다음과 같은 악성 봇의 비정상적인 행동들을 발견할 수 있습니다.

-

비정상적인 탐색 경로: 사람이 일반적으로 이동하지 않는 페이지 순서, 비정상적으로 빠른 페이지 이동, 특정 페이지에 대한 반복적인 접근.

-

반복적인 특정 작업 시도: 로그인 실패 반복, 존재하지 않는 계정으로 로그인 시도, 특정 폼 무한 제출, 예약 시스템에서 매크로를 이용한 자리 선점.

-

의심스러운 URL 요청: 웹사이트에 존재하지 않는 알려진 취약점 경로(예:

/wp-admin/,/phpmyadmin/,.env파일 등)에 대한 반복적인 접근 시도. -

HTTP 헤더 분석: 비정상적인 HTTP 헤더 조합이나 순서, 헤더 누락 등.

-

-

악성 봇 행위 패턴화 예시:

로그에서 발견되는 악의적인 봇의 구체적인 행위 패턴들을 파악하고 이를 기반으로 방어 로직을 구현해야 합니다.

-

GET /cgi-bin/luci/;stok=.../shell?cmd=RCE- 설명:

OpenWrt관리자 패널의 원격 코드 실행(RCE) 취약점을 노린 공격 시도입니다. 공유기나 임베디드 장치에서 주로 사용되는 리눅스 기반 시스템의 취약점을 탐색합니다.

- 설명:

-

POST /wp-login.php(반복적인 로그인 시도)- 설명: 워드프레스 관리자 페이지에 대한 무차별 대입(Brute-force) 공격 또는 자격 증명 스터핑 시도입니다.

-

GET /HNAP1/- 설명: D-Link 공유기에서 발견되었던 HNAP1(Home Network Administration Protocol) 취약점을 노린 스캔 및 공격 시도입니다.

-

GET /boaform/admin/formLogin- 설명: 오래된 라우터나 웹캠 등에 사용되는

Boa웹 서버의 관리자 로그인 패널 침입 시도입니다.

- 설명: 오래된 라우터나 웹캠 등에 사용되는

-

GET /.env또는GET /.git/config- 설명:

.env파일(환경 변수)이나.git디렉터리에 대한 접근을 통해 민감한 정보를 탈취하려는 시도입니다.

- 설명:

이러한 패턴들을 감지하면 해당 요청을 차단하거나, 임시적으로 IP를 블랙리스트에 추가하는 등의 조치를 취할 수 있습니다. 이는 서버단에서 미들웨어(예: Django 미들웨어)나 웹 서버 설정(Nginx

map모듈, Apachemod_rewrite등)을 통해 구현될 수 있습니다. -

-

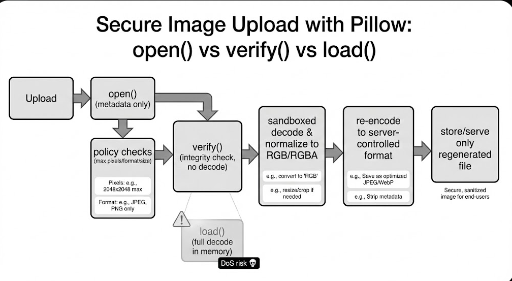

JavaScript 실행 여부 검사:

대부분의 악성 봇은 실제 브라우저처럼 JavaScript를 완벽하게 실행하지 않습니다. 숨겨진 JavaScript 코드(예: 특정 DOM 요소 클릭 유도), canvas 핑거프린팅, 또는 브라우저 API 호출 여부 등을 통해 봇 여부를 판별하고, JavaScript 실행에 실패하는 클라이언트를 차단하는 방법이 있습니다.

4. Honeypot (함정) 활용

허니팟(Honeypot) 은 악의적인 봇을 유인하고 식별하기 위한 의도적인 '함정'입니다. 정상적인 사용자에게는 보이지 않지만, 자동화된 봇이 탐색하거나 상호작용하도록 설계된 요소들을 웹 페이지에 숨겨둡니다.

-

작동 원리:

-

숨겨진 링크/필드: CSS(

display: none;,visibility: hidden;,height: 0;등)를 이용하거나, JavaScript로 동적으로 생성한 후 화면 밖으로 이동시켜 사용자에게는 전혀 보이지 않는 링크나 폼 필드를 생성합니다. -

봇의 행동 유도: 정상적인 웹 브라우저를 사용하는 사람은 이 요소를 볼 수 없으므로 상호작용할 수 없습니다. 하지만 웹 페이지의 모든 링크나 폼을 기계적으로 파싱하는 악성 봇은 이 숨겨진 요소를 발견하고 상호작용하려 시도합니다 (예: 숨겨진 폼 필드에 값을 입력하거나, 숨겨진 링크를 클릭).

-

악성 봇 식별: 숨겨진 필드에 값이 입력되거나, 숨겨진 링크로 접근하는 요청이 발생하면, 이는 명백히 악성 봇에 의한 행동으로 간주할 수 있습니다.

-

자동 차단: 이러한 행동이 감지된 IP 주소나 세션은 즉시 블랙리스트에 추가하거나 차단하는 조치를 취합니다.

-

-

구현 예시:

<form action="/submit" method="post">

<label for="username">사용자 이름:</label>

<input type="text" id="username" name="username">

<div style="position: absolute; left: -9999px;">

<label for="email_hp">이 필드는 비워두세요:</label>

<input type="text" id="email_hp" name="email_hp">

</div>

<label for="password">비밀번호:</label>

<input type="password" id="password" name="password">

<button type="submit">로그인</button>

</form>

서버에서는 `email_hp` 필드에 값이 있다면 해당 요청을 봇으로 판단하고 차단합니다.

- 장점: 사용자 경험을 저해하지 않으면서 악성 봇만을 효과적으로 식별할 수 있습니다. 비교적 구현이 간단하며, 위조가 어렵습니다.

5. 웹 애플리케이션 방화벽 (WAF) 및 전문 봇 관리 솔루션

대규모 웹사이트나 민감한 서비스를 운영한다면 전문적인 WAF 솔루션(Cloudflare, AWS WAF, Sucuri 등)이나 봇 관리 솔루션(Cloudflare Bot Management, Akamai Bot Manager, PerimeterX 등)을 사용하는 것이 가장 효과적입니다. 이러한 솔루션들은:

-

고급 행위 분석: 머신러닝 기반으로 실시간 트래픽을 분석하여 인간과 봇의 미묘한 행동 차이를 감지합니다.

-

위협 인텔리전스: 전 세계적인 공격 패턴과 IP 블랙리스트 데이터베이스를 활용하여 광범위한 위협을 식별합니다.

-

오차단 최소화: 정교한 알고리즘을 통해 유익한 봇과 정상 사용자에 대한 오차단을 최소화하면서 악의적인 봇만을 걸러냅니다.

-

자동화된 대응: 탐지된 악성 봇에 대해 자동으로 차단, 챌린지 제공 등의 조치를 취합니다.

결론: 능동적이고 다층적인 봇 방어 전략

악의적인 봇은 끊임없이 진화하며 웹사이트를 공격하려 합니다. robots.txt는 정직한 봇을 위한 지침일 뿐, 침입자를 막는 방패가 될 수는 없습니다. 따라서 웹사이트의 보안과 안정성을 위해선 봇의 행동을 분석하고 식별하여 악의적인 봇만을 선별적으로 차단하는 능동적이고 다층적인 방어 전략이 필수적입니다.

로그 분석을 통한 비정상 행위 패턴화, 요청 속도 제한의 정교한 설정, 허니팟을 이용한 함정 설치, 그리고 필요하다면 전문 봇 관리 솔루션이나 WAF의 도입을 통해 웹사이트를 더욱 안전하게 보호하고, 유익한 봇과의 원활한 상호작용을 유지하면서 사용자에게 쾌적한 서비스를 제공할 수 있을 것입니다. 여러분의 웹사이트는 어떤 봇 위협에 가장 취약한가요? 적절한 방어 전략을 고민해 볼 시점입니다.

댓글이 없습니다.