RTX 4090과 DGX Spark, 무엇이 다른가 – 온프레미스 AI 인프라를 고민하는 기업을 위한 비교 분석

최근 AI 인프라 구축을 고민하고 있는 기업이나 개발자라면, 한 번쯤은 고민했을 것입니다. “지금 RTX 4090으로도 충분한데, DGX Spark가 과연 필요할까?”

이 글은 그 질문에 대한 조심스러운 탐구입니다. 저 또한 현재 DGX Spark를 예약해 놓고 배송을 기다리는 입장으로서, RTX 4090 기반 환경을 쓰며 느꼈던 한계와 기대를 바탕으로 정리해봤습니다.

GPU 서버 vs 고성능 워크스테이션 – 어떤 인프라가 AI 최적화에 적합한가?

| 구분 | RTX 4090 워크스테이션 | DGX Spark |

|---|---|---|

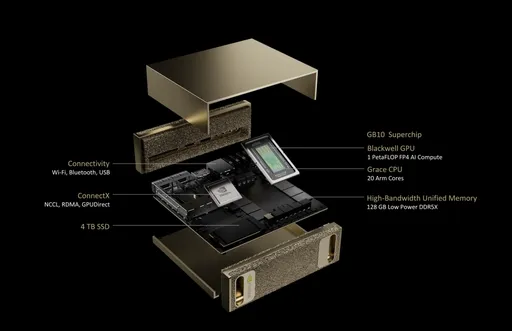

| GPU 아키텍처 | Ada Lovelace | NVIDIA Blackwell |

| CPU | 외부 CPU 사용 | 20코어 Arm (10×Cortex-X925 + 10×Cortex-A725) |

| 메모리 | 24GB GDDR6X | 128GB LPDDR5x (통합 메모리) |

| 메모리 대역폭 | 1,008 GB/s | 273 GB/s |

| 저장장치 | 사용자 구성 SSD | 1TB 또는 4TB NVMe M.2 (암호화 지원) |

| 네트워크 | 옵션 | 10GbE + ConnectX-7 Smart NIC |

| 전력 소비 | 약 450W~600W | 170W |

| 시스템 크기 | ATX 또는 타워형 | 150 x 150 x 50.5 mm (1.2kg) |

| 운영체제 | Windows 또는 Linux 사용자 설치 | NVIDIA DGX Base OS (Ubuntu 기반) |

▶ 핵심 차이: 단순한 성능보다도 "AI용으로 설계되었느냐"가 핵심입니다.

산업계에서 중요한 차이: 온프레미스 AI 인프라 최적화

AI 인프라 도입을 고려하는 기업이 중점적으로 보는 것은 단순한 연산 속도가 아닙니다. 다음과 같은 산업 맞춤형 차이점이 실제 선택의 기준이 됩니다:

- AI 데이터 보안 및 데이터 주권: 클라우드로 보낼 수 없는 데이터 처리에 필수

- 엣지 AI 배포: 제조/금융/의료 분야의 프라이빗 GPU 서버 수요 급증

- AI 추론 안정성: 서버급 전력 설계로 24/7 추론 운영 가능

- 클러스터 통합: Grace CPU + Blackwell GPU의 구조는 단일 머신으로 고밀도 연산 수행 가능

이런 측면에서 DGX Spark는 단순한 GPU 장비가 아니라 프라이빗 AI 인프라 솔루션입니다.

총소유비용(TCO)과 투자 효율 – 온프레미스 AI 인프라의 ROI는?

| 비교 항목 | RTX 4090 단일 시스템 | DGX Spark |

|---|---|---|

| 초기 장비 가격 | 약 $3,500 ~ $5,000 | $4,000 (NVIDIA 공식 발표 기준) |

| 운영비 | 전력, 발열 고려해 자가 관리 | ARM 기반 저전력 설계로 전력 효율 및 유지비 절감 |

| 투자 대상 | 개인 또는 소규모 실험 | 기업용 모델 학습/추론 플랫폼 |

▶ 가격은 비슷하거나 DGX Spark가 더 낮은 수준이지만, 운영 효율성과 시스템 통합 가치까지 고려하면 장기적인 총소유비용(TCO)에서 경쟁력이 큽니다.

개인 개발자? 스타트업? 누구에게 더 적합할까?

- RTX 4090이 더 적합한 경우:

- 모델 크기가 작고, 개인 학습 및 실험 위주

- 클라우드와 혼합 사용하는 개발자

-

비용 민감한 프리랜서/연구자

-

DGX Spark가 적합한 경우:

- LLM 사내 배포/튜닝, 데이터 주권 보호가 필요한 기업

- 클라우드 대비 ROI를 높이고 싶은 산업 사용자

- 24시간 추론 서비스를 자체 운영하고자 하는 팀

결론: 지금은 "대기 중"이지만, 선택의 기준은 분명하다

RTX 4090은 지금도 충분히 훌륭한 GPU입니다. 하지만 저는 DGX Spark가 가져올 "AI 서버의 표준화"를 기대하며 기다리는 중입니다.

단순히 더 빠른 속도보다 중요한 건: - 어떤 시스템을 기반으로 AI를 운용할 것인가 - 얼마나 안전하게, 지속 가능하게, 비용 효율적으로 AI 인프라를 구축할 것인가입니다.

앞으로 직접 사용기를 남길 날을 기다리며, 이 비교가 현명한 선택의 기준이 되기를 바랍니다.

댓글이 없습니다.