로컬 환경에서 LLM(Large Language Model)을 구동하는 경험은 하드웨어 스펙에 따라 극명하게 나뉩니다. 지난 몇 년간 중급 사양의 PC에서 GGUF 모델을 돌리며 느꼈던 한계, 그리고 고성능 워크스테이션인 Spark(DGX Spark)를 도입한 후 변화된 로컬 AI 연구 환경에 대한 경험을 공유하고자 합니다.

1. GGUF 시대: 타협과 효율의 미학

Spark를 도입하기 전, 제 메인 장비는 i7 12700F CPU, 32GB RAM, 그리고 RTX 2060 12GB였습니다. 이 사양에서 거대 언어 모델을 돌리기 위한 선택지는 단 하나, GGUF(GPT-Generated Unified Format) 였습니다.

양자화(Quantization)의 늪

당시 모델을 선택하는 기준은 성능보다는 '구동 가능 여부'였습니다. Hugging Face를 뒤질 때면 습관적으로 GGUF 태그를 검색했고, 그중에서도 Q4_K_M 포맷을 찾아 헤맸습니다.

- Q4_K_M: 모델의 파라미터를 4비트로 압축하여 메모리 사용량을 줄이면서도 성능 저하를 최소화한 포맷.

RTX 2060의 12GB VRAM은 7B 모델을 겨우 올리거나, 시스템 램으로 오프로딩(Offloading)하여 느린 속도를 감내해야 했습니다. "돌아간다"는 사실 자체에 만족하며 재미를 느꼈지만, 이는 명백히 타협된 환경이었습니다.

2. 단순 추론(Inference)의 한계와 회의감

GGUF를 통해 로컬에서 LLM을 구동하는 것은 흥미로웠지만, 곧 근본적인 의문에 봉착했습니다.

"단지 추론만 할 것이라면, 온프레미스 환경이 꼭 필요한가?"

단순히 질의응답을 하고 텍스트를 생성하는 것이 목적이라면, 이미 세상에는 압도적인 성능을 자랑하는 Google Gemini나 OpenAI GPT가 존재합니다. 연구용 API 비용이 개인 워크스테이션 구축 비용보다 훨씬 저렴할 수도 있습니다. 학습이나 커스텀 없이 남이 만든 모델을 다운로드하여 실행만 하는 것(Inference Only)은 로컬 환경 구축의 당위성을 약하게 만들었습니다.

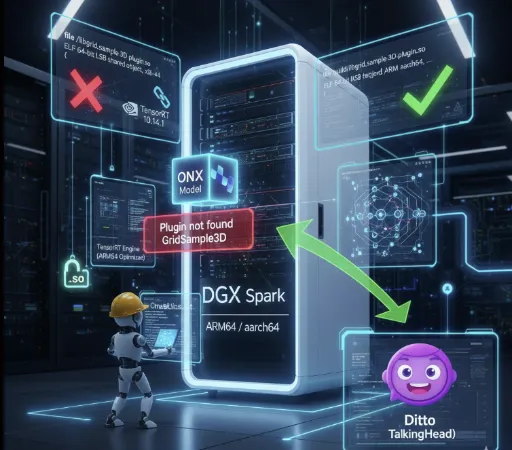

3. Spark 도입과 FP16의 세계

약 4,000달러를 투자하여 Spark 머신을 도입한 후, 제 AI 연구 환경은 완전히 달라졌습니다. 가장 먼저 변한 것은 모델을 대하는 태도입니다.

Safetensors와 Full Precision

더 이상 GGUF를 찾지 않습니다. 이제는 FP16(Half Precision) 기반의 .safetensors 원본 모델을 그대로 다운로드합니다.

속도와 퀄리티: 양자화 손실 없는 원본 모델의 추론 퀄리티는 확실히 다릅니다. 게다가 고성능 GPU 덕분에 추론 속도 또한 쾌적합니다.

- 실제 속도 차이는 극명합니다.

- RTX 2060 환경: Mistral 7B GGUF Q4_K_M → 약 10–20 tokens/s

- Spark 환경 (GPT-OSS-20B FP16): 약 80–90 tokens/s

- Spark 환경 (GPT-OSS-120B FP16): 약 40–50 tokens/s

같은 가격대의 노트북·PC에서는 불가능한 수준의 속도로, 양자화 손실 없이 FP16 모델을 그대로 사용해도 이 정도 추론 성능이 나온다는 점이 로컬 AI 연구 패러다임을 완전히 바꾸었습니다.

유연한 양자화: 필요하다면 제가 직접 FP8이나 FP4로 양자화를 시도합니다. 누군가 변환해 둔 파일을 쓰는 것이 아니라, 제 연구 목적에 맞춰 직접 제어할 수 있게 된 것입니다.

4. 진정한 가치: LoRA 파인튜닝 (Fine-Tuning)

Spark 도입이 "정말 잘한 결정"이라고 생각하는 핵심 이유는 바로 학습(Training) 의 영역으로 진입했기 때문입니다.

이전 사양에서는 추론조차 버거워 파인튜닝은 꿈도 꿀 수 없었습니다. 하지만 이제는 이론으로만 공부했던 LoRA(Low-Rank Adaptation) 를 직접 수행할 수 있습니다.

-

실전 경험: 데이터셋을 준비하고, 하이퍼파라미터를 조정하며 모델을 미세 조정하는 과정은 단순 추론과는 비교할 수 없는 깊이의 경험을 제공합니다.

-

나만의 모델: 범용 모델이 아닌, 특정 도메인이나 나의 문체에 특화된 모델을 만들 수 있다는 점이 온프레미스 환경의 진짜 매력입니다.

추론을 넘어 학습까지 가능한 환경, 이것이 4,000달러라는 비용이 아깝지 않은 이유입니다.

5. 여전히 유효한 GGUF의 가치

물론, 제 환경이 변했다고 해서 GGUF의 가치를 부정하는 것은 아닙니다.

GGUF의 본질은 ‘절대적인 성능’이 아니라 접근성에 있습니다.

고가 GPU 없이도 CPU·저사양 GPU만으로 대형 언어 모델을 구동할 수 있게 해주는 거의 유일한 포맷이죠. 대신, 양자화 특성상 정밀도 손실과 추론 품질 저하, 그리고 긴 문맥 처리에서의 불안정성은 피할 수 없습니다. 즉 GGUF는 “누구나 돌릴 수 있는 모델”이라는 장점과, “품질·속도·일관성의 한계”라는 양면성을 동시에 가진 포맷입니다.

그리고 GGUF는 여전히 AI 민주화 측면 에서 훌륭한 포맷입니다. 모든 사용자가 파인튜닝을 필요로 하지 않으며, 고가의 장비를 갖출 수도 없습니다. 라이트 유저에게 표준화된 환경에서 최적의 추론 성능을 제공하는 GGUF 생태계는 앞으로도 개인 PC 성능의 발전과 함께 더욱 대중화될 것이라고 생각합니다. 몇년 후에는 태블릿pc나 우리의 휴대전화에서 gguf 포맷의 모델이 운영되고 있을지도 모릅니다.

마치며

RTX 2060에서 Q4_K_M 모델을 돌리던 시절이 '맛보기'였다면, Spark와 함께하는 지금은 '요리'를 하는 기분입니다.

로컬 AI의 세계는 단순히 모델을 돌리는 것을 넘어, 모델을 이해하고 수정하고 내 것으로 만드는 과정에서 진정한 즐거움을 찾을 수 있습니다. 만약 여러분이 단순 추론을 넘어 모델의 구조적 이해와 커스텀에 갈증을 느끼고 있다면, 하드웨어 투자는 그 갈증을 해소해 줄 가장 확실한 열쇠가 될 것입니다.

댓글이 없습니다.